[翻译]机器学习是什么?

来源:互联网 发布:航旅纵横网络异常 编辑:程序博客网 时间:2024/04/24 00:03

本文翻译的是这篇文章

有些读者看来本文的标题可能会认为本文介绍的是一些新的知识,但是事实上本文介绍的技术和计算机科学一样老.

阿兰-图灵,毫无疑问是有史以来最有影响力的计算机科学家,在他的1950年关于计算机的论文中提出”机器能够思考吗?”从科学小说到科研实验室,长久以来我们都在问一个问题:我们自身的创造性是否会在某种程度上帮助我们揭开我们拥有的意识的起源,或者广泛的来说,我们在地球上扮演的角色.不幸的是,AI的学习曲线实在是陡峭(就是说研究AI很难的意思).通过回顾了大量的历史,我们应该对能够探究到什么是机器学习的本质充满希望.

是否拥有了足够海量的数据就能够创造智能?

我们首先尝试复制我们自身(充满信息的混乱机器)并且希望得到最好的(结果).严格的来说,曾经在某一段时间,先前的理论认为大量的信息连接在一起就会产生意识.很多人把谷歌视为这个观点的巅峰,但是当公司索引了30万亿的网页的时候,我不认为有人会期待我们的搜索引擎开始询问我们是否真的有上帝.

相反的,机器学习的魅力在于不是假装计算机是人,让他们简单地反馈知识.我们发展电脑技术的原因,是让他们通过我们已有的知识推理新知识.

在理解不是很深的时候,大家都认为神经网络,深度学习,增强学习都是机器学习.上述都是创建能在新数据上进行分析的推理系统的方法.换句话说,机器学习是一系列人工智能技术,神经网络和深度学习仅仅是用于构建更好的框架和更广泛的应用程序的工具.

回到1952年,Arthur Samue写了一个国际象棋的程序,用的一个叫做alpha beta pruning的基本的AI形式.这个方法能够减少对数据生成的搜索树进行搜索时的计算负荷,但是这不总是解决问题的最好策略.甚至神经网络也出现在了昔日Frank Rosenblatt的感知器中.

一个必读的复杂探测模型

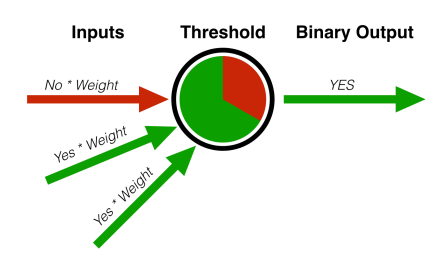

感知器比它的历史还要久,利用神经科学推动机器学习的发展.在论文中,感知器的模型一般如上图所示.

要了解感知器做了什么,首先需要了解大多数机器学习问题能够分为两类:分类和回归.分类器用来划分数据,而回归模型广泛的用于处理推导趋势并进行预言.

感知器是分类的一个实例 — 它处理了大量数据并把它们分为多个集合.基于此,它们的两个拥有各自权重的特点的存在足够将这个对象分为”绿色”目录.分类器在今天多用于区分垃圾邮件或者银行业的欺诈检测.

Rosenblatt的模型使用了一系列的输入,抽象出特征比如长度,重量,颜色,然后为每一个特征赋予一个权重.这个模型会持续的调整这些权重,直到输出收敛到误差在允许的范围内.

比如说,假设输入的物体的重量如果是100克,那么这个物体就是苹果.计算机不知道它是一个苹果,但是感知器能够通过已知的训练数量集调整分类器的重量来识别这个物体是一个类似苹果的物体或者不是苹果的物体.一旦分类器训练完成,它能够重用于全新的数量集,并对其中的物体进行分类.

AI研究的关键之处

感知器只是机器学习中早期众多进展中的一个.神经网络类似大量一起工作的感知器集合,就像我们的大脑和神经一样工作,也因这个特点而得名.

几十年前,AI的发展一直是在复制心灵工作的方式而不是简单的复制我们感知它的内容.基本的或者浅层的神经网络到今天都还在应用,但是深度学习的发展已经追上并将是以后的重要方向.深度学习模型就是多层的神经网络.对于这个难以置信的不满的解释的一个完全合理的反应就是提出”层”是什么意思.

为了便于理解,我们必须记住的是只是因为我们说计算机能够识别猫和人类两个不同的集合,但是计算机自身处理这个任务跟人类的方式不一样.机器学习框架利用这个抽象的概念去完成任务.

对于人类,脸上有眼睛.对于计算机,脸由亮和暗的像素组成一些抽象的线条.深度学习模型的每一层使得计算机识别另一层对同一物体的抽象.像素汇集成线,线组成2d,2d组成3d.

通过图灵测试

人和计算机对这个世界的评价的本质不同对实现真正的人工智能提出严峻的挑战.图灵测试被用来评估我们在AI领域的进展,但是这个测试很大程度上忽略了事实.图灵测试是行为测试,关注于计算机模仿人类的能力.

但而,模拟和概率推理仅仅只是智能和意识领域的部分理论.一些人认为我们在2014年成功的通过了图灵测试,当一台机器使得30个人中的20个人相信他们5分钟内进行打字交流的对象是人类(但是Siri依然在我们询问他第三方事情的时候使用谷歌搜索).

AI寒冬

尽管AI在进步,科学家和企业家对AI的能力过度自信了.过度繁荣和打破平衡导致的结果就是AI寒冬.

我们一定可以用机器学习做许多难以置信的事情,比如说从视频画面中分辨物体,自动驾驶,通过卫星图像预测庄稼产量.长期短期记忆帮助我们的机器处理时间序列的事情,比如对视频进行情绪分析.增强学习,从游戏理论中受启发,包含了一套工具用来通过奖励来帮助学习.增强学习是阿尔法狗能够战胜Lee Sodol的一个关键部分.

也就是说,尽管所有都进步了,机器学习的最大秘密就是对于给定的问题,我们通常知道输入和输出,明确的编程代码作为媒介,我们不能经常区分这个模型从输入到输入是如何工作的.研究者把机器学习的这个挑战称为黑盒子问题.

在丧气之前,我们必须记住,人类的大脑自身就是一个黑盒子.我们事实上不知道人脑是如何工作的,并且不能在所有抽象的等级上进行检查.如果我要求你解剖你的大脑并指出其中保存的记忆,你可能认为我是疯子.然而,没有能力理解某些事情不是游戏结束,而是游戏的开始.

本文介绍了很多机器学习的基本概念,但是也留下了未来会怎样的一些片段.深度学习,增强学习和神经网络都可以独立存在,但读完这篇文章之后希望读者能够对这个领域有直观的了解.

- [翻译]机器学习是什么?

- 机器学习是什么--周志华

- 机器学习是什么

- 机器学习是什么

- 机器学习是什么--周志华

- 机器学习是什么--周志华

- 机器学习是什么

- 机器学习是什么?

- 机器学习是什么--周志华

- 机器学习是什么

- 机器学习是什么

- 机器学习是什么?

- 机器学习-斯坦福大学翻译

- 机器学习的本质是什么?

- 刘铁岩:博弈机器学习是什么?

- 通过身边小事解释机器学习是什么?

- 通过身边小事解释机器学习是什么?

- 通过身边小事解释机器学习是什么?

- MySQL基础语句值DML语句

- 说说JSON和JSONP,跨域请求

- Fragment 嵌套Fragment注意事项

- Invoke interface method 'java.lang.Object[]java.util.Collection.toArray()'on a null object reference

- Python抓取第一网贷中国网贷理财每日收益率指数

- [翻译]机器学习是什么?

- 一些简单方法记录

- npm 安装出现npm WARN file-explorer@0.0.1 No repository field or no license field

- Hibernate4:遇到无法建表问题 Unsuccessful: create table

- (46)Java学习笔记——多线程 / 线程的生命周期

- 禁止input输入框的鼠标滚轮事件详解

- bzoj4514: [Sdoi2016]数字配对

- HiKey试用体验 烧写系统至Flash之诡异事件

- 视频电商网站实战 - 视频上传:标签编辑框效果快速实现