一维OTSU法、最小交叉熵法、二维OTSU法及C++源码

来源:互联网 发布:淘宝排名收费 编辑:程序博客网 时间:2024/06/18 15:47

1.最大类间方差法(Otsu法)

该算法是日本人Otsu提出的一种动态阈值分割算法。它的主要思想是按照灰度特性将图像划分为背景和目标2部分,划分依据为选取门限值,使得背景和目标之间的方差最大。(背景和目标之间的类间方差越大,说明这两部分的差别越大,当部分目标被错划分为背景或部分背景错划分为目标都会导致这两部分差别变小。因此,使用类间方差最大的分割意味着错分概率最小。)这是该方法的主要思路。其主要的实现原理为如下:

1)建立图像灰度直方图(共有L个灰度级,每个出现概率为p)

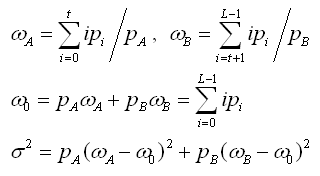

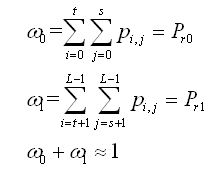

2)计算背景和目标的出现概率,计算方法如下:

上式中假设t为所选定的阈值,A代表背景(灰度级为0~N),根据直方图中的元素可知,Pa为背景出现的概率,同理B为目标,Pb为目标出现的概率。

3)计算A和B两个区域的类间方差如下:

第一个表达式分别计算A和B区域的平均灰度值;

第二个表达式计算灰度图像全局的灰度平均值;

第三个表达式计算A、B两个区域的类间方差。4)以上几个步骤计算出了单个灰度值上的类间方差,因此最佳分割门限值应该是图像中能够使得A与B的类间灰度方差最大的灰度值。在程序中需要对每个出现的灰度值据此进行寻优。

以下对两个不同类型的图像采用最大类间方差法寻找最优阈值进行分割:

C++源码:

#include "stdio.h" #include "cv.h" #include "highgui.h" #include "Math.h" #include <tchar.h> int Otsu(IplImage* src);int _tmain(int argc, _TCHAR* argv[]){IplImage* img = cvLoadImage("E:\\11.jpg", 0);IplImage* dst = cvCreateImage(cvGetSize(img), 8, 1);int threshold = Otsu(img);cvThreshold(img, dst, threshold, 255, CV_THRESH_BINARY);cvNamedWindow("img", 1);cvShowImage("img", dst);cvWaitKey(-1);cvReleaseImage(&img);cvReleaseImage(&dst);cvDestroyWindow("dst");return 0;}int Otsu(IplImage* src){int height = src->height;int width = src->width;double nHistogram[256]; //灰度直方图 double dVariance[256]; //类间方差 int N = height*width; //总像素数 for (int i = 0; i<256; i++){nHistogram[i] = 0.0;dVariance[i] = 0.0;}for (int i = 0; i<height; i++){unsigned char* nData = (unsigned char*)src->imageData + src->widthStep * i;for (int j = 0; j < width; j++){nHistogram[*nData++]++; //建立直方图}}double Pa = 0.0; //背景出现概率 double Pb = 0.0; //目标出现概率 double Wa = 0.0; //背景平均灰度值 double Wb = 0.0; //目标平均灰度值 double W0 = 0.0; //全局平均灰度值 double dData1 = 0.0, dData2 = 0.0;int nThreshold;for (int i = 0; i<256; i++) //计算全局平均灰度 {nHistogram[i] /= N;W0 += i*nHistogram[i];}for (int i = 0; i<256; i++) //对每个灰度值计算类间方差 {Pa += nHistogram[i];Pb = 1 - Pa;dData1 += i*nHistogram[i];dData2 = W0 - dData1;Wa = dData1 / Pa;Wb = dData2 / Pb;dVariance[i] = (Pa*Pb* pow((Wb - Wa), 2));}//遍历每个方差,求取类间最大方差所对应的灰度值 double temp = 0.0;for (int i = 0; i<256; i++){if (dVariance[i]>temp){temp = dVariance[i];nThreshold = i;}}printf("threshold = %d\n", nThreshold);return nThreshold;}

以上是采用最大类间方差法进行最优阈值分割的结果,可以看出原图采用不同尺寸的彩色图像和灰度图像,处理之后的效果有显著的差别。

2.最小交叉熵法

这种方法与类间最大方差很相似,是由Li和Lee应用了信息论中熵理论发展而来。首先简要介绍交叉熵的概念。

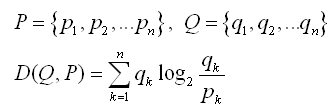

对于两个分布P和Q,定义其信息交叉熵D如下:

这代表的物理意义是两个分布之间信息理论距离,另外一种理解是,将分布P变为Q后所带来的信息变化。那么对于图像分割来说,如果要用分割图像来替换原来的图像,最优的分割依据应该就是使得两幅图像之间的交叉熵最小。以下对最小交叉熵法的过程进行简要总结。

可以假设上文的P为源图像的灰度分布,Q为所得到的分割图像的灰度分布,其中:

上式中H为统计直方图;

N为图像总的像素点数;

L为源图像总的灰度级数;

P代表源图像,其每个元素代表每个灰度级上的灰度分布(平均灰度值);

Q为分割后的二值图像,两个u分别代表两个分割后的区域的平均灰度值,其中t为分割图像所采用的阈值。

根据以上定义,以每个灰度级上的灰度和为计算量,可以很容易根据交叉熵的公式,推导出P和Q之间的交叉熵定量表达式:

根据上文所述思路,使得D最小的t即为最小交叉熵意义下的最优阈值。

以下采用最小交叉熵法对彩色图像和灰度图进行阈值化分割:

源码:

int MiniCross(IplImage* src){int height = src->height;int width = src->width;double dHistogram[256]; //灰度直方图 double dEntropy[256]; //每个像素的交叉熵 int N = height*width; //总像素数 for (int i = 0; i<256; i++){dHistogram[i] = 0.0;dEntropy[i] = 0.0;}for (int i = 0; i<height; i++){unsigned char* nData = (unsigned char*)src->imageData + src->widthStep * i;for (int j = 0; j < width; j++){dHistogram[*nData++]++; //建立直方图}}double Pa = 0.0; //区域1平均灰度值 double Pb = 0.0; //区域2平均灰度值 double P0 = 0.0; //全局平均灰度值 double Wa = 0.0; //第一部分熵 double Wb = 0.0; //第二部分的熵 double dData1 = 0.0, dData2 = 0.0; //中间值 double dData3 = 0.0, dData4 = 0.0; //中间值 int nThreshold;for (int i = 0; i<256; i++) //计算全局平均灰度 {dHistogram[i] /= N;P0 += i*dHistogram[i];}for (int i = 0; i<256; i++){Wa = Wb = dData1 = dData2 = dData3 = dData4 = Pa = Pb = 0.0;for (int j = 0; j<256; j++){if (j <= i){dData1 += dHistogram[j];dData2 += j*dHistogram[j];}else{dData3 += dHistogram[j];dData4 += j*dHistogram[j];}}Pa = dData2 / dData1;Pb = dData4 / dData3;for (int j = 0; j<256; j++){if (j <= i){if ((Pa != 0) && (dHistogram[j] != 0)){double d1 = log(dHistogram[j] / Pa);Wa += j*dHistogram[j] * d1 / log(2);}}else{if ((Pb != 0) && (dHistogram[j] != 0)){double d2 = log(dHistogram[j] / Pb);Wb += j*dHistogram[j] * d2 / log(2);}}}dEntropy[i] = Wa + Wb;}//遍历熵值,求取最小交叉熵所对应的灰度值 double temp = dEntropy[0];for (int i = 1; i<256; i++){if (dEntropy[i]<temp){temp = dEntropy[i];nThreshold = i;}}printf("threshold = %d\n", nThreshold);return nThreshold;}

以上是最小交叉熵法寻找最优阈值后处理得到的分割图像,可以看出,彩色图像处理后轮廓信息基本已经消失,灰度图像经最小交叉熵处理后的效果与采用最大类间方差处理后得到的分割图像效果相似。

3.二维OTSU法

这种方法是对类间最大方差法的扩展,将其从求两个一维分布最大类间方差扩充为求解类间离散度矩阵的迹的最大值,考虑像素点灰度级的基础上增加了对像素点邻域平均像素值的考虑。

以下按照本人的理解对该方法的思路以及推倒过程进行分析:

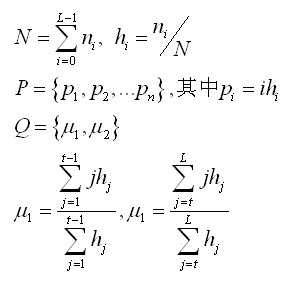

1)首先需要建立二维的灰度统计直方图P(f, g);

图像的灰度级为L级,那么其每个像素点的8邻域灰度平均值的灰度级也为L级,据此来构建直方图P。二维统计直方图的横轴为每个像素点的灰度值f(i, j),纵坐标为同一个点对应的邻域平均值g(i, j) 其中(0≤i<height, 0≤j<width, 0≤f(i, j)<L),而所对应的P(f,g)整幅图像中灰度值为f,邻域灰度均值为g的点的统计值占总像素点的比例(即为灰度值出现的联合概率密度)。其中P的每个元素满足如下公式:

n为整幅图像中灰度值为f,邻域灰度均值为g的点的统计值;

N为图像总的像素点个数;

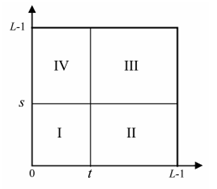

2)对于下图所示的二维统计直方图,t代表横坐标(灰度值),s代表纵坐标(像素点邻域的灰度均值)

对已图像中的阈值点(t,s)来说,其灰度值t和其邻域内的灰度均值s不应该相差太多,如果t比s大很多(点位于上图中的II区域),说明像素的灰度值远远大于其临域的灰度均值,故而该点很可能是噪声点,反之如果t比s小很多(点位于途中的IV区域),即该点的像素值比其临域均值小很多,则说明是一个边缘点。据此我们在进行背景前景分割的时候忽略这些干扰因素,认为这两个区域内Pi,j=0。剩下的I区域和III区域则分别代表了前景和背景。以下据此来推导对于选定的阈值(t, s),进行离散度判据的最优推导。

3)推导阈值(t, s)点处的离散度矩阵判据

根据上文分析可知,由阈值(t, s)所分割的前景和背景出现的概率如下:

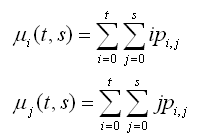

定义两个中间变量,方便下面推导:

据此,这两部分的灰度均值向量可以推导如下(两个分量分别根据灰度值以及每个点的灰度均值计算):

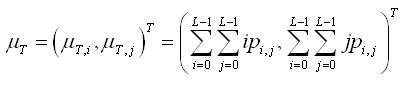

整幅图像的灰度均值向量为:

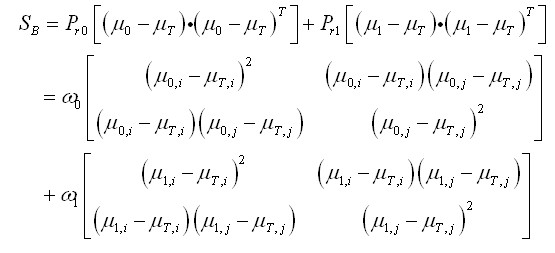

与一维的大津法一样的思路,推导类间方差,这里是二维因此要用矩阵形式。参考一维法,可同样定义类间“方差”矩阵如下:

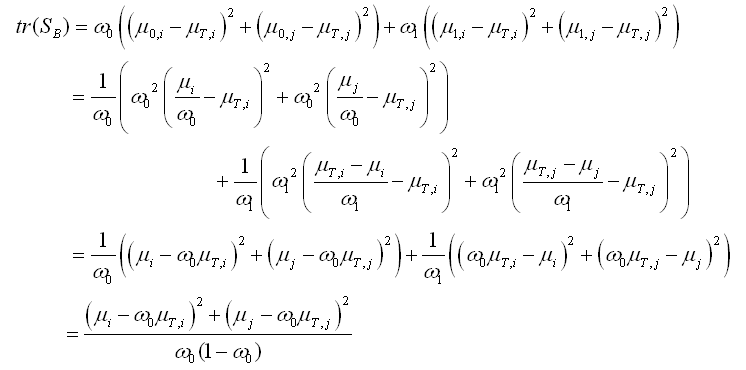

为了在实现的时候,容易判断出这样一个矩阵的“最大值”,因此数学中采用矩阵的迹(对角线之和)来衡量矩阵的“大小”。因此以该矩阵的迹作为离散度测度,推导如下:

这样就可以通过求解使得这个参数最大时的(t,s)即为所求得的最佳阈值组合。

以下为具体算法实现过程:

1)建立二维直方图

2)对直方图进行遍历,计算每个(t,s)组合所得到的矩阵离散度,也就是一维大津法中所谓的最大类间方差。

3)求得使“类间方差”最大的(t,s),由于t代表灰度值,s代表改点在其邻域内的灰度均值,因此本人认为在选择阈值时可以选择s为最佳,当然用t也可以,因为从求解结果可以看出,这这个数值往往很接近。

具体的实现代码如下:

/****************************************************************************** 函数名称: cvOtsu2D()* 函数参数: CvMat* pGrayMat:灰度图形相对应的矩阵* 返回值: int nThreshold* 函数说明:实现灰度图的二值化分割——最大类间方差法(二维Otsu算法)* 备注:在构建二维直方图的时候,采用灰度点的3*3邻域均值******************************************************************************/#include <opencv2\opencv.hpp> #include <highgui.h> #include <cv.h> #include <iostream> #include <stdio.h> #include<opencv\highgui.h> #include<opencv2\core\core.hpp> #include "math.h" #include <tchar.h> int cvOtsu2D(CvMat *pGrayMat){double dHistogram[256][256]; //建立二维灰度直方图 double dTrMatrix = 0.0; //离散矩阵的迹int height = pGrayMat->rows;int width = pGrayMat->cols;int N = height*width; //总像素数int i, j;for (i = 0; i < 256; i++){for (j = 0; j < 256; j++)dHistogram[i][j] = 0.0; //初始化变量 }for (i = 0; i < height; i++){for (j = 0; j < width; j++){unsigned char nData1 = (unsigned char)cvGetReal2D(pGrayMat, i, j);//当前的灰度值 unsigned char nData2 = 0;int nData3 = 0;//注意9个值相加可能超过一个字节 for (int m = i - 1; m <= i + 1; m++){for (int n = j - 1; n <= j + 1; n++){if ((m >= 0) && (m < height) && (n >= 0) && (n < width))nData3 += (unsigned char)cvGetReal2D(pGrayMat, m, n); //当前的灰度值 }}nData2 = (unsigned char)(nData3 / 9); //对于越界的索引值进行补零,邻域均值 dHistogram[nData1][nData2]++;}}for (i = 0; i < 256; i++)for (j = 0; j < 256; j++)dHistogram[i][j] /= N; //得到归一化的概率分布 double Pai = 0.0; //目标区均值矢量i分量 double Paj = 0.0; //目标区均值矢量j分量 double Pbi = 0.0; //背景区均值矢量i分量 double Pbj = 0.0; //背景区均值矢量j分量 double Pti = 0.0; //全局均值矢量i分量 double Ptj = 0.0; //全局均值矢量j分量 double W0 = 0.0; //目标区的联合概率密度 double W1 = 0.0; //背景区的联合概率密度 double dData1 = 0.0;double dData2 = 0.0;double dData3 = 0.0;double dData4 = 0.0; //中间变量 int nThreshold_s = 0;int nThreshold_t = 0;int nThreshold;double temp = 0.0; //寻求最大值 for (i = 0; i < 256; i++){for (j = 0; j < 256; j++){Pti += i*dHistogram[i][j];Ptj += j*dHistogram[i][j];}}for (i = 0; i < 256; i++){for (j = 0; j < 256; j++){W0 += dHistogram[i][j];dData1 += i*dHistogram[i][j];dData2 += j*dHistogram[i][j];W1 = 1 - W0;dData3 = Pti - dData1;dData4 = Ptj - dData2;Pai = dData1 / W0;Paj = dData2 / W0;Pbi = dData3 / W1;Pbj = dData4 / W1; // 得到两个均值向量,用4个分量表示 dTrMatrix = ((W0 * Pti - dData1) * (W0 * Pti - dData1) + (W0 * Ptj - dData2) * (W0 * Ptj - dData2)) / (W0 * W1);if (dTrMatrix > temp){temp = dTrMatrix;nThreshold_s = i;nThreshold_t = j;}}}nThreshold = (nThreshold_s + nThreshold_t) / 2;//返回阈值,有多种形式,可以单独某一个,也可 //是两者的均值 printf("nThreshold= %d\n", nThreshold);return nThreshold;}int main(){IplImage *img = cvLoadImage("E:\\12.jpg", 0);//加载图片cvNamedWindow("Miss", CV_WINDOW_AUTOSIZE);//创建显示窗口cvShowImage("Miss", img);//显示图片cvNamedWindow("二维Otsu", CV_WINDOW_AUTOSIZE);CvMat *imgMat = cvCreateMat(img->height, img->width, CV_8UC1);//创建矩阵,其type为CV_8UC1cvConvert(img, imgMat);//将图像转换成矩阵形式int t = cvOtsu2D(imgMat);//求二维阈值分割的阈值cvThreshold(img, img, t, 255, CV_THRESH_BINARY);//用求得的阈值分割图像cvShowImage("二维Otsu", img);cvWaitKey(0);//保持图像的显示窗口cvReleaseImage(&img);//释放图像资源cvReleaseMat(&imgMat);//释放矩阵资源cvDestroyAllWindows();//销毁窗口return 0;}

本文理论部分参考自:http://blog.csdn.net/likezhaobin/article/details/6915755

- 一维OTSU法、最小交叉熵法、二维OTSU法及C++源码

- 大律法(OTSU法)

- 大律法(OTSU法)

- cvOtsu2D--最大类间方差法(二维Otsu算法)

- 自动阈值法:Otsu法 用MATLAB实现Otsu算法:

- 二值化之---Otsu法 截图

- otsu

- otsu

- otsu

- otsu

- OTSU

- OTSU一维算法概述

- 最大类间方差法(OTSU)

- 最大类间方差法(大津法,OTSU)

- 最大类间方差法(大津法OTSU)

- 最大类间方差法(OTSU)

- 最大类间方差法(OTSU)

- 最大类间方差法(OTSU)

- activiti在启动的时候报空指针

- 生产环境下重启puma

- echarts图表导出excel示例

- Linux线程编程

- js判断左右上下滑动触发的事件

- 一维OTSU法、最小交叉熵法、二维OTSU法及C++源码

- am335x led驱动。

- mybatis逆向生成 eclipse逆向生成工具mybatis generator使用

- Android中IntentService的原理及使用

- Unity中基于Gpu Instance进行大量物体渲染的实现与分析(一)

- 【组合数学思维】CodeForces

- css

- (多核DSP快速入门)5.SYS/BIOS的使用实例分析

- 【数据科学】当代数据科学家需要掌握的技能