机器学习中的 梯度下降与矩阵方程法

来源:互联网 发布:高中免费视频讲课软件 编辑:程序博客网 时间:2024/05/29 16:41

梯度下降:

1 问题的引出

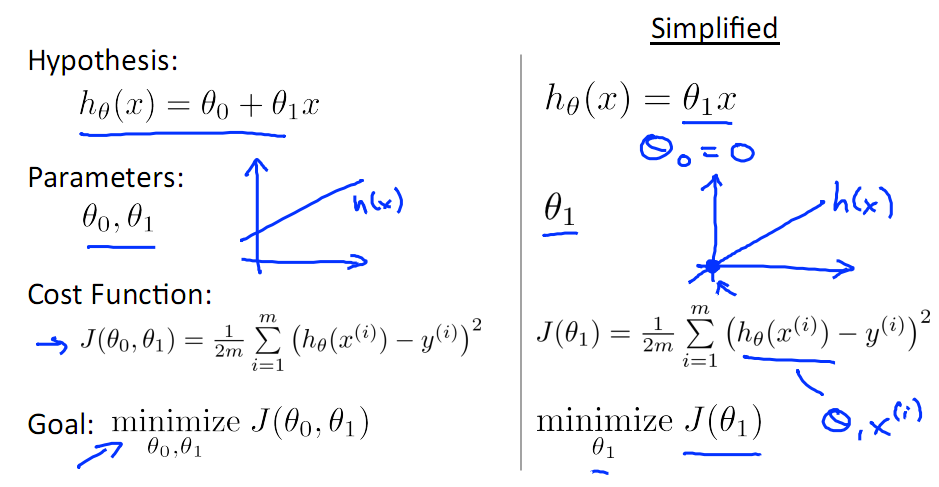

对于线性回归问题,参数为θ1,θ0,损失函数定义如下图所示

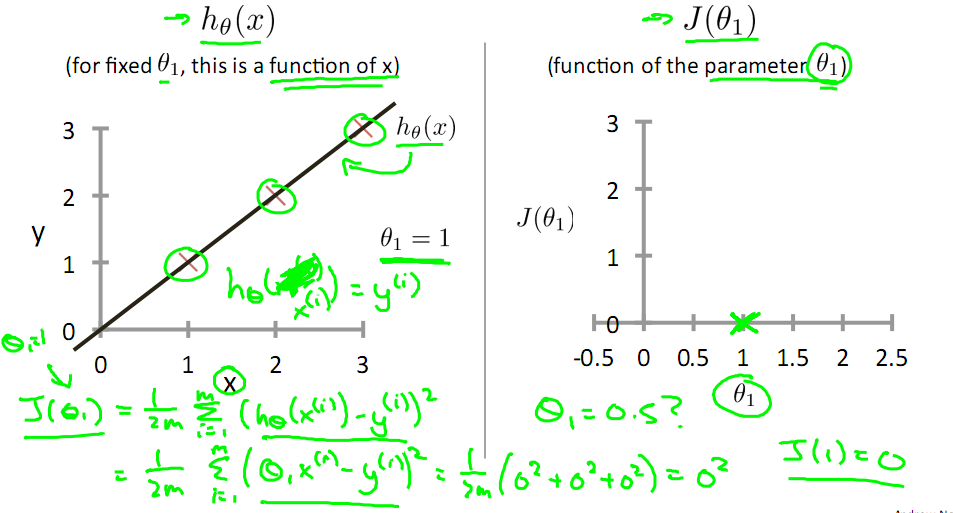

为了简化问题,我们令θ0=0,目标是优化J(θ1),得到其最小化,下面给出TrainSet,{(1,1),(2,2),(3,3)}通过手动寻找来找到最优解,由图可见当θ1取1时,![]() 与y(i)完全重合,J(θ1) = 0

与y(i)完全重合,J(θ1) = 0

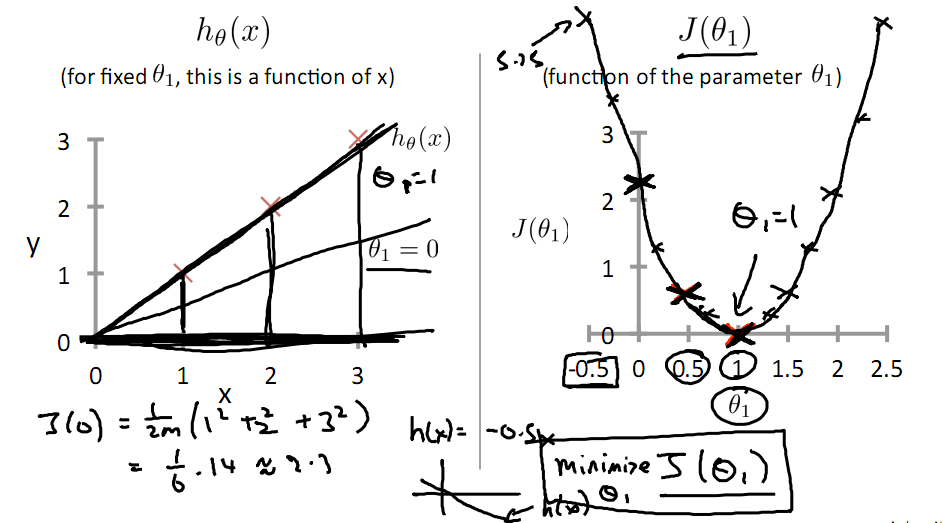

下面是θ1的取值与对应的J(θ1)变化情况

由此可见,最优解即为0,现在来看通过梯度下降法来自动找到最优解,对于上述待优化问题,下图给出其三维图像,可见要找到最优解,就要不断向下探索,使得J(θ)最小即可。

J(θ)的真正图形是类似下面这样的,因为其是一个凸函数,只有一个全局最优解。

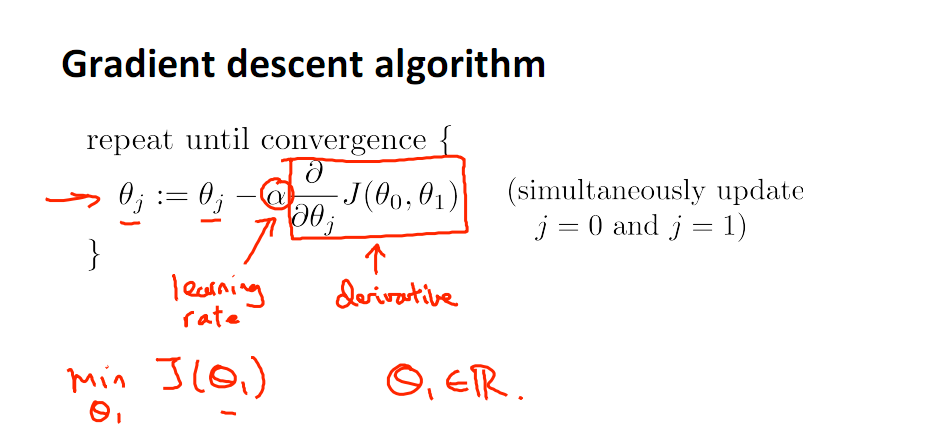

一种自动求解最小值的方法就是梯度下降法

对参数向量θ中的每个分量θj,迭代减去速率因子a* (dJ(θ)/dθj)即可,后边一项为J(θ)关于θj的偏导数

矩阵方程法:

用一次数学意义上的计算就能把所有的

θ=(XTX)−1XTy

阅读全文

0 0

- 机器学习中的 梯度下降与矩阵方程法

- 机器学习中的梯度下降法

- 机器学习中的梯度下降法

- 机器学习中的梯度下降法总结

- 机器学习 -- 最小二乘法与梯度下降法

- 梯度下降法与正规方程法

- 机器学习----梯度下降法

- 机器学习--梯度下降法

- 机器学习---梯度下降法

- 机器学习-梯度下降法

- 机器学习_线性回归,梯度下降算法与正规方程

- 机器学习笔记(一):梯度下降算法,随机梯度下降,正规方程

- 图像与机器学习-1-梯度下降法与ubuntu

- 关于机器学习中的梯度下降

- 梯度下降与正规方程

- 机器学习基础知识-回归与梯度下降法

- 机器学习(三):拉格朗日乘子与梯度下降法

- 【机器学习 基本概念】回归方法与梯度下降法

- 模拟Hibernate实现

- XTP控件ReportCtrl使用

- MVP架构设计--->001

- PAT乙级1035. 插入与归并(25)

- STM32外部中断

- 机器学习中的 梯度下降与矩阵方程法

- Android TextView 使用HTML处理字体样式、显示图片

- 查看表中是否存在索引及索引在哪几列

- 机器学习-1-基本概念

- hadoop集群 NTP时间同步

- disruptor高性能框架

- mysql常用sql总结_获取多个字段最大值最小值

- 【PDF下载】双11技术峰会之揭秘阿里虚拟互动实验室

- 支付宝手机网页唤醒app支付