CNN for 图像与视觉

来源:互联网 发布:剑三正太捏脸数据附图 编辑:程序博客网 时间:2024/05/18 09:15

1. 简介

1.1 fully connected vs. CNN

使用 全连接 的网络有两大问题:

- 参数过多

参数过多, 收敛就慢. 特别是对于1000*1000这种高分辨率图片, 多层全链接的参数量是巨大的. - 易过拟合

参数多意味着复杂, 就有过拟合的风险.

CNN这种网络结构, 将局部感受野,权值共享,时间或空间子采样这三种思想结合起来, 使得它对图像平移、缩放、旋转等的变形具有高度不变性.

2. 图像表示

先来复习一下图像的数字化表示.

图像的存储格式有三种:

- 黑白

0-1 表示, 二维的. - 灰阶

0~255 表示, 二维的. - 彩色

RGB, 三维的.

3.网络结构

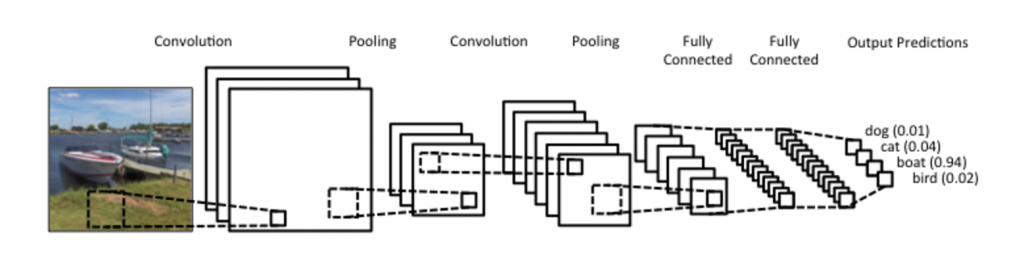

图3-1 图像分类的流程

全连接的网络, 一般都会把节点画出来, 因为它们是全连接, 这样方便显示连接结构.

而 CNN 并不是全连接的, 相邻两层之间只有部分节点相连.

为了展示每一层神经元的维度, 通常会将每一层的节点组织成二维或三维矩阵.

3.1 卷积

由图3-1可以看到, 第一层是原图, 第二层是若干个卷积得到的feature-map, 这若干个 特征图像 是由不同尺寸的卷积核 得到.

多卷积核

Q: 为什么需要多个卷积核?

Each filter composes a local patch of lower-level features into higher-level representation. That’s why CNNs are so powerful in Computer Vision.

在同一层,我们希望得到对于一张图片多种角度的描述,具体来讲就是用多种不同的卷积核对图像进行卷,得到不同核(这里的核可以理解为描述)上的响应,作为图像的特征。

再打个比方, 一个同学, 有身高, 年龄, 体重不同的维度去描述, 那么我们也希望不同的卷积核能从不同的aspect去描述图片.

权值共享

在 CNN 中, 同一个卷积层的同一个filter, 在 前向传播的时候, 权重参数是保持不变的, 这叫 权值共享.

Q: 权值共享有什么优点?

两个优点:

- 平移不变性

以MNIST 手写数字识别为例, 无论数字 ‘1’ 出现在左上角还是右下角, 图片种类都是不变的. 因为在左上角和右下角使用的filter参数相同, 所以通过卷积层之后, 无论数字在图像上的哪个位置, 得到的结果都一样. - 参数数量锐减

filter的尺寸为 n*m , 那么参数加偏置的个数为nm+1 , 与原始图片尺寸无关.

3.2 池化

4.LeNet-5

LeNet-5 是一种典型的用来识别数字的卷积神经网络, 共有7层(不包含输入),每层都包含可训练参数(连接权重)。

参考

- Le-Net-5

- CNN for 图像与视觉

- CNN与图像语义分割

- 计算机视觉与图像处理

- 【神经网络与深度学习】【计算机视觉】Fast R-CNN

- 【神经网络与深度学习】【计算机视觉】Faster R-CNN

- 图像处理与机器视觉的主要任务

- 图像处理与计算机视觉经典论文

- 图像处理与计算机视觉概述

- 图像处理与计算机视觉概述

- 立体视觉图像对,获取与保存

- 图像处理与计算机视觉开源库汇总

- 机器视觉与图像处理研究必备

- 图像处理与计算机视觉学习资源

- 图像处理与机器视觉网络资源

- 图像处理与计算机视觉的 topics

- 图像处理与计算机视觉概述

- 计算机视觉与图像识别综述

- 图像处理与机器视觉(1)

- c++学习之-------嵌套类的

- 二次采样和压缩

- js util字符串包含

- JavaScript总结记录2(学习JavaScript高级程序设计第三版)

- 创建rabbitmq:virtual host、exchange、queue

- CNN for 图像与视觉

- JAVA多线程之wait/notify

- leetcode_Hamming Distance

- reset.css

- Android 发送自定义广播

- Java-FileUploadUtil工具类

- 在使用python语言的open函数时,提示错误OSError: [Errno 22] Invalid argument: ‘文件路径’

- JAVA学习笔记-----面向对象

- Oracle 登录指令