爬虫-06-CrawlSpider及源码分析

来源:互联网 发布:晋业版医疗器械软件 编辑:程序博客网 时间:2024/05/22 15:40

通过前几章的2个项目的学习,其实本章的拉钩网项目还是挺容易理解的。

本章主要的还是对CrawlSpider源码的解析,其实我对源码还不是很懂,只是会基本的一些功能而已。

不分小节记录了,直接上知识点,可能比较乱。

1.建立数据表sql语句参考

1 CREATE TABLE `lagou_job` ( 2 `job_id` int(11) NOT NULL DEFAULT '0' COMMENT '职位页面的id', 3 `title` varchar(255) NOT NULL COMMENT '职位名称', 4 `url` varchar(255) NOT NULL COMMENT '职位链接', 5 `salary` varchar(255) DEFAULT NULL COMMENT '工资', 6 `job_city` varchar(255) DEFAULT NULL COMMENT '城市', 7 `work_years` varchar(255) DEFAULT NULL COMMENT '工作经验', 8 `degree_need` varchar(255) DEFAULT NULL COMMENT '学历', 9 `job_type` varchar(255) DEFAULT NULL COMMENT '工作性质',10 `publish_time` varchar(255) DEFAULT NULL COMMENT '发布时间',11 `job_advantage` varchar(255) DEFAULT '' COMMENT '职位诱惑',12 `job_desc` longtext COMMENT '职位描述',13 `job_addr` varchar(255) DEFAULT NULL COMMENT '工作详细地点',14 `company_url` varchar(255) DEFAULT NULL COMMENT '公司链接',15 `company_name` varchar(255) DEFAULT NULL COMMENT '公司名称',16 PRIMARY KEY (`job_id`)17 ) ENGINE=MyISAM DEFAULT CHARSET=utf8;

2.继承CrawlSpider

scrapy genspider -t crawl lagou www.lagou.com

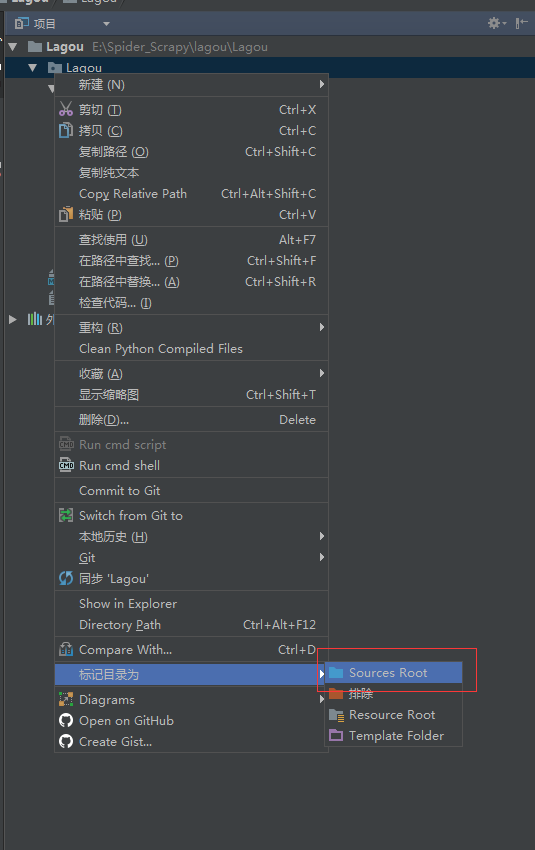

3.根目录问题

有时候from ... import ...出错的时候,可以看看根目录是不是对的

4.CrawlSpider使用说明

参考scrapy文档: http://scrapy-chs.readthedocs.io/zh_CN/latest/topics/spiders.html#crawlspider

作者:今孝

出处:http://www.cnblogs.com/jinxiao-pu/p/6757603.html

阅读全文

0 0

- 爬虫-06-CrawlSpider及源码分析

- Scrapy-CrawlSpider爬虫组件

- Scrapy-CrawlSpider爬虫组件

- Scrapy-CrawlSpider爬虫组件

- Scrapy源码分析-常用的爬虫类-CrawlSpider(三)

- Scrapy框架学习(四)----CrawlSpider、LinkExtractors、Rule及爬虫示例

- scrapy爬虫:CrawlSpider用法与总结

- Scrapy框架利用CrawlSpider创建自动爬虫

- Python爬虫入门-小试CrawlSpider

- Scrapy框架利用CrawlSpider创建自动爬虫

- scrapy学习(三) crawlspider源码解析

- pyspider爬虫框架源码分析

- 网络爬虫之Scrapy实战三:爬取多个网页CrawlSpider

- Scrapy爬虫框架学习笔 二 CrawlSpider的使用

- rvest爬虫及案例分析

- 网络爬虫源码分析(java实现)

- 开源JAVA爬虫crawler4j源码分析

- Spaghetti扫描器源码分析之爬虫模块

- 匈牙利算法的MATLAB 程序代码

- 条件随机场简介(CRF)(三)

- windows与虚拟机linux文件传输

- 剑指offer--(9) 变态跳台阶

- 数字三角形

- 爬虫-06-CrawlSpider及源码分析

- 2017 ACM-ICPC 亚洲区(西安赛区)网络赛

- 用键盘控制小球的方向

- RO段、RW段和ZI段。全局数据区为什么将已初始化数据和未初始化数据分开!

- 每个人都是孤独的史努比&

- Y

- 内表 外表区别 以及静态分区和动态分区

- leetcode个人刷题笔记(持续更新)

- java基础 运算符 条件运算符 ? :