Caffe中实现多标签数据准备及训练

来源:互联网 发布:护卫神linux 编辑:程序博客网 时间:2024/06/05 00:39

第一种说明方式:

拷贝convert_imageset,生成新工程convert_imageset_multi_label

修改源码

std::ifstream infile(argv[2]); std::vector<std::pair<std::string, std::vector<float>> > lines; std::string filename; std::string label_count_string = argv[5]; int label_count = std::atoi(label_count_string.c_str()); std::vector<float> label(label_count); while (infile >> filename) { for (int i = 0; i < label_count; i++) infile >> label[i]; lines.push_back(std::make_pair(filename, label)); } if (FLAGS_shuffle) { // randomly shuffle data LOG(INFO) << "Shuffling data"; shuffle(lines.begin(), lines.end()); } LOG(INFO) << "A total of " << lines.size() << " images."; if (encode_type.size() && !encoded) LOG(INFO) << "encode_type specified, assuming encoded=true."; int resize_height = std::max<int>(0, FLAGS_resize_height); int resize_width = std::max<int>(0, FLAGS_resize_width); // Create new DB scoped_ptr<db::DB> db_image(db::GetDB(FLAGS_backend)); scoped_ptr<db::DB> db_label(db::GetDB(FLAGS_backend)); db_image->Open(argv[3], db::NEW); db_label->Open(argv[4], db::NEW); scoped_ptr<db::Transaction> txn_image(db_image->NewTransaction()); scoped_ptr<db::Transaction> txn_label(db_label->NewTransaction());// // Create new DB// scoped_ptr<db::DB> db(db::GetDB(FLAGS_backend));// db->Open(argv[3], db::NEW);// scoped_ptr<db::Transaction> txn(db->NewTransaction()); // Storing to db std::string root_folder(argv[1]); Datum datum_image; Datum datum_label; int count = 0; int data_size = 0; bool data_size_initialized = false; for (int line_id = 0; line_id < lines.size(); ++line_id) { bool status; std::string enc = encode_type; if (encoded && !enc.size()) { // Guess the encoding type from the file name string fn = lines[line_id].first; size_t p = fn.rfind('.'); if ( p == fn.npos ) LOG(WARNING) << "Failed to guess the encoding of '" << fn << "'"; enc = fn.substr(p); std::transform(enc.begin(), enc.end(), enc.begin(), ::tolower); } status = ReadImageToDatum(root_folder + lines[line_id].first, lines[line_id].second[0], resize_height, resize_width, is_color, enc, &datum_image); if (status == false) continue; if (check_size) { if (!data_size_initialized) { data_size = datum_image.channels() * datum_image.height() * datum_image.width(); data_size_initialized = true; } else { const std::string& data = datum_image.data(); CHECK_EQ(data.size(), data_size) << "Incorrect data field size " << data.size(); } } // sequential string key_str = caffe::format_int(line_id, 8) + "_" + lines[line_id].first; // Put in db string out; CHECK(datum_image.SerializeToString(&out)); txn_image->Put(key_str, out); ////////////////////////////////////////////////////////////////////////// datum_label.set_channels(label_count); datum_label.set_height(1); datum_label.set_width(1); datum_label.clear_data(); datum_label.clear_float_data(); datum_label.set_encoded(false); std::vector<float> label_vec = lines[line_id].second; for (int i = 0; i < label_vec.size();i++) { datum_label.add_float_data(label_vec[i]); } string out_label; CHECK(datum_label.SerializeToString(&out_label)); txn_label->Put(key_str, out_label); ////////////////////////////////////////////////////////////////////////// if (++count % 1000 == 0) { // Commit db txn_image->Commit(); txn_image.reset(db_image->NewTransaction()); txn_label->Commit(); txn_label.reset(db_label->NewTransaction()); LOG(INFO) << "Processed " << count << " files."; } } // write the last batch if (count % 1000 != 0) { txn_image->Commit(); txn_label->Commit(); LOG(INFO) << "Processed " << count << " files."; }

上述方式使用了二个data层,编译之后,使用如下方式生成:

Build\x64\Release>convert_imageset_multi_label.exe ./ train.txt data/train_image_lmdb data/train_label_lmdb 4

train.txt文件格式如下:

data/00A03AF5-41C7-4966-8EF3-8B2C90DCF75C_cgfn.jpg 1 2 3 6

data/00A15FBD-9637-44C5-B2E7-81611263C88C_tmph.jpg 2 5 6 4

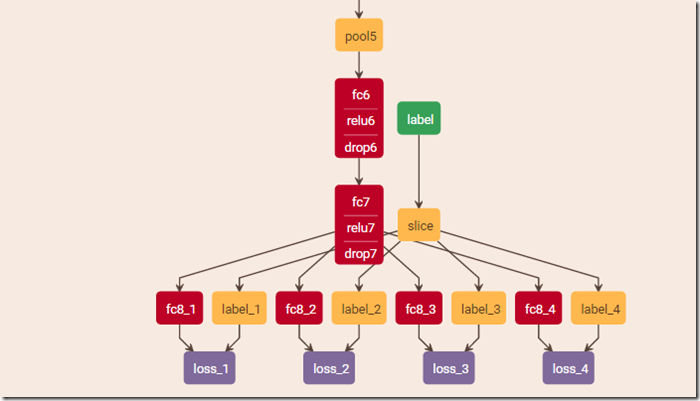

网络配置文件需要加入slice层将标签分割开来

layer {

name: "slice"

type: "Slice"

bottom: "label"

top: "label_1"

top: "label_2"

top: "label_3"

top: "label_4"

slice_param {

axis: 1

slice_point: 1

slice_point: 2

slice_point: 3

}

}

第二种说明方式:

Caffe多标签输入常用的的方法有以下几种:

1. 修改Caffe源码使其支持多标签输入,参考CSDN博客《caffe 实现多标签输入(multilabel、multitask)》

2. HDF5 + Slice Layer,HDF5支持多标签,但Caffe在读取HDF5时会将所有数据一次性预读进内存中,在数据量较大时就对内存有较高要求了;也可以对数据分片,通过在prototxt文件中加入Slice Layer层使Caffe依次读取每个数据分片。

3. 使用两个data输入(例如两个LMDB,一个存储图片,一个存储多标签),然后修改prototxt文件配置两个data layer。

本文只讨论上面第三种方法支持多标签输入。Caffe中单标签LMDB的创建可以通过自带的脚本很方便的实现,但多标签LMDB的创建并不像单标签那样简单易用,需要使用者对Caffe的Data Layer有足够的了解,对于大多数将Caffe作为一个黑盒的使用者而言,这个问题是非常麻烦的。不过该问题已经纳入了Caffe developer的讨论中了,相信不久后Caffe就能方便快速的进行多标签数据的准备了。

多标签的场景下,数据是 N x H x W x C 的一个4维的blob,对应的标签是 N x M x 1 x 1的一个4维的blob。我们通常通过如下几个步骤来进行数据准备:

创建图片LMDB

使用下面的代码创建两个图片LMDB:

- train_data_lmdb - 用于训练的图片LMDB

- val_data_lmdb - 用于测试的图片LMDB

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

上面的代码用来生成train_data_lmdb,接下来修改代码生成val_data_lmdb.

创建标签LMDB

使用下面的代码创建两个标签LMDB:

- train_label_lmdb - 用于训练的标签LMDB

- val_label_lmdb - 用于测试的标签LMDB

读入每幅图片的多标签,生成标签LMDB,注意图片LMDB和标签LMDB中的顺序一致,创建LMDB的部分python

代码如下:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

上面的代码用来生成train_label_lmdb,接下来修改代码生成val_label_lmdb.

修改prototxt文件

上面我们已经创建了四个数据集train_data_lmdb、val_data_lmdb、train_label_lmdb、val_label_lmdb,并且计算了图片均值mean.binaryproto。

接下来就是修改神经网络deploy.prototxt使其支持多标签训练。由于有四个数据集,我们只需要在deploy.txt中加入四个data layers,分别用来配置这四个数据集。需要注意的是在标签lmdb对应的data layer的参数transform_param中通过scaling参数对label进行缩放,该操作的作用是按照Sigmoid Cross Entropy Loss函数的要求将label范围从[0,255]正则化到[0,1](根据采用的多标签Loss函数的要求,scaling参数可以修改)。

将deploy.prototxt中原有的data layers修改为如下的四个data layers:

- Caffe中实现多标签数据准备及训练

- Caffe中LMDB接口实现多标签数据准备及训练

- Caffe 中怎样准备训练数据

- caffe多标签训练

- Caffe实战Day1-准备训练数据

- Caffe研究实践 二 ------准备数据 训练 测试

- Caffe中使用HDF5制作多标签数据

- caffe训练自己的数据集——1. 数据准备

- Caffe实现多标签分类

- Caffe 实现多标签分类

- Caffe 训练mnist数据

- faster-rcnn 之训练数据是如何准备的:imdb和roidb的产生(caffe版本)

- 人脸检测及识别python实现系列(3)——为模型训练准备人脸数据

- 利用Caffe做回归(regression)、多标签训练

- 使用caffe训练一个多标签分类/回归模型

- 使用caffe训练一个多标签分类/回归模型

- 使用caffe训练一个多标签分类/回归模型

- windows环境下训练caffe中cifar10数据集

- handler可能引发内存泄露问题的处理

- Android 命令行安装证书

- MySQL的日期时间

- 获取ip地址及其一些信息

- 人群行为分类数据库--Novel Dataset for Fine-grained Abnormal Behavior Understanding in Crowd

- Caffe中实现多标签数据准备及训练

- 更改CentOS默认yum镜像源为国内的yum镜像源

- 520. Detect Capital

- js-验证码插件gVerify.js

- git仓库管理

- JAVA JDK7和JDK8中HashMap的实现

- windows本地代码同步到Linux开发服务器的方法

- 通过例子学设计模式之--组合模式以及使用场景说明(C++实现)

- 算法课W1·leetcode 654. Maximum Binary Tree