TRPO

来源:互联网 发布:js 拖动事件 编辑:程序博客网 时间:2024/06/16 20:21

转载自知乎专栏 天津包子馅儿 的知乎

今天开始我们的第七讲,TRPO。先简短地介绍一下:TRPO是英文单词Trust region policy optimization的简称,翻译成中文是信赖域策略优化。提出这个算法的人是伯克利的博士生John Schulman,此人已于2016年博士毕业。Schulman的导师是强化学习领域的大神Pieter Abbeel, Abbeel是伯克利的副教授,同时也是OpenAI的研究科学家,是机器人强化学习领域最有影响力的人之一。

如果进一步追根溯源的话,Abbeel毕业于斯坦福大学,导师是Andrew Ng(吴恩达)。相信搞机器学习的人应该都听说过此大神或者听过他的课吧。有意思的是,吴恩达博士毕业于伯克利,之后在斯坦福任教,这跟Abbeel的经历正好相反。看来美国名校间人才互换的情况还是挺普遍的。Abbeel博士做的课题是逆向强化学习(学徒学习)。如果再进一步追根溯源,吴恩达的导师是伯克利的Michael I. Jordan,一个将统计学和机器学习联合起来的大师级人物……

扯的好像有点多了,其实不然。说那么多其实跟今天的主题有关系。从师承关系我们可以看到,这个学派由统计学大师Michael I. Jordan传下来,所以他们最有力的杀手锏是统计学习。从宏观意义上来讲,TRPO将统计玩到了一个新高度。在TRPO出来之前,大部分强化学习算法很难保证单调收敛,而TRPO却给出了一个单调的策略改善方法。所以,不管你从事什么行业,想用强化学习解决你的问题,TRPO是一个不错的选择。所以,这一节,很关键。好了,现在我们正式进入这一讲。

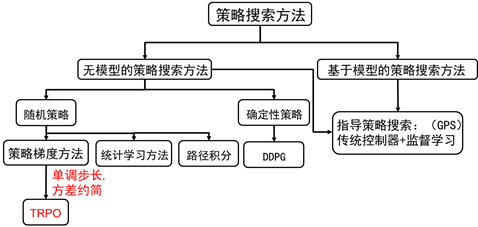

图7.1 策略搜索方法分类

策略梯度的缺点

上一节,我们已经讲了策略梯度的方法。当然策略梯度方法博大精深,上一讲只是给出一个入门的介绍,在策略梯度方法中还有很多有意思的课题,比如相容函数法,自然梯度法等等。但Shulman在博士论文中已证明,这些方法其实都是TRPO弱化的特例,说这些是再次强调TRPO的强大之处。

我们知道,根据策略梯度方法,参数更新方程式为:

(7.1)

策略梯度算法的硬伤就在更新步长 ,当步长不合适时,更新的参数所对应的策略是一个更不好的策略,当利用这个更不好的策略进行采样学习时,再次更新的参数会更差,因此很容易导致越学越差,最后崩溃。所以,合适的步长对于强化学习非常关键。

什么叫合适的步长?

所谓合适的步长是指当策略更新后,回报函数的值不能更差。如何选择这个步长?或者说,如何找到新的策略使得新的回报函数的值单调增,或单调不减。这是TRPO要解决的问题。

用表示一组状态-行为序列,强化学习的回报函数为:

这里,我们用表示策略。

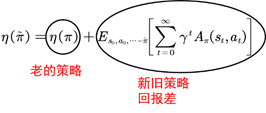

刚才已经说过,TRPO是找到新的策略,使得回报函数单调不减,一个自然地想法是能不能将新的策略所对应的回报函数分解成旧的策略所对应的回报函数+其他项。只要新的策略所对应的其他项大于等于零,那么新的策略就能保证回报函数单调不减。其实是存在这样的等式,这个等式是2002年Sham Kakade提出来的。TRPO的起点便是这样一个等式:

(7.2)

这里我们用表示旧的策略,用表示新的策略。其中,

称为优势函数。

此处我们再花点笔墨介绍下为什么称为优势函数,这个优势到底跟谁比。还是以大家熟悉的树状图来讲解:

图7.2 优势函数示意图

如图7.2,值函数可以理解为在该状态下所有可能动作所对应的动作值函数乘以采取该动作的概率的和。更通俗的讲,值函数是该状态下所有动作值函数关于动作概率的平均值。而动作值函数是单个动作所对应的值函数,能评价当前动作值函数相对于平均值的大小。所以,这里的优势指的是动作值函数相比于当前状态的值函数的优势。如果优势函数大于零,则说明该动作比平均动作好,如果优势函数小于零,则说明当前动作还不如平均动作好。

回到正题上来,我们给出公式(7.2)的证明:

证明:

我们详细讲解一下:

第一个等号是将优势函数的定义带入。

第二个等号是把第一项和后两项分开来写。

第三个等号是将第二项写开来,相消,只剩,而

等价于,因为两个策略都从同一个初始状态开始。而

图7.3 TRPO最重要的等式

为了在等式(7.2)中出现策略项,我们需要对公式(7.2)进一步加工转化。如图7.3,我们对新旧策略回报差进行转化。优势函数的期望可以写成如下式:

(7.3)

其中为的联合概率,为求对动作a的边际分布,也就是说在状态s对整个动作空间求和;为求对状态s的边际分布,即对整个状态空间求和;求整个时间序列的和。

我们定义

则:

(7.4)

如图所示:

图7.4 代价函数推导

注意,这时状态s的分布由新的策略产生,对新的策略严重依赖。

TRPO第一个技巧

这时,我们引入TRPO的第一个技巧对状态分布进行处理。我们忽略状态分布的变化,依然采用旧的策略所对应的状态分布。这个技巧是对原代价函数的第一次近似。其实,当新旧参数很接近时,我们将用旧的状态分布代替新的状态分布也是合理的。这时,原来的代价函数变成了:

(7.5)

我们再看(7.5)式的第二项策略部分,这时的动作a是由新的策略产生。可是新的策略是带参数的,这个参数是未知的,因此无法用来产生动作。这时,我们引入TRPO的第二个技巧。

TRPO第二个技巧

TRPO的第二个技巧是利用重要性采样对动作分布进行的处理。

通过利用两个技巧,我们再利用代替;取;

替代回报函数变为:

(7.6)

接下来,我们看一下替代回报函数(7.6)和原回报函数(7.4)有什么关系

通过比较我们发现,(7.4)和(7.6)唯一的区别是状态分布的不同。将都看成是策略的函数,则在策略处一阶近似,即:

(7.7)

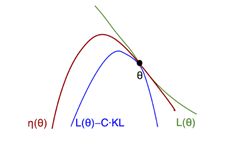

用图来表示为:

图7.5 回报函数与替代回报函数示意图

在 附近,能改善L的策略也能改善原回报函数。问题是步长多大呢?

再次引入第二个重量级的不等式

(7.8)

为了保持连贯性,该不等式的证明略,以后再专门开篇帖子补上。其中是两个分布的KL散度。我们在这里看一看,该不等式给了我们什么启示。

首先,该不等式给了的下界,我们定义这个下界为,

下面利用这个下界,我们证明策略的单调性:

且

则:

如果新的策略能使得最大,那么有不等式,则,这个使得最大的新的策略就是我们一直在苦苦找的要更新的策略。那么这个策略如何得到呢?

该问题可形式化为:

如果利用惩罚因子C则每次迭代步长很小,因此问题可转化为:

(7.9)

需要注意的是,因为有无穷多的状态,因此约束条件有无穷多个。问题不可解。

TRPO第三个技巧

在约束条件中,利用平均KL散度代替最大KL散度,即:

TRPO第四个技巧:

最终TRPO问题化简为:

(7.10)

接下来就是利用采样得到数据,然后求样本均值,解决优化问题即可。至此,TRPO理论算法完成。关于如何求解,以及如何减小方差,我们之后的课程会再讲。

- TRPO

- 强化学习进阶 第七讲 TRPO

- TRPO(trust region policy optimization)(2)

- TRPO(Trust Region Policy Optimization)(1)

- 解决ssh server偶尔连不上或者发现网络连接初始很慢的状况(by quqi99)

- Java之HashMap在多线程情况下导致死循环的问题

- python小结之Ellipsis对象

- Registry Winner(顶级系统注册表优化专家)官方破解版V7.0.12.15下载 | 无需registry winner注册码

- knockout的select的默认展示的坑

- TRPO

- HDU 1010 Tempter of the Bone(DFS+暴力+标记)

- 【LibreOJ】6177 「美团 CodeM 初赛 Round B」送外卖2 状压DP

- LCA (Tarjan)

- 无废话ExtJs 入门教程二[Hello World]

- jQuery——append等文档处理方法

- RLEH7配置samba,提示WARNING: Ignoring invalid value 'share' for parameter 'security'

- JAVA的String中intern的方法

- javascript的垃圾回收机制