【论文阅读】Illuminating Pedestrians via Simultaneous Detection & Segmentation

来源:互联网 发布:js控制标签显示隐藏 编辑:程序博客网 时间:2024/06/05 20:58

论文来源

- ICCV2017

- arXiv report

- github代码(caffe-matlab)

本文的主要问题是行人检测。作者探讨了如何将语义分割应用在行人检测上,提高检测率,同时也不损坏检测效率。作者提出了一种语义融合网络(segmentation infusion networks)去促进在语义分割与行人检测上的联合监督。其中行人检测为主要任务,语义分割主要起到了矫正,指导共享层的特征生成。作者在题目中提到了照亮行人。其实主要指的是通过语义分割的监督,可以使得生成的feature更聚焦在行人上,从而便于下游的行人检测。

另外本文比较好的贡献在于对网络的设置很合适,也就是说语义分割层的设置恰到好处。因此就算使用弱标注的语义信息也足以提升性能。

背景介绍

行人检测试计算机视觉中的核心问题,主要方法有两种:目标检测与语义分割。这两种方法高度关联,但有各自的优缺点。比如目标检测可以定位不同的物体,但是很少能给出物体的边界。而语义分割虽然能逐像素地定位物体的边界,但是很难区别同类。

自然我们希望来自一个任务的知识能使得另一任务变得容易些。这在一研究的目标检测中已经得到了实现。那么在行人检测中却研究地很少。部分原因是在传统的行人数据集中缺乏逐像素的标注。

例如我们来看传统的几个数据集.

Caltech

KITTI

KITTI数据集简介与使用

此数据集为摄像机视野内的运动物体提供一个3D边框标注(使用激光雷达的坐标系)。该数据集的标注一共分为8个类别:’Car’, ’Van’, ’Truck’, ’Pedestrian’, ’Person (sit- ting)’, ’Cyclist’, ’Tram’ 和’Misc’ (e.g., Trailers, Segways)。以上两个数据集,仅仅提供了行人的bounding box,没有提供语义信息。

COCO

本数据集是一般的目标检测数据集,可以从图上看出它提供了丰富的标签,既有位置信息,也有语义信息。

- Cityscapes

此数据集提供了详细的城市语义标注,当然也包含了行人的语义标注。此数据集的主要意图就是促进语义分割在行人检测上的应用。这也是本文的core所在。

Simultaneous Detection & Segmentation

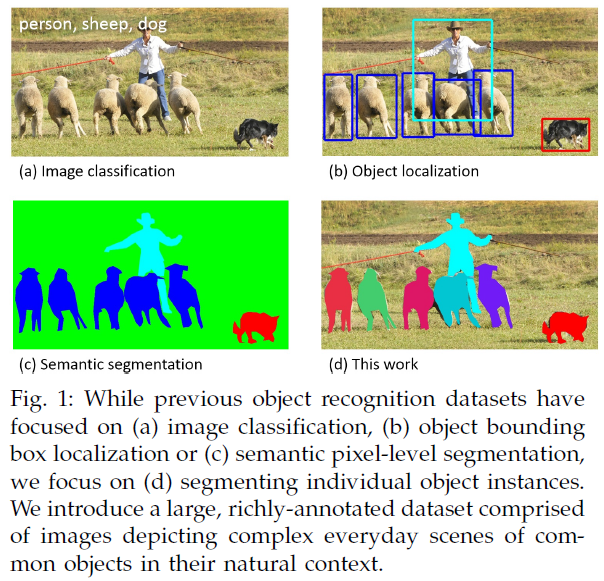

有两种方式来研究同时的检测与分割。一种是同时促进两种任务。例如我们广知的Instance-aware segmentation .

其实上面的图d就是典型的这类任务,它不同与以往的语义分割,而是在语义分割的基础上还要求把同类的分开。其实就是分割+检测。

第二种就是使用语义分割作为强线索明显地提高目标检测。其实很早,我读过人脸加测与人脸特征点的一篇文章,

《Joint Face Detection and Alignment using Multi-task Cascaded Convolutional Networks

这篇文章就是以人脸特征点检测来促进人脸检测的。其实人识别人脸往往就是识别人的五官来进行人脸检测。那么在目标检测中,语义信息往往提供了很强大的特征来促进检测,并且可以抑制背景的干扰。但有些工作要求先有一个单独的分割网络才能进行检测。我们的框架克服了这个缺点,可以将语义信息融合到shared feature maps,最后在准确性和性能上都有了提升。

方法解析

上面是整个网络结构,包含了两阶段。第一阶段使用rpn网络提出行人检测候选框与给出初步的分值。第二阶段进一步地挖掘了hard sample,给出了对应的细化分数.由于rpn已经预测行人的位置足够准确了,因此第二步只是单纯的分类,没有bounding box的回归。而且两个网络的预测分数进行了叠加,作为最后的分类分数。

下面我们仔细阐述一下其中的道理。

RPN

RPN来源自Fatser rcnn,用来propose a set of bounding with associated confidence scores around pedestrains.

rpn网络在某个feature map的没一点出分别枚举出一定比例与尺度的anchor box,相当于在一个池化的图像空间的一个滑动窗口。每一个proposal box i都对应一个anchor(指scale与aspect ratio)与图像空间的一个位置。

如图,rpn采用VGG-16的conv1-5作为backbone(提特征),然后接了两个分层,一个层叫segementation infusion layer,另一个就是传统的proposal layer,带有两个输出层分别用于分类与bounding box回归。

从网络结构上看到,上面的segmentation infusion layer的ground truth 是两个白色小方块做成的mask,其实就是标注的行人检测的bouding box的内部。然后经过两个分层的联合训练,最终CONV1-5输出的feature map明显凸显了行人,即照亮了行人。

此rpn的目标函数如下:

Lc代表分类的损失,采用softmax logistic loss over two classes。(行人vs 背景)。此处将一个box识别为行人的法则是IoU>=0.5.

Lr是回归损失。使用

Ls是语义分割的损失。后面阐述。

实验中,

BCN(Binary Classfication Network)

BCN主要完成在RPN提出的proposal的行人识别。作为一般的目标检测,一般采用faster rcnn后端的识别部分即可。但是根据《Is faster rcnn doing well for pedestrian detection?》,faster rcnn的后端反而会degrade pedestrian detection accuracy。因此这里选择使用VGG-16构建一个单独的识别网络。

这个网络主要在于识别RPN遗忘的hard example。提高那些遮挡、变形等行人的分数,从而可以将其检测出来。

当然了,此部分仍然增加了语义信息,提高识别率。

此部分的目标函数如下:

其中主要特点如下:

1.

具体说来,对于第i个Proposal,给定RPN的预测两类分数为

这里重点说一下,他这里给出的融合分数到底有何技巧?正如下面一章【问题1】提出的,这里为什么要这样取分数?而且这里的分类损失又是什么呢?

我们先来看看一般,如RPN中的分类损失怎么计算,实际上是使用softmax-logistic loss,也就是先计算softmax得分,再求label对应的logistic似然损失,最后令其最小化。

那么我们这里呢,肯定也是使用似然损失,那么如何计算label对应的分数呢?是不是也是使用softmax呢?

我们观测这里给出的

而且这里省略了一个分数,即预测其为背景的分数,即

2. 设置了cost-sensitive的权重

3. 采取了更加严格的labeling policy,要求 a proposal to have IoU > 0.7 with a ground truth pedestrian box to be considered pedestrian (ci = 1), and otherwise background (ci = 0).

Simultaneous Detection & Segmentation

无论在RPN还是在BCN,都集合了融合layer.The segmentation infusion layer旨在输出两个mask揭示行人与背景分割的可能性 .这里选择使用仅仅一个layer和一个1x1的核,以至于尽可能高地施加影响到共享的层,从而驱使网络去直接融合语义特征到shared feature map。

Ls是一个在两类(行人vs 背景)的softmax logistic loss,应用于每一个位置i,同时也引入了cost-sensitive weight 即

这里

这样做是可行的,因为我们将会融合层放在了conv5后面,此时图像已经经过了多层降采样。也就是基于box的标注与基于pixel的标注已经基本相同了。

那么具体怎么计算

则

留下一个疑问,对于非盒子区域的S,如何计算权重呢?或者是不是不再需要权重了??

实验设计

实验设计其实就是两方面,一方面与baseline进行比较,一方面解释上述网络设计的可行性,也就是ablation study.

如下图,作者进行了 weak segmentation supervision,proposal padding, cost-sensitive weighting, and stricter supervision以及stage-wise fusion的研究。

对于weak segmentation supervision,proposal padding, cost-sensitive weighting, and stricter supervision,作者分别切除了每一部分,分别计算RPN,BCN以及Fusion的miss rate.

- 这里RPN很明白,可以直接输入图片,禁掉了 weak segmentation supervision,进而检测行人,计算miss rate。

- BCN呢?输入是什么?在原文中,BCN直接输入的是proposal裁剪测图像。这里应该还是如此,只不过禁掉了 weak segmentation supervisio,但是RPN中正常,不要禁掉weak segmentation supervision。

- Fusion则全部禁掉weak segmentation supervision.

对于最后一行的SDS-RCNN,BCN则还是需要以RPN为输入,只不过分数不再融合,直接计算其分类得分,从而检测行人。而Fusion则融合RPN与BCN的分数。

问题

- BCN(Binary Classfication Network)的分数融合机制是否是最优的,文中提到:

也即是说两个网络进行了互补机制,一句话概括就是好上加好,优中选优。

具体说来,当RPN网络预测某个proposal为行人的分数很高,而BCN网络也如此,则显然,最后预测行人的分数会很高。相反对于一些hard example,可能RPN预测地很低,而BCN预测地很高,则最终的结果如何呢?这实际上取决于二者分数的综合效果,其实就是两者的和,如果行人分数的和大于背景分数的和,则最终预测行人的分数就很高。反之,则可能还是背景。这也说明,只有BCN预测hard example的能力足够强,才能形成互补机制。对于一些模棱两可的example,即使BCN预测其为行人的分数较高,但如果不是足够高,则最终也不能将其判为行人,这实际上就减轻了false positive的压力。

2. softmax logistic loss??

参考 softmax logistic loss详解

- 【论文阅读】Illuminating Pedestrians via Simultaneous Detection & Segmentation

- [深度学习论文笔记][Instance Segmentation] Simultaneous Detection and Segmentation

- Simultaneous Detection and Segmentation

- 论文阅读:BiSeg: Simultaneous Instance Segmentation and Semantic Segmentation

- 论文笔记 《Object detection via a multi-region & semantic segmentation-aware CNN model》

- 【转载】论文笔记 《Object detection via a multi-region & semantic segmentation-aware CNN model》

- 论文阅读:Instance-aware Semantic Segmentation via Multi-task Network Cascades

- Semantic Segmentation via Structured Patch Prediction, Context CRF and Guidance CRF--论文阅读

- 论文阅读:RCNN[Rich feature hierarchies for accurate object detection and semantic segmentation]

- 【论文阅读】Fused Text Segmentation Network for Multi-oriented Scene Text Detection

- [论文阅读]R-FCN: Object Detection via Region-based Fully Convolutional Networks

- [论文阅读]R-FCN: Object Detection via Region-based Fully Convolutional Networks

- 对论文R-FCN: Object Detection via Region-based Fully Convolutional Networks的阅读

- 论文阅读 R-FCN: Object Detection via Region-based Fully Convolutional Networks

- 基于部分的行人检测(Part-Based Pedestrians Detection)论文列表

- Multi-scale Patch Aggregation (MPA) for Simultaneous Detection and Segmentation 笔记

- 论文阅读-《Semantic Segmentation with Reverse Attention》

- 论文阅读:Instance-Level Salient Object Segmentation

- ubuntu如何使用root权限

- Struts2深入详解--- 认识Struts2

- Switchhosts软件的使用

- 解决从mysql表中多列导出数据到csv合并成一列的问题

- TrickGCD HDU

- 【论文阅读】Illuminating Pedestrians via Simultaneous Detection & Segmentation

- 电商高复用购物车业务分析和代码实现

- Binary Search:162. Find Peak Element

- 【nginx】nginx与apache详细性能对比

- 获取从服务器传来的key-value对

- ajax+post+json+@requestBody走天下

- javascript各种设计模式

- 第二次自考总结

- JS跳出循环的三种方法(break, return, continue)