机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

来源:互联网 发布:多台网络打印机服务器 编辑:程序博客网 时间:2024/06/06 01:40

机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

原文地址:Complete Guide to Parameter Tuning in XGBoost by Aarshay Jain

原文翻译与校对:@MOLLY &&寒小阳 (hanxiaoyang.ml@gmail.com)

时间:2016年9月。

出处:http://blog.csdn.net/han_xiaoyang/article/details/52665396

声明:版权所有,转载请联系作者并注明出

1. 简介

如果你的预测模型表现得有些不尽如人意,那就用XGBoost吧。XGBoost算法现在已经成为很多数据工程师的重要武器。它是一种十分精致的算法,可以处理各种不规则的数据。

构造一个使用XGBoost的模型十分简单。但是,提高这个模型的表现就有些困难(至少我觉得十分纠结)。这个算法使用了好几个参数。所以为了提高模型的表现,参数的调整十分必要。在解决实际问题的时候,有些问题是很难回答的——你需要调整哪些参数?这些参数要调到什么值,才能达到理想的输出?

这篇文章最适合刚刚接触XGBoost的人阅读。在这篇文章中,我们会学到参数调优的技巧,以及XGboost相关的一些有用的知识。以及,我们会用Python在一个数据集上实践一下这个算法。

2. 你需要知道的

XGBoost(eXtreme Gradient Boosting)是Gradient Boosting算法的一个优化的版本。因为我在前一篇文章,基于Python的Gradient Boosting算法参数调整完全指南,里面已经涵盖了Gradient Boosting算法的很多细节了。我强烈建议大家在读本篇文章之前,把那篇文章好好读一遍。它会帮助你对Boosting算法有一个宏观的理解,同时也会对GBM的参数调整有更好的体会。

特别鸣谢:我个人十分感谢Mr Sudalai Rajkumar (aka SRK)大神的支持,目前他在AV Rank中位列第二。如果没有他的帮助,就没有这篇文章。在他的帮助下,我们才能给无数的数据科学家指点迷津。给他一个大大的赞!

3. 内容列表

1、XGBoost的优势

2、理解XGBoost的参数

3、调参示例

4. XGBoost的优势

XGBoost算法可以给预测模型带来能力的提升。当我对它的表现有更多了解的时候,当我对它的高准确率背后的原理有更多了解的时候,我发现它具有很多优势:

4.1 正则化

- 标准GBM的实现没有像XGBoost这样的正则化步骤。正则化对减少过拟合也是有帮助的。

- 实际上,XGBoost以“正则化提升(regularized boosting)”技术而闻名。

4.2 并行处理

- XGBoost可以实现并行处理,相比GBM有了速度的飞跃。

- 不过,众所周知,Boosting算法是顺序处理的,它怎么可能并行呢?每一课树的构造都依赖于前一棵树,那具体是什么让我们能用多核处理器去构造一个树呢?我希望你理解了这句话的意思。如果你希望了解更多,点击这个链接。

- XGBoost 也支持Hadoop实现。

4.3 高度的灵活性

- XGBoost 允许用户定义自定义优化目标和评价标准

- 它对模型增加了一个全新的维度,所以我们的处理不会受到任何限制。

4.4 缺失值处理

- XGBoost内置处理缺失值的规则。

- 用户需要提供一个和其它样本不同的值,然后把它作为一个参数传进去,以此来作为缺失值的取值。XGBoost在不同节点遇到缺失值时采用不同的处理方法,并且会学习未来遇到缺失值时的处理方法。

4.5 剪枝

- 当分裂时遇到一个负损失时,GBM会停止分裂。因此GBM实际上是一个贪心算法。

- XGBoost会一直分裂到指定的最大深度(max_depth),然后回过头来剪枝。如果某个节点之后不再有正值,它会去除这个分裂。

- 这种做法的优点,当一个负损失(如-2)后面有个正损失(如+10)的时候,就显现出来了。GBM会在-2处停下来,因为它遇到了一个负值。但是XGBoost会继续分裂,然后发现这两个分裂综合起来会得到+8,因此会保留这两个分裂。

4.6 内置交叉验证

- XGBoost允许在每一轮boosting迭代中使用交叉验证。因此,可以方便地获得最优boosting迭代次数。

- 而GBM使用网格搜索,只能检测有限个值。

4.7、在已有的模型基础上继续

- XGBoost可以在上一轮的结果上继续训练。这个特性在某些特定的应用上是一个巨大的优势。

- sklearn中的GBM的实现也有这个功能,两种算法在这一点上是一致的。

相信你已经对XGBoost强大的功能有了点概念。注意这是我自己总结出来的几点,你如果有更多的想法,尽管在下面评论指出,我会更新这个列表的!

你的胃口被我吊起来了吗?棒棒哒!如果你想更深入了解相关信息,可以参考下面这些文章:

XGBoost Guide - Introduce to Boosted Trees

Words from the Auther of XGBoost[Viedo]

5. XGBoost的参数

XGBoost的作者把所有的参数分成了三类:

- 通用参数:宏观函数控制。

- Booster参数:控制每一步的booster(tree/regression)。

- 学习目标参数:控制训练目标的表现。

在这里我会类比GBM来讲解,所以作为一种基础知识,强烈推荐先阅读这篇文章。

5.1 通用参数

这些参数用来控制XGBoost的宏观功能。

1、booster[默认gbtree]

- 选择每次迭代的模型,有两种选择:

gbtree:基于树的模型

gbliner:线性模型

2、silent[默认0]

- 当这个参数值为1时,静默模式开启,不会输出任何信息。

- 一般这个参数就保持默认的0,因为这样能帮我们更好地理解模型。

3、nthread[默认值为最大可能的线程数]

- 这个参数用来进行多线程控制,应当输入系统的核数。

- 如果你希望使用CPU全部的核,那就不要输入这个参数,算法会自动检测它。

还有两个参数,XGBoost会自动设置,目前你不用管它。接下来咱们一起看booster参数。

5.2 booster参数

尽管有两种booster可供选择,我这里只介绍tree booster,因为它的表现远远胜过linear booster,所以linear booster很少用到。

1、eta[默认0.3]

- 和GBM中的 learning rate 参数类似。

- 通过减少每一步的权重,可以提高模型的鲁棒性。

- 典型值为0.01-0.2。

2、min_child_weight[默认1]

- 决定最小叶子节点样本权重和。

- 和GBM的 min_child_leaf 参数类似,但不完全一样。XGBoost的这个参数是最小样本权重的和,而GBM参数是最小样本总数。

- 这个参数用于避免过拟合。当它的值较大时,可以避免模型学习到局部的特殊样本。

- 但是如果这个值过高,会导致欠拟合。这个参数需要使用CV来调整。

3、max_depth[默认6]

- 和GBM中的参数相同,这个值为树的最大深度。

- 这个值也是用来避免过拟合的。max_depth越大,模型会学到更具体更局部的样本。

- 需要使用CV函数来进行调优。

- 典型值:3-10

4、max_leaf_nodes

- 树上最大的节点或叶子的数量。

- 可以替代max_depth的作用。因为如果生成的是二叉树,一个深度为n的树最多生成

n2 个叶子。 - 如果定义了这个参数,GBM会忽略max_depth参数。

5、gamma[默认0]

- 在节点分裂时,只有分裂后损失函数的值下降了,才会分裂这个节点。Gamma指定了节点分裂所需的最小损失函数下降值。

- 这个参数的值越大,算法越保守。这个参数的值和损失函数息息相关,所以是需要调整的。

6、max_delta_step[默认0]

- 这参数限制每棵树权重改变的最大步长。如果这个参数的值为0,那就意味着没有约束。如果它被赋予了某个正值,那么它会让这个算法更加保守。

- 通常,这个参数不需要设置。但是当各类别的样本十分不平衡时,它对逻辑回归是很有帮助的。

- 这个参数一般用不到,但是你可以挖掘出来它更多的用处。

7、subsample[默认1]

- 和GBM中的subsample参数一模一样。这个参数控制对于每棵树,随机采样的比例。

- 减小这个参数的值,算法会更加保守,避免过拟合。但是,如果这个值设置得过小,它可能会导致欠拟合。

- 典型值:0.5-1

8、colsample_bytree[默认1]

- 和GBM里面的max_features参数类似。用来控制每棵随机采样的列数的占比(每一列是一个特征)。

- 典型值:0.5-1

9、colsample_bylevel[默认1]

- 用来控制树的每一级的每一次分裂,对列数的采样的占比。

- 我个人一般不太用这个参数,因为subsample参数和colsample_bytree参数可以起到相同的作用。但是如果感兴趣,可以挖掘这个参数更多的用处。

10、lambda[默认1]

- 权重的L2正则化项。(和Ridge regression类似)。

- 这个参数是用来控制XGBoost的正则化部分的。虽然大部分数据科学家很少用到这个参数,但是这个参数在减少过拟合上还是可以挖掘出更多用处的。

11、alpha[默认1]

- 权重的L1正则化项。(和Lasso regression类似)。

- 可以应用在很高维度的情况下,使得算法的速度更快。

12、scale_pos_weight[默认1]

- 在各类别样本十分不平衡时,把这个参数设定为一个正值,可以使算法更快收敛。

5.3学习目标参数

这个参数用来控制理想的优化目标和每一步结果的度量方法。

1、objective[默认reg:linear]

- 这个参数定义需要被最小化的损失函数。最常用的值有:

- binary:logistic 二分类的逻辑回归,返回预测的概率(不是类别)。

- multi:softmax 使用softmax的多分类器,返回预测的类别(不是概率)。

- 在这种情况下,你还需要多设一个参数:num_class(类别数目)。

- multi:softprob 和multi:softmax参数一样,但是返回的是每个数据属于各个类别的概率。

2、eval_metric[默认值取决于objective参数的取值]

- 对于有效数据的度量方法。

- 对于回归问题,默认值是rmse,对于分类问题,默认值是error。

- 典型值有:

- rmse 均方根误差(

∑Ni=1ϵ2N−−−−−√ ) - mae 平均绝对误差(

∑Ni=1|ϵ|N ) - logloss 负对数似然函数值

- error 二分类错误率(阈值为0.5)

- merror 多分类错误率

- mlogloss 多分类logloss损失函数

- auc 曲线下面积

- rmse 均方根误差(

3、seed(默认0)

- 随机数的种子

- 设置它可以复现随机数据的结果,也可以用于调整参数

如果你之前用的是Scikit-learn,你可能不太熟悉这些参数。但是有个好消息,python的XGBoost模块有一个sklearn包,XGBClassifier。这个包中的参数是按sklearn风格命名的。会改变的函数名是:

1、eta -> learning_rate

2、lambda -> reg_lambda

3、alpha -> reg_alpha

你肯定在疑惑为啥咱们没有介绍和GBM中的n_estimators类似的参数。XGBClassifier中确实有一个类似的参数,但是,是在标准XGBoost实现中调用拟合函数时,把它作为num_boosting_rounds参数传入。

XGBoost Guide 的一些部分是我强烈推荐大家阅读的,通过它可以对代码和参数有一个更好的了解:

XGBoost Parameters (official guide)

XGBoost Demo Codes (xgboost GitHub repository)

Python API Reference (official guide)

6. 调参示例

我们从Data Hackathon 3.x AV版的hackathon中获得数据集,和GBM 介绍文章中是一样的。更多的细节可以参考competition page

数据集可以从这里下载。我已经对这些数据进行了一些处理:

City变量,因为类别太多,所以删掉了一些类别。DOB变量换算成年龄,并删除了一些数据。- 增加了

EMI_Loan_Submitted_Missing变量。如果EMI_Loan_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的EMI_Loan_Submitted变量。 EmployerName变量,因为类别太多,所以删掉了一些类别。- 因为

Existing_EMI变量只有111个值缺失,所以缺失值补充为中位数0。 - 增加了

Interest_Rate_Missing变量。如果Interest_Rate变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Interest_Rate变量。 - 删除了

Lead_Creation_Date,从直觉上这个特征就对最终结果没什么帮助。 Loan_Amount_Applied, Loan_Tenure_Applied两个变量的缺项用中位数补足。- 增加了

Loan_Amount_Submitted_Missing变量。如果Loan_Amount_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Loan_Amount_Submitted变量。 - 增加了

Loan_Tenure_Submitted_Missing变量。如果Loan_Tenure_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Loan_Tenure_Submitted变量。 - 删除了

LoggedIn,Salary_Account两个变量 - 增加了

Processing_Fee_Missing变量。如果Processing_Fee变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Processing_Fee变量。 Source前两位不变,其它分成不同的类别。- 进行了离散化和独热编码(一位有效编码)。

如果你有原始数据,可以从资源库里面下载data_preparation的Ipython notebook 文件,然后自己过一遍这些步骤。

首先,import必要的库,然后加载数据。

#Import libraries:import pandas as pdimport numpy as npimport xgboost as xgbfrom xgboost.sklearn import XGBClassifierfrom sklearn import cross_validation, metrics #Additional scklearn functionsfrom sklearn.grid_search import GridSearchCV #Perforing grid searchimport matplotlib.pylab as plt%matplotlib inlinefrom matplotlib.pylab import rcParamsrcParams['figure.figsize'] = 12, 4train = pd.read_csv('train_modified.csv')target = 'Disbursed'IDcol = 'ID'- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

注意我import了两种XGBoost:

- xgb - 直接引用xgboost。接下来会用到其中的“cv”函数。

- XGBClassifier - 是xgboost的sklearn包。这个包允许我们像GBM一样使用Grid Search 和并行处理。

在向下进行之前,我们先定义一个函数,它可以帮助我们建立XGBoost models 并进行交叉验证。好消息是你可以直接用下面的函数,以后再自己的models中也可以使用它。

def modelfit(alg, dtrain, predictors,useTrainCV=True, cv_folds=5, early_stopping_rounds=50):if useTrainCV: xgb_param = alg.get_xgb_params() xgtrain = xgb.DMatrix(dtrain[predictors].values, label=dtrain[target].values) cvresult = xgb.cv(xgb_param, xgtrain, num_boost_round=alg.get_params()['n_estimators'], nfold=cv_folds, metrics='auc', early_stopping_rounds=early_stopping_rounds, show_progress=False) alg.set_params(n_estimators=cvresult.shape[0])#Fit the algorithm on the dataalg.fit(dtrain[predictors], dtrain['Disbursed'],eval_metric='auc')#Predict training set:dtrain_predictions = alg.predict(dtrain[predictors])dtrain_predprob = alg.predict_proba(dtrain[predictors])[:,1]#Print model report:print "\nModel Report"print "Accuracy : %.4g" % metrics.accuracy_score(dtrain['Disbursed'].values, dtrain_predictions)print "AUC Score (Train): %f" % metrics.roc_auc_score(dtrain['Disbursed'], dtrain_predprob)feat_imp = pd.Series(alg.booster().get_fscore()).sort_values(ascending=False)feat_imp.plot(kind='bar', title='Feature Importances')plt.ylabel('Feature Importance Score')- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

这个函数和GBM中使用的有些许不同。不过本文章的重点是讲解重要的概念,而不是写代码。如果哪里有不理解的地方,请在下面评论,不要有压力。注意xgboost的sklearn包没有“feature_importance”这个量度,但是get_fscore()函数有相同的功能。

6.1 参数调优的一般方法

我们会使用和GBM中相似的方法。需要进行如下步骤:

选择较高的学习速率(learning rate)。一般情况下,学习速率的值为0.1。但是,对于不同的问题,理想的学习速率有时候会在0.05到0.3之间波动。选择对应于此学习速率的理想决策树数量。XGBoost有一个很有用的函数“cv”,这个函数可以在每一次迭代中使用交叉验证,并返回理想的决策树数量。

对于给定的学习速率和决策树数量,进行决策树特定参数调优(max_depth, min_child_weight, gamma, subsample, colsample_bytree)。在确定一棵树的过程中,我们可以选择不同的参数,待会儿我会举例说明。

xgboost的正则化参数的调优。(lambda, alpha)。这些参数可以降低模型的复杂度,从而提高模型的表现。

降低学习速率,确定理想参数。

咱们一起详细地一步步进行这些操作。

第一步:确定学习速率和tree_based 参数调优的估计器数目

为了确定boosting参数,我们要先给其它参数一个初始值。咱们先按如下方法取值:

1、max_depth = 5 :这个参数的取值最好在3-10之间。我选的起始值为5,但是你也可以选择其它的值。起始值在4-6之间都是不错的选择。

2、min_child_weight = 1:在这里选了一个比较小的值,因为这是一个极不平衡的分类问题。因此,某些叶子节点下的值会比较小。

3、gamma = 0: 起始值也可以选其它比较小的值,在0.1到0.2之间就可以。这个参数后继也是要调整的。

4、subsample, colsample_bytree = 0.8: 这个是最常见的初始值了。典型值的范围在0.5-0.9之间。

5、scale_pos_weight = 1: 这个值是因为类别十分不平衡。

注意哦,上面这些参数的值只是一个初始的估计值,后继需要调优。这里把学习速率就设成默认的0.1。然后用xgboost中的cv函数来确定最佳的决策树数量。前文中的函数可以完成这个工作。

#Choose all predictors except target & IDcolspredictors = [x for x in train.columns if x not in [target,IDcol]]xgb1 = XGBClassifier( learning_rate =0.1, n_estimators=1000, max_depth=5, min_child_weight=1, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1, seed=27)modelfit(xgb1, train, predictors)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

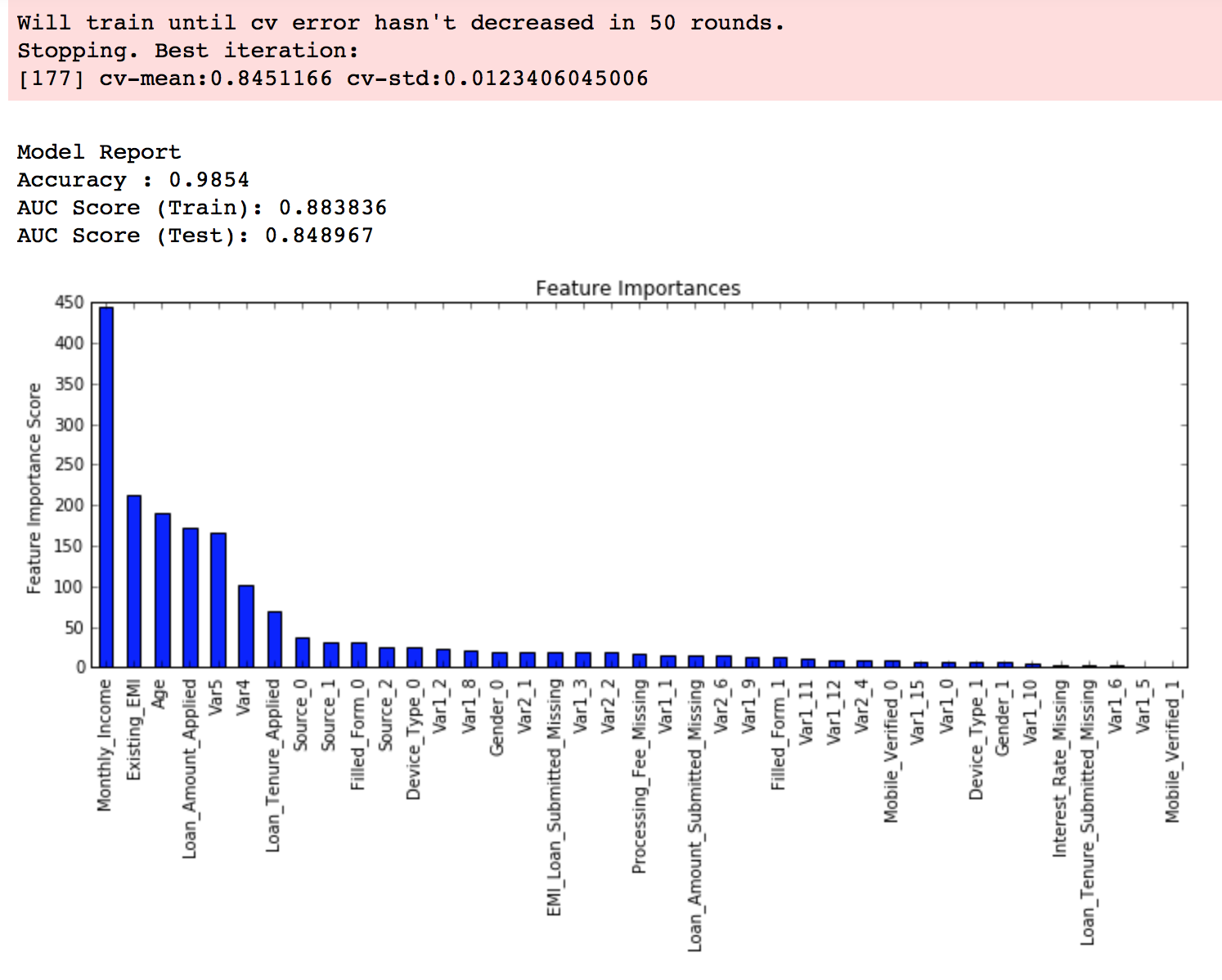

从输出结果可以看出,在学习速率为0.1时,理想的决策树数目是140。这个数字对你而言可能比较高,当然这也取决于你的系统的性能。

注意:在AUC(test)这里你可以看到测试集的AUC值。但是如果你在自己的系统上运行这些命令,并不会出现这个值。因为数据并不公开。这里提供的值仅供参考。生成这个值的代码部分已经被删掉了。

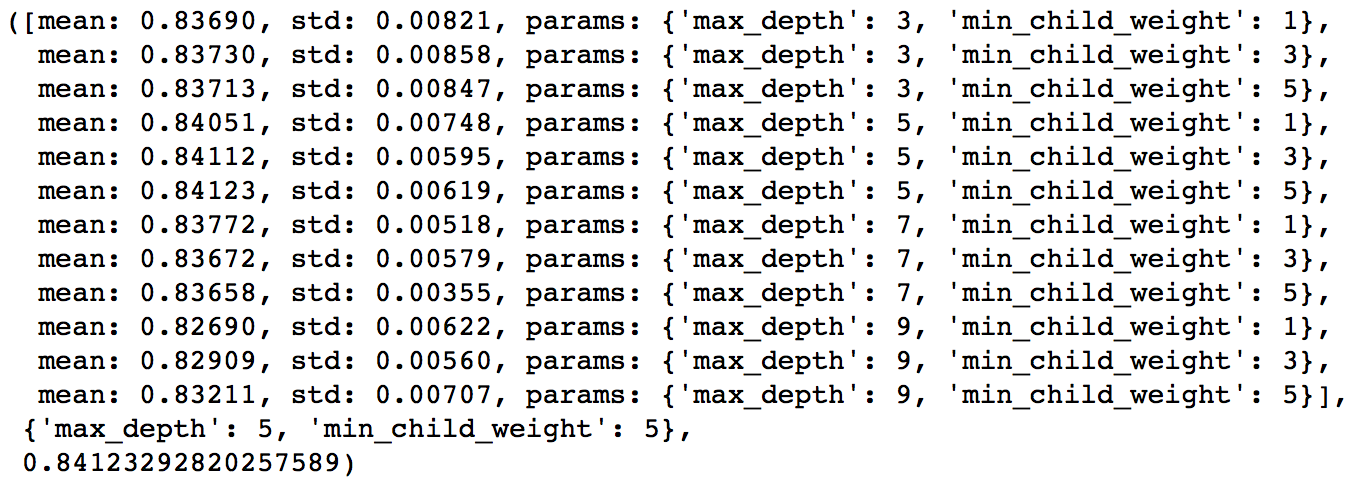

第二步: max_depth 和 min_weight 参数调优

我们先对这两个参数调优,是因为它们对最终结果有很大的影响。首先,我们先大范围地粗调参数,然后再小范围地微调。

注意:在这一节我会进行高负荷的栅格搜索(grid search),这个过程大约需要15-30分钟甚至更久,具体取决于你系统的性能。你也可以根据自己系统的性能选择不同的值。

param_test1 = { 'max_depth':range(3,10,2), 'min_child_weight':range(1,6,2)}gsearch1 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=140, max_depth=5,min_child_weight=1, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1, seed=27), param_grid = param_test1, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch1.fit(train[predictors],train[target])gsearch1.grid_scores_, gsearch1.best_params_, gsearch1.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

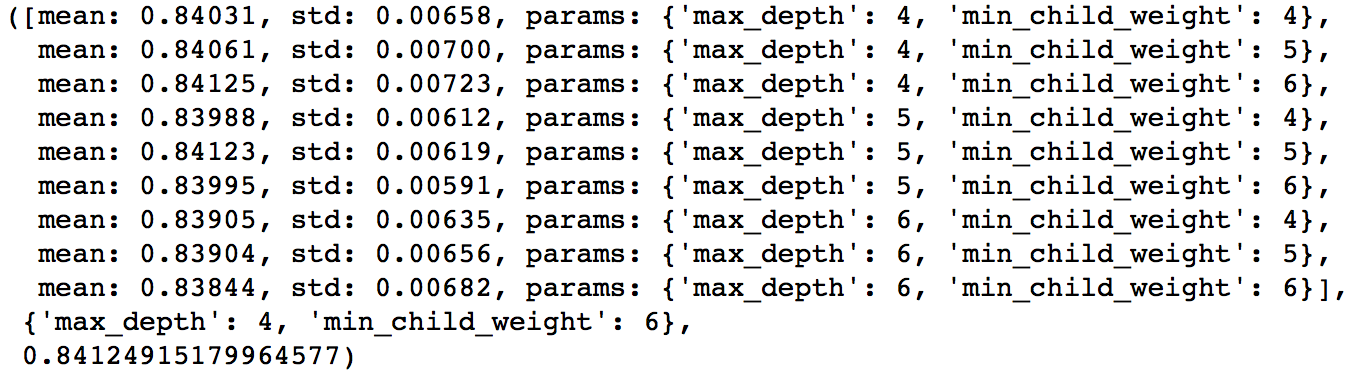

至此,我们对于数值进行了较大跨度的12中不同的排列组合,可以看出理想的max_depth值为5,理想的min_child_weight值为5。在这个值附近我们可以再进一步调整,来找出理想值。我们把上下范围各拓展1,因为之前我们进行组合的时候,参数调整的步长是2。

param_test2 = { 'max_depth':[4,5,6], 'min_child_weight':[4,5,6]}gsearch2 = GridSearchCV(estimator = XGBClassifier( learning_rate=0.1, n_estimators=140, max_depth=5, min_child_weight=2, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test2, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch2.fit(train[predictors],train[target])gsearch2.grid_scores_, gsearch2.best_params_, gsearch2.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

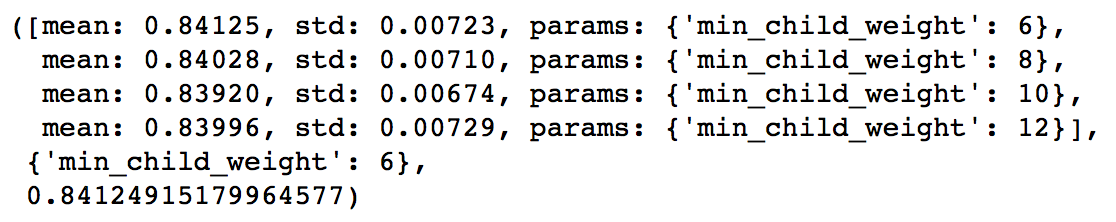

至此,我们得到max_depth的理想取值为4,min_child_weight的理想取值为6。同时,我们还能看到cv的得分有了小小一点提高。需要注意的一点是,随着模型表现的提升,进一步提升的难度是指数级上升的,尤其是你的表现已经接近完美的时候。当然啦,你会发现,虽然min_child_weight的理想取值是6,但是我们还没尝试过大于6的取值。像下面这样,就可以尝试其它值。

param_test2b = { 'min_child_weight':[6,8,10,12] }gsearch2b = GridSearchCV(estimator = XGBClassifier( learning_rate=0.1, n_estimators=140, max_depth=4, min_child_weight=2, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test2b, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch2b.fit(train[predictors],train[target])modelfit(gsearch3.best_estimator_, train, predictors)gsearch2b.grid_scores_, gsearch2b.best_params_, gsearch2b.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

我们可以看出,6确确实实是理想的取值了。

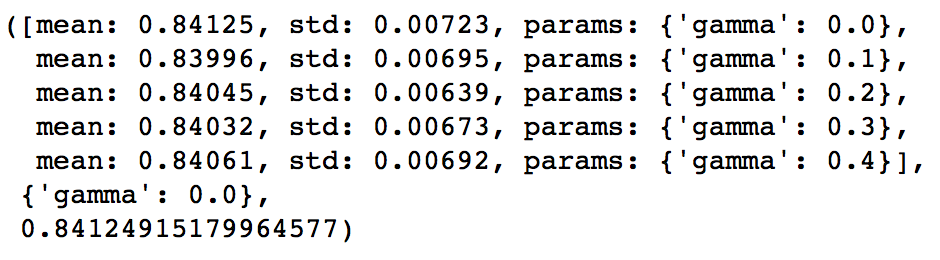

第三步:gamma参数调优

在已经调整好其它参数的基础上,我们可以进行gamma参数的调优了。Gamma参数取值范围可以很大,我这里把取值范围设置为5了。你其实也可以取更精确的gamma值。

param_test3 = { 'gamma':[i/10.0 for i in range(0,5)]}gsearch3 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=140, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test3, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch3.fit(train[predictors],train[target])gsearch3.grid_scores_, gsearch3.best_params_, gsearch3.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

从这里可以看出来,我们在第一步调参时设置的初始gamma值就是比较合适的。也就是说,理想的gamma值为0。在这个过程开始之前,最好重新调整boosting回合,因为参数都有变化。

从这里,可以看出,得分提高了。所以,最终得到的参数是:

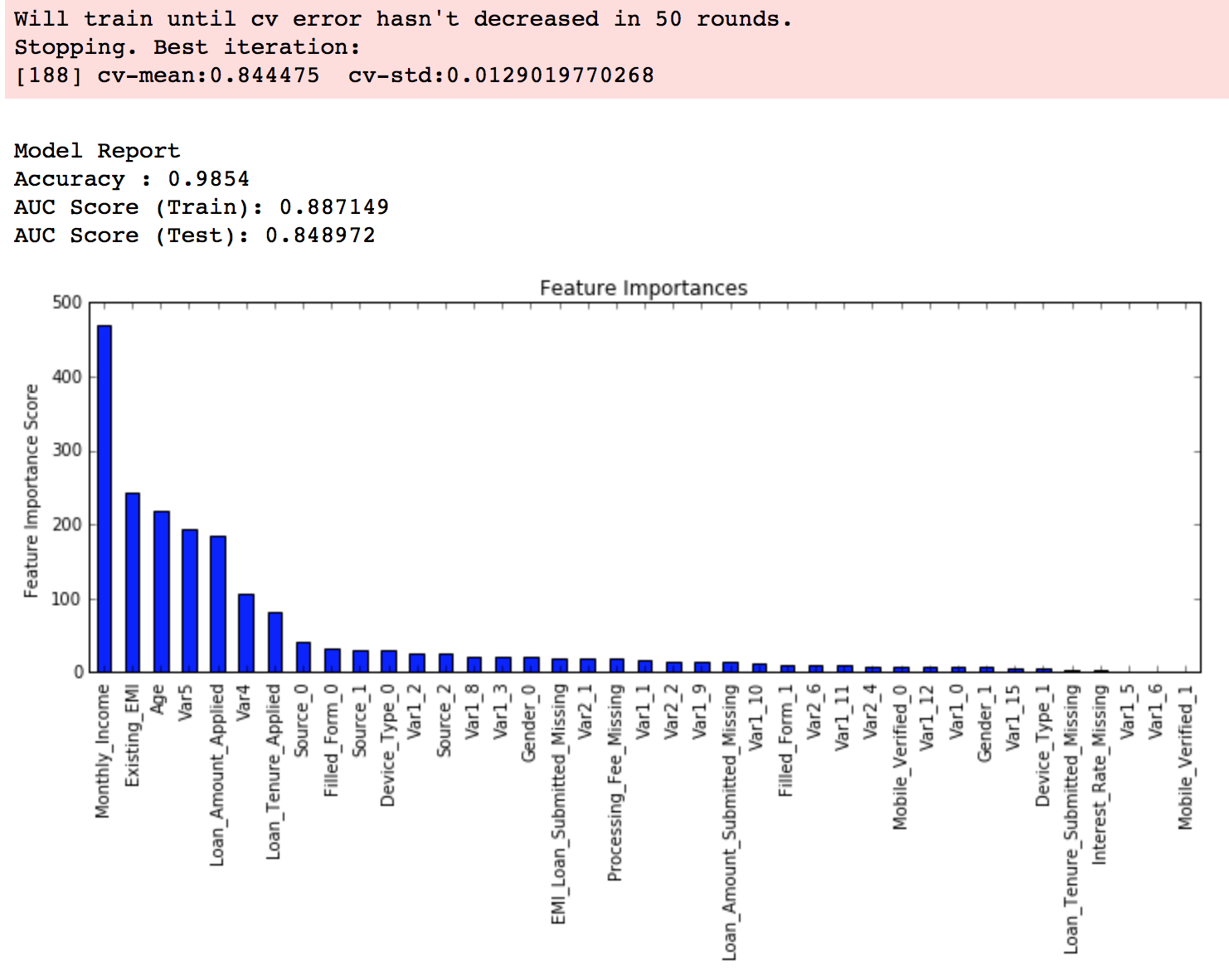

xgb2 = XGBClassifier( learning_rate =0.1, n_estimators=1000, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4,scale_pos_weight=1,seed=27)modelfit(xgb2, train, predictors)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

第四步:调整subsample 和 colsample_bytree 参数

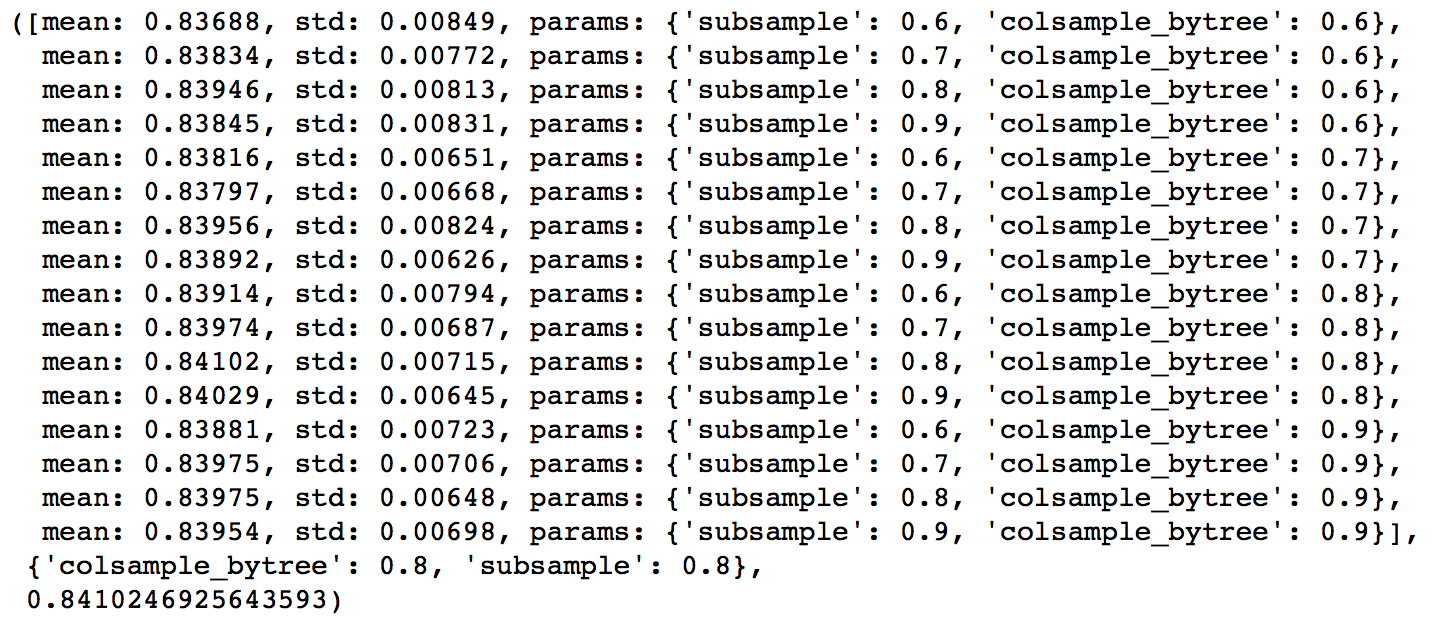

下一步是尝试不同的subsample 和 colsample_bytree 参数。我们分两个阶段来进行这个步骤。这两个步骤都取0.6,0.7,0.8,0.9作为起始值。

param_test4 = { 'subsample':[i/10.0 for i in range(6,10)], 'colsample_bytree':[i/10.0 for i in range(6,10)]}gsearch4 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=177, max_depth=3, min_child_weight=4, gamma=0.1, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test4, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch4.fit(train[predictors],train[target])gsearch4.grid_scores_, gsearch4.best_params_, gsearch4.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

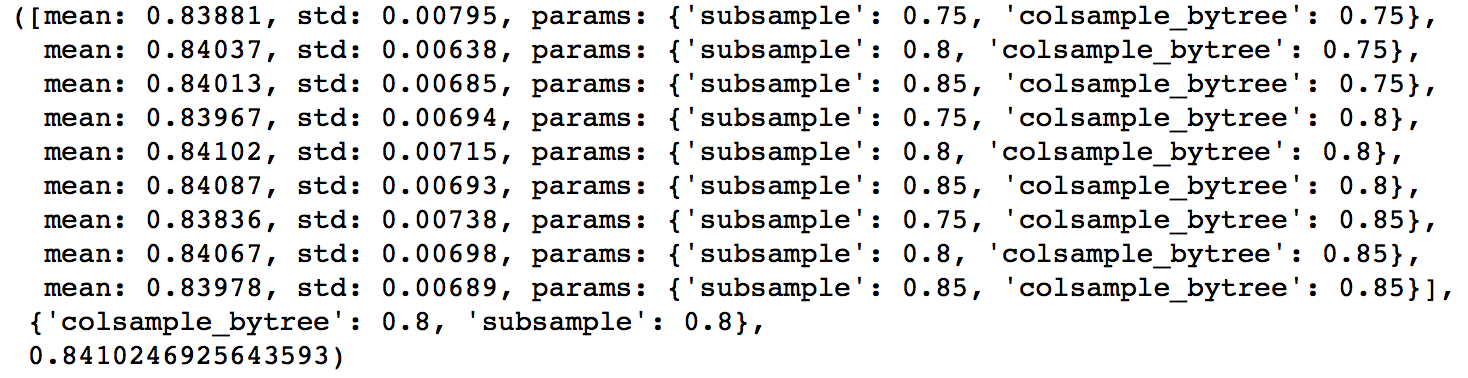

从这里可以看出来,subsample 和 colsample_bytree 参数的理想取值都是0.8。现在,我们以0.05为步长,在这个值附近尝试取值。

param_test5 = { 'subsample':[i/100.0 for i in range(75,90,5)], 'colsample_bytree':[i/100.0 for i in range(75,90,5)]}gsearch5 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=177, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test5, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch5.fit(train[predictors],train[target])- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

我们得到的理想取值还是原来的值。因此,最终的理想取值是:

- subsample: 0.8

- colsample_bytree: 0.8

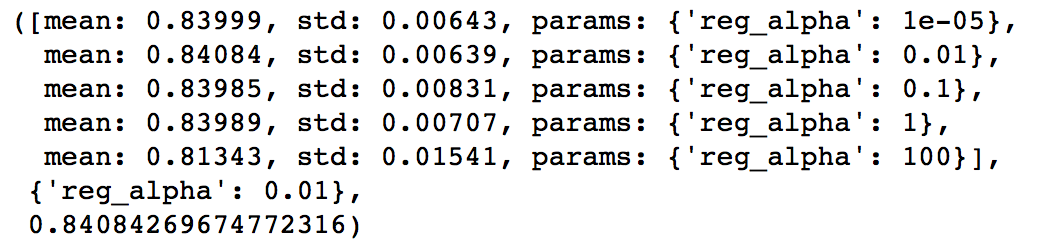

第五步:正则化参数调优

下一步是应用正则化来降低过拟合。由于gamma函数提供了一种更加有效地降低过拟合的方法,大部分人很少会用到这个参数。但是我们在这里也可以尝试用一下这个参数。我会在这里调整’reg_alpha’参数,然后’reg_lambda’参数留给你来完成。

param_test6 = { 'reg_alpha':[1e-5, 1e-2, 0.1, 1, 100]}gsearch6 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=177, max_depth=4, min_child_weight=6, gamma=0.1, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test6, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch6.fit(train[predictors],train[target])gsearch6.grid_scores_, gsearch6.best_params_, gsearch6.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

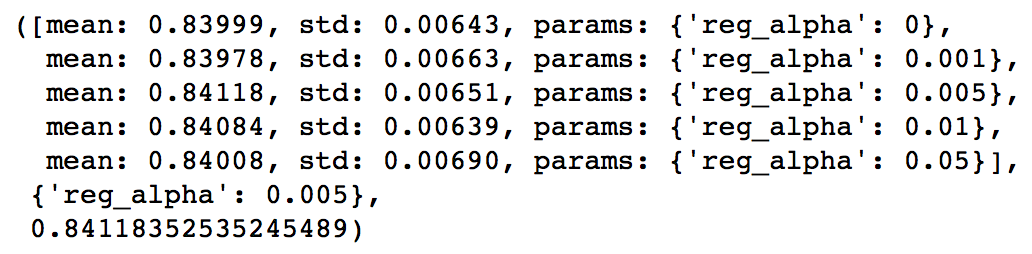

我们可以看到,相比之前的结果,CV的得分甚至还降低了。但是我们之前使用的取值是十分粗糙的,我们在这里选取一个比较靠近理想值(0.01)的取值,来看看是否有更好的表现。

param_test7 = { 'reg_alpha':[0, 0.001, 0.005, 0.01, 0.05]}gsearch7 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=177, max_depth=4, min_child_weight=6, gamma=0.1, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test7, scoring='roc_auc',n_jobs=4,iid=False, cv=5)gsearch7.fit(train[predictors],train[target])gsearch7.grid_scores_, gsearch7.best_params_, gsearch7.best_score_- 1

- 2

- 3

- 4

- 5

- 6

- 7

可以看到,CV的得分提高了。现在,我们在模型中来使用正则化参数,来看看这个参数的影响。

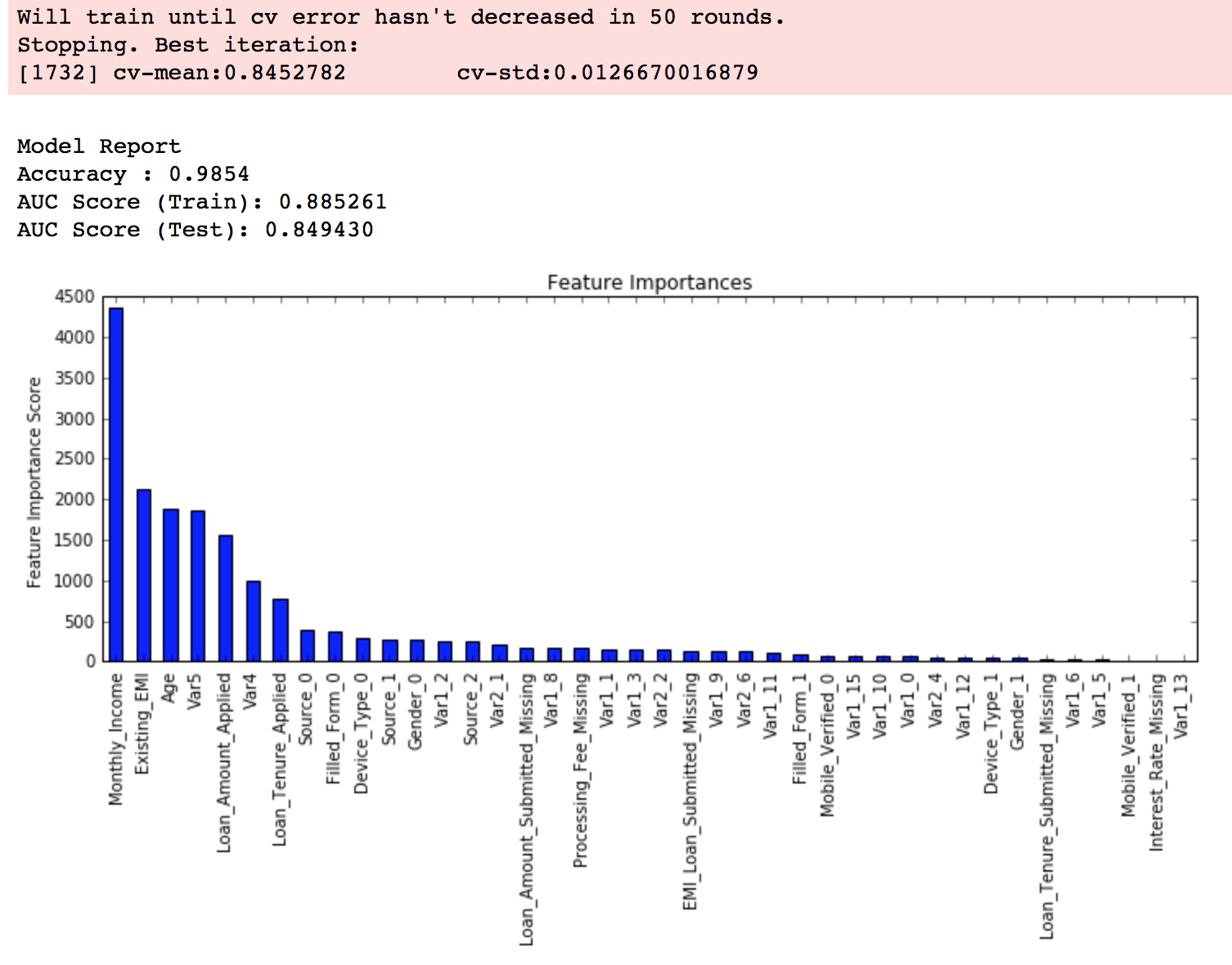

xgb3 = XGBClassifier( learning_rate =0.1, n_estimators=1000, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, reg_alpha=0.005, objective= 'binary:logistic', nthread=4, scale_pos_weight=1, seed=27)modelfit(xgb3, train, predictors)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

然后我们发现性能有了小幅度提高。

第6步:降低学习速率

最后,我们使用较低的学习速率,以及使用更多的决策树。我们可以用XGBoost中的CV函数来进行这一步工作。

xgb4 = XGBClassifier( learning_rate =0.01, n_estimators=5000, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, reg_alpha=0.005, objective= 'binary:logistic', nthread=4, scale_pos_weight=1, seed=27)modelfit(xgb4, train, predictors)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

至此,你可以看到模型的表现有了大幅提升,调整每个参数带来的影响也更加清楚了。

在文章的末尾,我想分享两个重要的思想:

1、仅仅靠参数的调整和模型的小幅优化,想要让模型的表现有个大幅度提升是不可能的。GBM的最高得分是0.8487,XGBoost的最高得分是0.8494。确实是有一定的提升,但是没有达到质的飞跃。

2、要想让模型的表现有一个质的飞跃,需要依靠其他的手段,诸如,特征工程(feature egineering) ,模型组合(ensemble of model),以及堆叠(stacking)等。

你可以从 这里 下载iPython notebook文件,里面包含了文章中提到的所有代码。如果你使用R语言,请阅读这篇文章。

结束语

这篇文章主要讲了如何提升XGBoost模型的表现。首先,我们介绍了相比于GBM,为何XGBoost可以取得这么好的表现。紧接着,我们介绍了每个参数的细节。我们定义了一个可以重复使用的构造模型的函数。

最后,我们讨论了使用XGBoost解决问题的一般方法,在AV Data Hackathon 3.x problem数据上实践了这些方法。

希望看过这篇文章之后,你能有所收获,下次使用XGBoost解决问题的时候可以更有信心哦~

- 本文已收录于以下专栏:

- 机器学习与数据挖掘

qq_38843972

6天前 19:03 6楼- File C:/Users/YTH/untitled1.py, line 48, in modelfit

feat_imp1 = pd.Series(alg.booster().get_fscore())

TypeError: str object is not callable

qq_35776173

2017-09-30 15:14 5楼- 我用python3.x运行代码,如果后面同学也是如果遇到和我同样的问题可参考:

def modelfit 中

cvresult = xgb.cv(xgb_param, xgtrain, num_boost_round=alg.get_params()['n_estimators'], nfold=cv_folds,

metrics='auc', early_stopping_rounds=early_stopping_rounds, show_progress=False)

errer关于show_progress=False, 去掉此参数即可。

调整参数 max_depth,因py2与py3 range函数有改变,故代码应修改为:

param_test1 = { #调整参数,

'max_depth':list(range(3,10,2)),

'min_child_weight':list(range(1,6,2))

}

u013527905

2017-08-15 14:47 4楼- 这个预测出来的值dtrain_predictions都是0啊

相关文章推荐

XGBoost-Python完全调参指南-参数解释篇

关于XGBoost的参数,发现已经有比较完善的翻译了。故本文转载其内容,并作了一些修改与拓展。原文链接见:http://blog.csdn.net/zc02051126/article/detail...

- wzmsltw

- 2016年03月27日 22:28

- 38102

xgboost入门与实战(实战调参篇)

xgboost入门与实战(实战调参篇)前言前面几篇博文都在学习原理知识,是时候上数据上模型跑一跑了。本文用的数据来自kaggle,相信搞机器学习的同学们都知道它,kaggle上有几个老题目一直开放,适...

- sb19931201

- 2016年09月18日 20:33

- 15353

都是前端,月薪20K和40k的开发到底差距在哪?

大学毕业后我成为前端开发者,从一开始的小白到现在的“高手”,我把一些感想记录下来...

xgboost使用调参

github:https://github.com/dmlc/xgboost 论文参考:http://www.kaggle.com/blobs/download/forum-message-atta...

- q383700092

- 2016年12月20日 15:14

- 7171

xgboost 调参经验

首先 parameters 设置如下:params = { 'booster':'gbtree', 'objective':'binary:logist...

- u010414589

- 2016年04月14日 21:03

- 22561

xgboost入门与实战(实战调参篇)

本文转载自:http://blog.csdn.net/sb19931201/article/details/52577592xgboost入门与实战(实战调参篇)前言前...

- chivalrousli

- 2017年01月13日 15:55

- 1291

人人都能看懂的 AI 入门课

本课程将讲述人工智能的现状、应用场景和入门方法,并通过运用 TensorFlow,使得受众能清晰了解人工智能的运作方式。

XGBoost:参数解释

XGBoost参数在运行XGboost之前,必须设置三种类型成熟:general parameters,booster parameters和task parameters:General para...

- zc02051126

- 2015年07月01日 17:06

- 48860

XGBoost-Python完全调参指南-介绍篇

在analytics vidhya上看到一篇,写的很好。因此打算翻译一下这篇文章,也让自己有更深的印象。具体内容主要翻译文章的关键意思。原文见:http://www.analyticsvidh...

- wzmsltw

- 2016年03月26日 19:32

- 4043

xgboost 调参经验

转自: http://blog.csdn.net/u010414589/article/details/51153310本文介绍三部分内容: - xgboost 基本方法和默认参数 ...

- xuxiatian

- 2017年01月09日 13:28

- 1401

xgboost调参

Xgboost调参英文版参考:https://www.analyticsvidhya.com/blog/2016/03/complete-guide-parameter-tuning-xgboos...

- u014265088

- 2016年11月30日 19:11

- 357

XGBoost简易调参指南

本文为kaggle上一位选手分享的xgboost调参经验的翻译。方便对xgboost模型参数的快速调试。原文:https://www.kaggle.com/c/bnp-paribas-cardif...

- wzmsltw

- 2016年10月01日 20:03

- 3217

XGBoost参数调优完全指南(附Python代码)

XGBoost参数调优完全指南(附Python代码) 原文地址:Complete Guide to Parameter Tuning in XGBoost (with codes in Pytho...

- u010657489

- 2016年07月19日 09:32

- 10594

机器学习sklearn参数解释(GDBT+XGBOOST)

机器学习总结-sklearn参数解释实验数据集选取:1分类数据选取 load_iris 鸢尾花数据集from sklearn.datasets import load_irisdata ...

- wuxiaosi808

- 2017年09月20日 08:58

- 429

xgboost入门与实战(实战调参篇) 标签: xgboostpythonkaggle机器学习

xgboost入门与实战(实战调参篇)原文地址前言前面几篇博文都在学习原理知识,是时候上数据上模型跑一跑了。本文用的数据来自kaggle,相信搞机器学习的同学们都知道它,kaggl...

- u011089523

- 2017年05月30日 21:47

- 1797

XGboost 调参指南+CV调参

参考网站:http://blog.csdn.net/cyh_24/article/details/50593400重要参数: scale_pos_weight含义:二分类中正负样本比例失衡,需要设...

- u012969412

- 2017年05月07日 15:11

- 1080

XGBoost:在Python中使用XGBoost

在Python中使用XGBoost下面将介绍XGBoost的Python模块,内容如下: * 编译及导入Python模块 * 数据接口 * 参数设置 * 训练模型l * 提前终止程序 * ...

- zc02051126

- 2015年07月06日 11:27

- 65695

XGBoost-Python完全调参指南-参数解释篇

在analytics vidhya上看到一篇Python>,写的很好。因此打算翻译一下这篇文章,也让自己有更深的印象。具体内容主要翻译文章的关键意思。原文见:http://www....

- chuanda112233

- 2016年07月14日 21:53

- 3500

windows下Python机器学习依赖库安装——numpy、scipy、sklearn、xgboost、theano等

windows下python依赖包安装,写给新手朋友,少一点弯路!

- a132582

- 2017年04月22日 00:26

- 3021

Sklearn,xgboost机器学习多分类实验

多分类是一个机器学习的常见任务,本文将基于复旦大学中文文本分类语料,使用sklearn和xgboost来进行多分类实验。...

- jaylenzhang

- 2017年03月08日 21:20

- 2225

XGBOOST参数说明

XGBoost参数XGBoost的参数可以分为三种类型:通用参数、booster参数以及学习目标参数General parameters:参数控制在提升(boosting)过程...

- wang1127248268

- 2016年12月11日 22:13

- 1094

XGBoost:在Python中使用XGBoost

在Python中使用XGBoost下面将介绍XGBoost的Python模块,内容如下:* 编译及导入Python模块* 数据接口* 参数设置* 训练模型l* 提前终止程序* 预测...

- levy_cui

- 2017年03月08日 17:30

- 695

sklearn 样本均衡 class_weight='balanced'的实现方法

想了解这个的原因,是因为Gbdt不能设置这个参数,但是GBDT是最常用的分类器了...查了一会儿还想了下原理,想知道原理上为啥gbdt不能设置class_weight... 然后发现虽然sklea...

- u011026968

- 2017年04月26日 01:13

- 2640

iphone分辨率中的scale参数

A UIScreen object contains the bounding rectangle of the device’s entire screen. When setting up you...

- fanyong245758753

- 2016年12月19日 15:43

- 270

xgboost参数调整

转自:https://www.analyticsvidhya.com/blog/2016/03/complete-guide-parameter-tuning-xgboost-with-codes-p...

- webzjuyujun

- 2016年08月04日 10:22

- 5372

机器学习算法总结--GBDT

参考如下机器学习(四)— 从gbdt到xgboost机器学习常见算法个人总结(面试用)xgboost入门与实战(原理篇)简介 GBDT是一个基于迭代累加的决策树算法,它通过构造一组弱的学习...

- lc013

- 2017年02月23日 17:09

- 3830

记一次失败的kaggle比赛(3):失败在什么地方,贪心筛选特征、交叉验证、blending

今天这个比赛结束了,结果可以看:https://www.kaggle.com/c/santander-customer-satisfaction/leaderboardpublic结果:p...

- mmc2015

- 2016年05月03日 09:55

- 8561

xgboost原理

文章内容可能会相对比较多,读者可以点击上方目录,直接阅读自己感兴趣的章节。1.序 距离上一次编辑将近10个月,幸得爱可可老师(微博)推荐,访问量陡增。最近毕业论文与xgboost相关,于是重新写一下...

- a819825294

- 2016年04月21日 10:15

- 86227

xgboost特征选择

Xgboost在各大数据挖掘比赛中是一个大杀器,往往可以取得比其他各种机器学习算法更好的效果。数据预处理,特征工程,调参对Xgboost的效果有着非常重要的影响。这里介绍一下运用xgboost的特征选...

- qq_34264472

- 2016年11月27日 11:22

- 10632

Kaggle 神器 xgboost

在 Kaggle 的很多比赛中,我们可以看到很多 winner 喜欢用 xgboost,而且获得非常好的表现,今天就来看看 xgboost 到底是什么以及如何应用。本文结构:什么是 xgboost?...

- aliceyangxi1987

- 2017年06月09日 20:10

- 3549

xgboost的使用简析

前言——记得在阿里mllib实习的时候,大家都是用mllib下的GBDT来train model的。但由于mllib不是开源的,所以在公司外是不能够使用。后来参加kaggle比赛的时候,认识到一个GD...

- John159151

- 2015年05月07日 02:43

- 19346

Titanic Xgboost版代码分析

代码来源 关于xbgboost的调参可参考这篇文章 或官网 流程如下: 1. 读取测试集,训练集 2. 根据相关性手动选取特征 3. 选取测试集 4. 填充缺失值 5. 处理...

- qq_16234613

- 2017年03月21日 19:27

- 798

基于Python的Xgboost模型实现

# -*- coding: utf-8 -*-"""Created on Mon Nov 28 13:22:08 2016@author: ym"""## part1: 模型训练i...

- u010035907

- 2016年12月01日 09:43

- 4229

在Python中使用XGBoost

转自:http://blog.csdn.net/zc02051126/article/details/46771793下面将介绍XGBoost的Python模块,内容如下: * 编译及导入Py...

- xuxiatian

- 2017年01月08日 08:07

- 1146

win10(64位)python xgboost 详细安装教程

win10(64位)python xgboost 安装教程在看一些数据挖掘比赛的经验分享,看到很多都用到了xgboost并取得不错效果,于是down了大神们的解决方案,结合他们的代码学习数据挖掘比赛...

- sb19931201

- 2016年08月18日 00:10

- 5575

Delphi7高级应用开发随书源码

- 2003年04月30日 00:00

- 676KB

- 下载

xgboost在Python的安装

xgboost在Python的安装第一步:在github下载xgboost,地址:github,xgboost第二步,编译生成xgboost_wrapper.dll(用于python)...

- songying2012

- 2015年12月23日 09:21

- 6502

python 中 xgboost 安装

针对 下载并利用VS2013编译xgboost后安装失败,进行其他方法安装。下载安装 MinGW-64: http://sourceforge.net/projects/mingw-w64/...

- onepiecehuiyu

- 2016年05月12日 21:03

- 5085

windows系统下安装python xgboost

1.python 64位,需要提前安装numpy和scipy包。2.下载安装Windows下的gcc编译器,选择64位,一定要用tdm-gcc而不是mingw,切记。下载链接http://sour...

- yscyh

- 2017年06月01日 18:40

- 672

XGBoost实战与调优

首先,python和Anaconda都没有自带xgboost。windows下安装xgboost非常方便。在前面的文章中,提供了下载地址和详细的安装步骤。 你可以在python中,输入i...

- weixin_38569817

- 2017年07月29日 21:13

- 347

Xgboost的参数解释

XGBoost 参数说明

- u013963380

- 2017年05月25日 17:19

- 820

xgboost 参数 scale_pos_weight 详解

从官网解说、源码和实验三个角度来解说 xgboost 参数: scale_pos_weight

- h4565445654

- 2017年05月16日 12:42

- 2639

xgboost入门与实战(原理篇)

xgboost入门与实战(原理篇)前言: xgboost是大规模并行boosted tree的工具,它是目前最快最好的开源boosted tree工具包,比常见的工具包快10倍以上。在数据科学方面...

- sb19931201

- 2016年09月16日 20:26

- 44220

XGBoost-Python完全调参指南-参数解释篇

转自:http://blog.csdn.net/wzmsltw/article/details/50994481在analytics vidhya上看到一篇Python>,写的很好。因此打算翻译...

- xuxiatian

- 2017年01月06日 11:15

- 1084

xgboost原理及应用

1.背景关于xgboost的原理网络上的资源很少,大多数还停留在应用层面,本文通过学习陈天奇博士的PPT地址和xgboost导读和实战 地址,希望对xgboost原理进行深入理解。2.xgbo...

- wuzhongdehua1

- 2016年09月09日 16:29

- 1365

xgboost 参数

XGBoost的参数XGBoost的作者把所有的参数分成了三类:1、通用参数:宏观函数控制。2、Booster参数:控制每一步的booster(tree/regression)。3、学习目标...

- vfgbv

- 2017年05月31日 14:29

- 222

XGBoost参数说明

XGBoost Parameters来源:(https://github.com/dmlc/xgboost/blob/master/doc/parameter.md) Before running ...

- songying2012

- 2015年12月25日 15:35

- 2917

XGBoost参数调优

摘要:转载:http://blog.csdn.net/han_xiaoyang/article/details/526653961. 简介如果你的预测模型表现得有些不尽如人意,那就用XG...

- hhy518518

- 2017年02月12日 17:52

- 1129

xgboost参数详解

XGBoost参数包括:general parameters,booster参数booster parameters和目标参数task parameters:General parameters:参数...

- u013714645

- 2017年08月14日 15:11

- 112

XGBoost处理缺失值(Null)问题

对于数据缺失的问题,XGBoost设计了很好的默认机制处理这个问题。以下摘自陈天奇在GitHub讨论组中的讨论。 You can directly feed data in as spars...

- VitoDi

- 2017年03月02日 16:36

- 1017

一步一步理解GB、GBDT、xgboost

GBDT和xgboost在竞赛和工业界使用都非常频繁,能有效的应用到分类、回归、排序问题,虽然使用起来不难,但是要能完整的理解还是有一点麻烦的。本文尝试一步一步梳理GB、GBDT、xgboost,它们...

- shenxiaoming77

- 2016年05月31日 09:08

- 19209

Xgboost筛选特征重要性

import pandas as pdimport xgboost as xgbimport operatorfrom matplotlib import pylab as pltdef cea...

- q383700092

- 2016年12月16日 21:00

- 6347

机器学习中的数据不平衡解决方案大全

在机器学习任务中,我们经常会遇到这种困扰:数据不平衡问题。 数据不平衡问题主要存在于有监督机器学习任务中。当遇到不平衡数据时,以总体分类准确率为学习目标的传统分类算法会过多地关注多数类,从...

- u013709270

- 2017年06月09日 19:37

- 19337

xgboost笔记

已经在公司用上了xgboost,但是知识作为黑盒在用。有必要深入了解下?以下分为几个部分进行总结:基础原理,使用方法,最佳实践。1. 基础原理了解xgboost的工作原理,为什么运行快,效果还好。1....

- aiyaya1689

- 2017年01月13日 00:06

- 569

python xgboost算法实践

xgboost算法实践

- yanyanyufei96

- 2017年04月21日 20:29

- 1077

XGBoost解决多分类问题

XGBoost解决多分类问题

- Leo_Xu06

- 2016年09月03日 19:25

- 6499

XGBoost参数调优完全指南(附Python代码)

译注:文内提供的代码和运行结果有一定差异,可以从这里下载完整代码对照参考。另外,我自己跟着教程做的时候,发现我的库无法解析字符串类型的特征,所以只用其中一部分特征做的,具体数值跟文章中不一样,反而可以...

- u010035907

- 2016年11月05日 15:57

- 797

XGBoost参数调优完全指南

1. 简介如果你的预测模型表现得有些不尽如人意,那就用XGBoost吧。XGBoost算法现在已经成为很多数据工程师的重要武器。它是一种十分精致的算法,可以处理各种不规则的数据。 构造一个...

- fly_time2012

- 2017年04月25日 20:43

- 446

XGBoost参数调优

1、XGBoost的优势XGBoost(eXtreme Gradient Boosting)是Gradient Boosting算法的一个优化的版本。XGBoost算法可以给预测模型带来能力的提...

- xiaocong1990

- 2017年02月15日 12:37

- 668

64位win10下安装xgboost python包的教程

64位win10下安装xgboost python包的教程xgboost的 Python包在windows环境下使用MicrosoftVisual Studio安装的功能被陈天奇大神删掉了,如下是c...

- zyghs

- 2016年03月15日 16:38

- 9207

重点:机器学习总结之各算法常用包和函数

基本操作常用函数及包预测函数:predict() type=”prob”判别该量度的昆虫归类为A、B和C的概率;type=”response”:判别该量度的昆虫的类别; 预测分类的概率的函数pr...

- qq_16365849

- 2016年02月09日 13:43

- 13528

XGBoost原理与应用

基本构成boosted tree作为有监督学习算法有几个重要部分:模型、参数、目标函数、优化算法 模型 模型指给定输入x如何去预测输出y 参数 参数指我们需要学习的东西,在线性模型中,参数指我...

- q383700092

- 2017年03月09日 10:17

- 1793

Gradient Tree Boosting (GBM, GBRT, GBDT, MART)算法解析和基于XGBoost/Scikit-learn的实现

1. 概要Gradient Tree Boosting (别名 GBM, GBRT, GBDT, MART)是一类很常用的集成学习算法,在KDD Cup, Kaggle组织的很多数据挖掘竞赛中多次表...

- yangliuy

- 2017年03月16日 12:57

- 2857

机器学习系列(11)_Python中Gradient Boosting Machine(GBM)调参方法详解

这篇文章详细地介绍了GBM模型。我们首先了解了何为boosting,然后详细介绍了各种参数。 这些参数可以被分为3类:树参数,boosting参数,和其他影响模型的参数。最后我们提到了用GBM解决问题...

- yaoqiang2011

- 2016年09月25日 17:33

- 28909

机器学习竞赛技巧

Kaggle 是目前最大的 Data Scientist 聚集地。很多公司会拿出自家的数据并提供奖金,在 Kaggle 上组织数据竞赛。我最近完成了第一次比赛,在 2125 个参赛队伍中排名第 9...

- wtq1993

- 2016年05月15日 20:56

- 9160

python之sklearn

Scikit Learn: 在python中机器学习Warning警告:有些没能理解的句子,我以自己的理解意译。翻译自:Scikit Learn:Machine Lea...

- liujiandu101

- 2016年06月13日 09:27

- 6157

机器学习(四)--- 从gbdt到xgboost

gbdt(又称Gradient Boost Decision Tree),是一种迭代的决策树算法,该算法由多个决策树组成。它最早见于yahoo,后被广泛应用在搜索排序、点击率预估上。xgboost是...

- china1000

- 2016年04月09日 19:34

- 17226

2017.07.31回顾 LabelEncoder xgb.cv

1、花了少量时间补充上周五的小结2、然后开始继续抄作业kernel去除outliers的方法是用的常数,-0.4和0.4,为什么这样设计,并没有给出说明,这个值是介于2 delta和3...

- strwolf

- 2017年07月31日 20:25

- 376

【R机器学习笔记】XGBoost——XGBboost包

转载“素质云博客“,自己做了些修改,以及自己的一些见解一 XGBoost来历二 优势性价比实际案例1 如何实现2 one-hot encode 独热编码独有的数据结构三 XGBoost用...

- langyichao1

- 2017年04月15日 10:52

- 669

XGBoost-Python完全调参指南-参数解释篇

关于XGBoost的参数,发现已经有比较完善的翻译了。故本文转载其内容,并作了一些修改与拓展。原文链接见:http://blog.csdn.net/zc02051126/article/detail...

- wzmsltw

- 2016年03月27日 22:28

- 38102

机器学习系列(11)_Python中Gradient Boosting Machine(GBM)调参方法详解

这篇文章详细地介绍了GBM模型。我们首先了解了何为boosting,然后详细介绍了各种参数。 这些参数可以被分为3类:树参数,boosting参数,和其他影响模型的参数。最后我们提到了用GBM解决问题...

- yaoqiang2011

- 2016年09月25日 17:33

- 28909

机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

原文地址:Complete Guide to Parameter Tuning in XGBoost by Aarshay Jain 原文翻译与校对:@MOLLY && 寒小阳 (hanxiaoya...

- u010480899

- 2016年12月24日 12:38

- 770

XGBoost中参数调优的完整指南(含Python-3.X代码)

本文实现了端到端的基于XGBoost模型的参数调优。 我们首先讨论为什么XGBoost比GBM具有更好的性能,然后详细讨论了所涉及的各种参数。 我们还定义了一个通用函数,可以重新用于其他模型。...

- kicilove

- 2017年11月01日 13:32

- 1076

机器学习实战(包括中文版教材,书中python代码及所需数据)

- 2016年02月29日 21:52

- 46.85MB

- 下载

机器学习/逻辑回归(logistic regression)/--附python代码

本文为吴恩达《机器学习》课程的读书笔记,并用python实现。逻辑回归(logistic regression)虽然叫回归,但他做的事实际上是分类。这里我们讨论二元分类,即只分两类,y属于{0,1...

- helen1313

- 2016年10月27日 15:27

- 1097

机器学习线性回归(linear regression)/梯度下降法(gradient descent)/最大似然函数/--附python代码

线性回归是一个比较简单的算法,这里主要借线性回归,讲一下梯度下降法和最大似然函数,后面逻辑回归也会用到。...

- helen1313

- 2016年10月27日 13:57

- 1251

【机器学习】Python sklearn包的使用示例以及参数调优示例

# coding=utf-8# !/usr/bin/env python'''【说明】1.当前sklearn版本0.182.sklearn自带的鸢尾花数据集样例:(1)样本特征矩阵(类型:...

- wy_0928

- 2017年03月17日 15:30

- 4226

机器学习实战 第二章KNN(1)python代码及注释

#coding=utf8#KNN.pyfrom numpy import *import operatordef createDataSet():group=array([[1.0,1....

- fenfenmiao

- 2016年08月09日 19:26

- 2231

机器学习完整过程案例分布解析,python代码解析

所谓学习问题,是指观察由n个样本组成的集合,并根据这些数据来预测未知数据的性质。学习任务(一个二分类问题):区分一个普通的互联网检索Query是否具有某个垂直领域的意图。假设现在有一个...

- yangxudong

- 2014年05月24日 21:34

- 2682

机器学习 in action 分类器0 python代码解析

KNN (K最近邻接算法)python 语言下的简单实现Machine Learning in Action 给出第一个小例子---最简单的分类器 只涉及最简单的向量知识,主要是python语言...

- mashuaihh

- 2013年09月16日 20:05

- 1570

机器学习实战_初识决策树算法_理解其python代码(一)

(一)计算给定数据集的香农熵(个人理解为计算给定信息集纯度的一种数学计算指标):from math import logdef calcShannonEnt(dataSet):#calculata ...

- qq_36396104

- 2017年08月08日 14:42

- 125

机器学习之决策树(Decision Tree)及其Python代码实现

决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。...

- sinat_35512245

- 2017年02月10日 17:55

- 4474

三十八、100行python代码实现机器学习自动分类

现在朋友圈、公众号、微博信息应接不暇,以微信公众号举例,看技术极客是怎么自动筛出自己想看的文章的,100行机器学习代码就能自动帮你归好类,要想找出想看的和不想看的,你再也不用刷朋友圈了请尊重原创,...

- jiangjingxuan

- 2017年01月25日 11:56

- 1659

机器学习----K-近邻算法(Python代码详解)

本博文的内容主要是我在自学《Machine Learning in Action》的中文版《机器学习实战》的总结。K-近邻算法一、算法概述K-近邻算法就是采用测量不同特征值之间的距离进行分类。 距离...

- Ichimaru_Gin_

- 2016年10月10日 19:56

- 226

机器学习实战_初识kNN算法_理解其python代码

以下为我搜索后结合自己的想法编写,如有侵权,可联系我核实后删除(恕我小白一只~) python基础: numpy: 1、shape函数是numpy.core.fromnumeri...

- qq_36396104

- 2017年07月20日 12:16

- 117

机器学习实战_初识决策树(ID3)算法_理解其python代码(二)

python递归构建决策树:Python 基础: count()方法: Python count() 方法用于统计字符串里某个字符出现的次数。可选参数为在字符串搜索的开始与结束位置。 示例:>>...

- qq_36396104

- 2017年08月08日 22:12

- 117

机器学习笔记(一)朴素贝叶斯的Python代码实现

上研究生的时候,一心想读生物信息学的方向,由此也选修了生物数学,计算生物学等相关课程。给我印象最深的是给我们计算生物学的主讲老师,他北大数学系毕业,后来做起了生物和数学的交叉学科研究。课上讲的一些算法...

- htmlgood

- 2016年05月19日 23:00

- 565

XGBoost-Python完全调参指南-参数解释篇

本文转自XGBoost-Python完全调参指南-参数解释篇。对XGBoost有需要小伙伴可以参看。并在此基础上,添加了一些内容。在analytics vidhya上看到一篇《Complete Gu...

- g11d111

- 2017年06月17日 18:28

- 164

机器学习 - xgboost参数详解

原文见:http://www.analyticsvidhya.com/blog/2016/03/complete-guide-parameter-tuning-xgboost-with-codes...

- ZK_J1994

- 2017年05月08日 17:11

- 388

机器学习可视化:模型评估和参数调优

机器学习可视化:模型评估和参数调优

- x_r_su

- 2016年11月05日 16:49

- 1028

Spark2.0机器学习系列之5:GBDT(梯度提升决策树)、GBDT与随机森林差异、参数调试及Scikit代码分析

GBDT概念 与随机森林的差异 Spark2.0中参数调试

- qq_34531825

- 2016年08月30日 09:04

- 3843

解析机器中加减法对于二进制补码的运用(附python代码)

机器中的加减法并不像我们实际生活中一样,带有正负号,比较容易运算,机器中只有0和1,那就需要一种算法来实现加减法运算。首先,我们要明确目标是要进行带符号的数字(signed)进行加减法运算。由于没...

- Wind_white

- 2016年03月28日 20:57

- 1763

CCTC 2016 聚效广告刘忆智:超越MLLib: 通过XGBoost/MXNet 看Spark上的前沿(深度)机器学习

- 2016年05月16日 18:37

- 1.21MB

- 下载

机器学习系列(9)_机器学习算法一览(附Python和R代码)

转载自:http://blog.csdn.net/longxinchen_ml/article/details/51192086–谷歌的无人车和机器人得到了很多关注,但我们真正的未来却在于...

- qq_26898461

- 2016年04月20日 15:33

- 1752

机器学习系列(9)_机器学习算法一览(附Python和R代码)

写这篇文章的目的,就是希望它可以让有志于从事数据科学和机器学习的诸位在学习算法的路上少走些路。我会在文章中举例一些机器学习的问题,你们也可以在思考解决这些问题的过程中得到启发。我也会写下对于各种机器学...

- longxinchen_ml

- 2016年04月19日 16:58

- 25789

XGBoost-Python完全调参指南-介绍篇

XGBoost-Python完全调参指南-介绍篇 在analytics vidhya上看到一篇,写的很好。因此打算翻译一下这篇文章,也让自己有更深的印象。具体内容主要翻译文章的关键意思。原...

- Jinlong_Xu

- 2017年03月31日 19:43

- 252

《Python大战机器学习》代码

- 2017年08月21日 21:06

- 611KB

- 下载

Spark2.0机器学习系列之12: 线性回归及L1、L2正则化区别与稀疏解

我的博客中参考了大量的文章或者别的作者的博客,有时候疏忽了并未一一标注,本着分享交流知识的目的,如果侵犯您的权利,这并非我的本意,如果您提出来,我会及时改正。概述 线性回归拟合一个因变量与一...

- qq_34531825

- 2016年09月28日 15:38

- 3621

机器学习算法一览(附python和R代码)

机器学习算法一览(附python和R代码)来源:数据观时间:2016-04-19 15:20:43 作者:大数据文摘 “谷歌的无人车和机器人得到了很多关注,但我们真正的未来却在...

- starzhou

- 2016年04月20日 11:19

- 855

机器学习实践系列之12 - OpenCV之三维重建

又一次提到了 三维重建,许是三维重建的应用面太广,从 PrimSense 到 Kinnect 再到RealSense,还有一堆国内的山寨机不表。 从 Kinnect Fusion 到 P...

- linolzhang

- 2017年02月17日 23:05

- 1043

10 种机器学习算法的要点(附 Python 和 R 代码)

前言谷歌董事长施密特曾说过:虽然谷歌的无人驾驶汽车和机器人受到了许多媒体关注,但是这家公司真正的未来在于机器学习,一种让计算机更聪明、更个性化的技术。也许我们生活在人类历史上最...

- fishmai

- 2016年09月12日 17:34

- 824

机器学习算法的要点(附 Python 和 R 代码)

前言谷歌董事长施密特曾说过:虽然谷歌的无人驾驶汽车和机器人受到了许多媒体关注,但是这家公司真正的未来在于机器学习,一种让计算机更聪明、更个性化的技术。也许我们生活在人类历史上最...

- a6225301

- 2016年01月07日 22:54

- 1490

- 机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

- 机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

- 机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

- XGBoost参数调优完全指南(附Python代码)

- XGBoost参数调优完全指南(附Python代码)

- XGBoost参数调优完全指南(附Python代码)

- XGBoost参数调优完全指南(附Python代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习系列(9)_机器学习算法一览(附Python和R代码)

- 机器学习算法一览(附python和R代码)

- 机器学习/逻辑回归(logistic regression)/--附python代码

- 机器学习算法一览(附python和R代码)

- 【机器学习系列】SVD奇异值分解(python代码)

- 10 种机器学习算法的要点(附 Python 和 R 代码)(转载)

- Struts2请求处理流程及源码分析

- selenium之 chromedriver与chrome版本映射表(更新至v2.33)

- 异常处理--输入整数

- noip2015D1T1 信息传递(并查集判环)

- 未分类杂谈

- 机器学习系列(12)_XGBoost参数调优完全指南(附Python代码)

- YCJSOI1472 质数取石子(博弈dp)

- java方法练习

- 刨根问底--action属性赋值过程分析

- centos7 配置MariaDB

- 2Java注释、标识符、数据类型、类型转换

- 011 在使用https get的时候报Error creating SSL context ()错误

- C语言总述

- arcgis已知坐标点转面(通过excel文件)