[DeeplearningAI笔记]ML strategy_2_3迁移学习/多任务学习

来源:互联网 发布:做网站 知乎 编辑:程序博客网 时间:2024/05/02 04:28

机器学习策略-多任务学习

Learninig from multiple tasks

觉得有用的话,欢迎一起讨论相互学习~Follow Me

2.7 迁移学习 Transfer Learninig

- 神经网络可以从一个任务中习得知识,并将这些知识应用到另一个独立的任务中.例如:你已经训练好一个能够识别猫的系统,你利用这些知识或者这些知识的部分去完成更好的 阅读X射线扫描图.

- 这就是所谓的– 迁移学习

how-to

- 假设你已经训练好一个图像识别神经网络,首先用一个神经网络,在(x,y)对上训练,其中x是图像,y是对象的标签.

- 现在把这个神经网络拿出来,将其适应(迁移)到不同任务中所学到的知识,比如放射科诊断.

- 把神经网络最后的输出层删除

- 进入到最后一层并将其权重删除

- 为最后一层重新赋予随机权重

- 然后将神经网络放在放射诊断数据上训练

Tips

- 如果进行迁移学习的数据量比较小,只需要重新训练最后一两层权重.但是如果进行迁移学习的数据量较大,建议重新训练整个神经网络.

- 预训练(pre-training): 如果重新训练所有神经网络层,那么在图像识别数据的初期训练阶段,我们称这个过程为:预训练

- 微调(fine tuning): 在预训练后的模型上放入迁移学习的数据进行训练,这个过程称为:微调

why

- 迁移学习的好处在于,以放射科图像检测的迁移学习为例 在预训练的过程中,我们学到了一些图像识别中低层次特征,很多结构信息,图像形状的信息,点,线,面的特征.– 边缘检测(detecting edges),曲线检测(的tecting curves),阳性对象检测(detecting positive objects) 应用或迁移到放射科诊断上来.从非常大的图像识别数据库中习得的这些能力,会有助于你的学习算法在放射科诊断做的更好.

Another Example

- 假设你已经训练出一个语音识别系统(speech recognition system),现在x是音频(audio)或者音频片段输入(audio snippets),y是听写文本(transcript). 我们要使用这个系统”迁移学习”建立一个”唤醒词”的系统.

- 你可能需要去掉神经网络的最后一层,然后加入新的输出节点.但有时也可以不止加入一个新节点,或者甚至往你的神经网络加入几个新层.然后把唤醒词检测问题的标签”Y”喂进去训练.

- 这取决于你的训练数据的多少,你可能只需要重新训练网络的新层,也许你需要重新训练网络中更多的层.

when Transfer learning makes sence

- 迁移来源问题你有很多数据,但迁移目标问题你没有那么多数据.

- 例如:假如在图像识别任务中你有100W样本,数据量相当多,你可以学习低层次特征,可以在神经网络的前几层学到如何识别很多有用的特征.

- 但是对于”放射科任务”,也许你只有100个样本,所以你可以将图像识别预测的知识迁移到”放射科识别任务”中,即使你的放射科数据很少.

- 例如:在”语音识别”任务中,也许你已经有1W小时数据,训练过你的语言识别系统.所以你已经从这1W小时数据中学到了很多人类声音的特征.

- 但是对于”触发字检测”,也许你只有1小时数据,所以这数据太小,不能用来拟合很多参数.

- 所以这种情况下,你需要预先学到很多人类声音的特征,人类语言的组成部分等等知识,可以帮你建立一个很好的唤醒字检测器(wake word detector).即使你的数据集相对较小.

summary

- 如果你想从任务A迁移一些知识到任务B,当任务A和任务B都有相同的输入X时,迁移学习是有意义的.

- 例如在第一个例子中,输入X都是图片;在第二个例子中X都是声音音频.

- 当任务A的数据比数据B多得多时,迁移学习意义更大.

- 所有这些假设的前提都是,你希望提高任务B的性能.

- 因为任务B的每个数据更有价值,对于任务B来说.通常任务A的数据量必须大得多,才有帮助.

- 如果你觉得任务A的低层次特征,可以帮助任务B的学习,那迁移学习更有意义一些.

2.8 多任务学习 Multi-task learning

- 在迁移学习中,你的步骤是串行的,你从任务A里学到知识然后迁移到任务B中.在多任务学习中,你是同时开始学习的,试图让单个神经网络同时做几件事情,然后希望这里的每个任务都能帮到其他所有任务.

Simplified autonomous driving Example

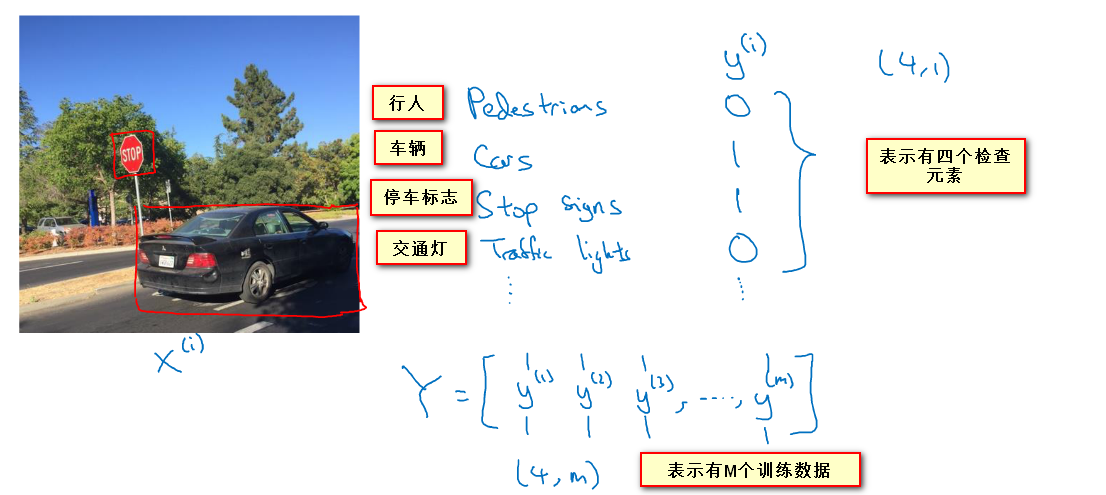

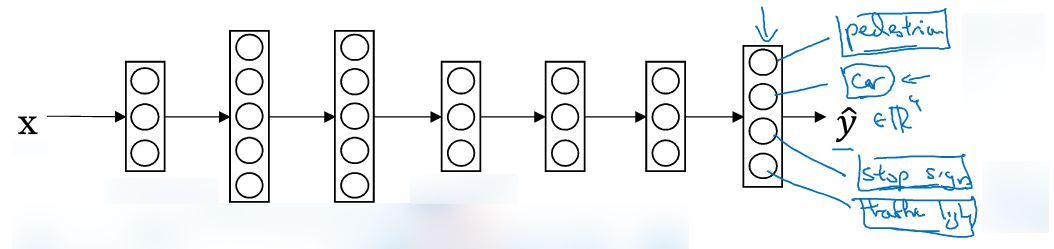

- 假设你正在研发无人驾驶车辆,那么你的无人驾驶车可能需要同时检测不同的物体.(行人,车辆,停车标志,交通灯…)

- 需要识别的物体假设即为上述讨论的四个,则最后一层设置4个神经元,一个4维向量,分别表示对”行人,车辆,停车标志,交通灯”的预测.

其中多任务学习 Loss function 也有相应的变化.对于多任务学习:

对于此处的loss函数l(交叉熵函数)的具体计算方式,详情请见:

交叉熵损失函数详解

神经网络基础

- 其中与之前例子最大的不同在于需要对检测的多任务目标进行分别比较并相加

∑4j=1 . - 这与softmax回归的主要区别在于,softmax回归将单个标签分配给单个样本,而这张图可以有很多不同的标签,所以不是说每张图都只是一张行人图片,汽车图片,停车标志图片,或者交通灯图片,多个物体可能同时出现在一张图里.

- 你需要遍历所有的物体类型,检测那类物体有没有出现在图中.

- 如果你训练了一个神经网络,需要最小化这个成本函数,你做的就是多任务学习

when multi-task learning makes sence

- 你训练的一组任务可以共用低层次特征.例如对于无人驾驶车的例子,识别的物体都是道路上的标志.

- 每个任务中学习的数据量很相近.

- 假如你要识别100个任务,每个任务大概有1000个样本,所以如果你专注加强单个任务的性能,你只有1000个样本去训练这个任务,这是100项任务之一,但是通过其他99项任务的训练, 这些加起来一共有99000个样本,这可能大幅提升算法性能,可以提供很多知识来增强这个任务的性能

- 如果你训练一个 足够大的神经网络,多任务神经网络和多个不同的单任务神经网络效果基本一致(即单独训练识别行人,单独识别交通标识牌…的神经网络).

- 一般来说, 迁移学习比多任务学习运用更多 ,但是在 计算机视觉-物体检测 中有大量应用到多任务学习,并且比分别训练不同的神经网络检测物体效果更好.

阅读全文

0 0

- [DeeplearningAI笔记]ML strategy_2_3迁移学习/多任务学习

- [DeeplearningAI笔记]ML strategy_2_3迁移学习/多任务学习

- [DeeplearningAI笔记]ML strategy_2_4端到端学习

- DeepLearningAI 学习笔记 1.1 深度学习概论

- DeepLearningAI 学习笔记 1.2 logistic 回归

- [DeeplearningAI笔记]ML strategy_2_1误差分析

- ML学习笔记_day1_introduction

- ML学习笔记-决策树

- [DeeplearningAI笔记]神经网络与深度学习2.1-2.4神经网络基础

- [DeeplearningAI笔记]神经网络与深度学习4.深度神经网络

- [DeeplearningAI笔记]神经网络与深度学习人工智能行业大师访谈

- DeepLearningAI 学习笔记 1.3 浅层 logistic 神经网络

- [DeeplearningAI笔记]ML strategy_1_1正交化/单一数字评估指标

- [DeeplearningAI笔记]ML strategy_1_2开发测试集评价指标

- opencv学习笔记--ml 【1】

- 不定期更新ML学习笔记

- ML学习笔记-朴素贝叶斯

- Spark ML PipeLine学习笔记

- Service的概念与使用

- bat脚本教程

- iPhone X的简单适配

- android对战的象棋小游戏,使用GridView做棋盘

- Git服务器搭建全过程分步详解

- [DeeplearningAI笔记]ML strategy_2_3迁移学习/多任务学习

- Linux top命令的用法详细详解

- 友盟集成第三方步骤(微信、QQ、微博)

- Activiti Modeler整合之后,部署之后流程图片显示乱码问题分析与解决

- Nginx多级代理,获取客户端真实请求IP以及每级代理IP

- spring与struts2的区别

- Learning URDF Step by Step

- PDO获取结果集

- 使用redis进行用户接口访问时间次数限制