Spectral Grouping Using The Nystrom Method

来源:互联网 发布:视频设置背景音乐软件 编辑:程序博客网 时间:2024/06/14 18:14

Spectral Grouping Using The Nystrom Method (2004 IEEE)

背景:谱聚类算法的大致步骤是,求数据集之间的相似度矩阵,并构造出相似度图,然后求得某种形式上的 Laplacian Matrix(L, Lrw或者Lsym),然后求laplacian matrix的前K个特征向量,随后以k个特征向量组成的矩阵U的前K个行向量作为输入,运行k-means算法,得到最后的聚类结果。这要求对整个数据集进行处理,在很多应用中是不符合实际的。把Nystrom Method应用到聚类算法上,求解得到通过样本集的相似度矩阵得到的Laplacian Matrix的特征向量,通过局部数据的特征向量推导出整个数据集的特征向量的近似值,可应用于当数据规模巨大时运行谱聚类算法的场景。

Nystrom Method

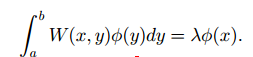

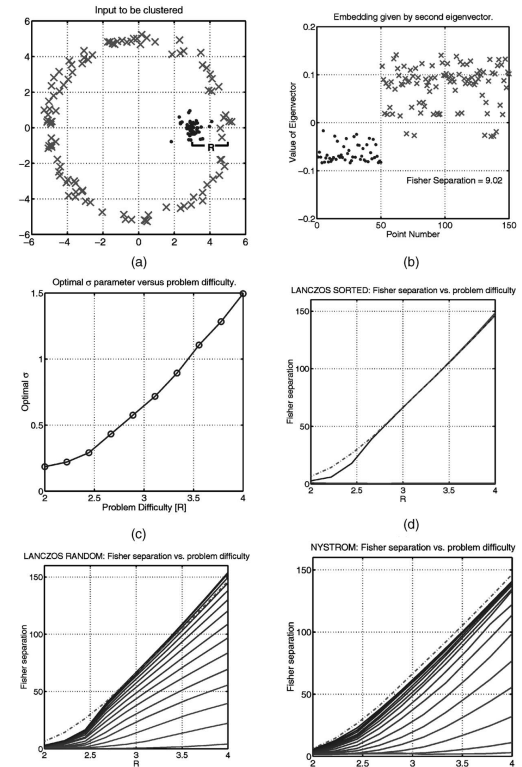

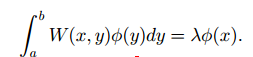

Nystrom Method用于求解如下形式的积分方程:

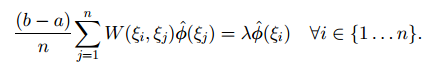

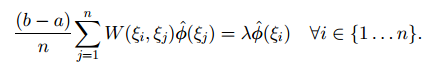

在[a,b]中间取n个均分点,并运用矩形公式将积分写成数值计算的形式:

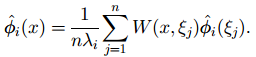

特殊地,令[a,b]为[0,1],于是上面的式子可以表示成矩阵形式: 。于是得到Nystrom Extension公式:

。于是得到Nystrom Extension公式:

(1)

(1)

利用这个公式,可以实现背景中所述的目的。

运用于矩阵的估计和矩阵特征值的估计

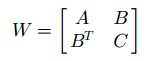

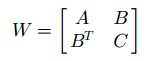

A为样本点集合的相似度矩阵,C为非样本点集合的相似度矩阵,B是所有样本点和非样本点之间的相似度构成的矩阵。下面将使用上式,用A,B表示出C的估计值。,从而得到整个相似度矩阵。

这是原始矩阵,包含了整个数据集中任何两个点之间的相似度。

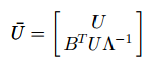

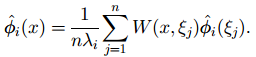

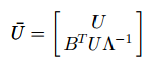

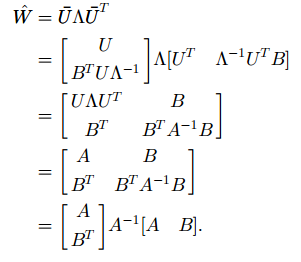

Nystrom Extension的矩阵形式为 (可推导),其中U是样本集的特征向量构成的矩阵(见Tutorials中U的定义),通过(1),得到W的特征向量的估计和W本身的估计:

(可推导),其中U是样本集的特征向量构成的矩阵(见Tutorials中U的定义),通过(1),得到W的特征向量的估计和W本身的估计:

Nystrom extension可用BTA-1B对C进行估计,于是,可以用||C-BTA-1B||作为以上近似运算准确性的衡量。

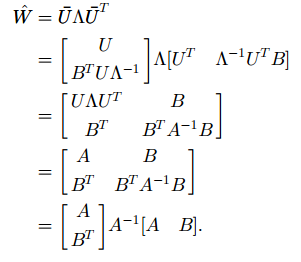

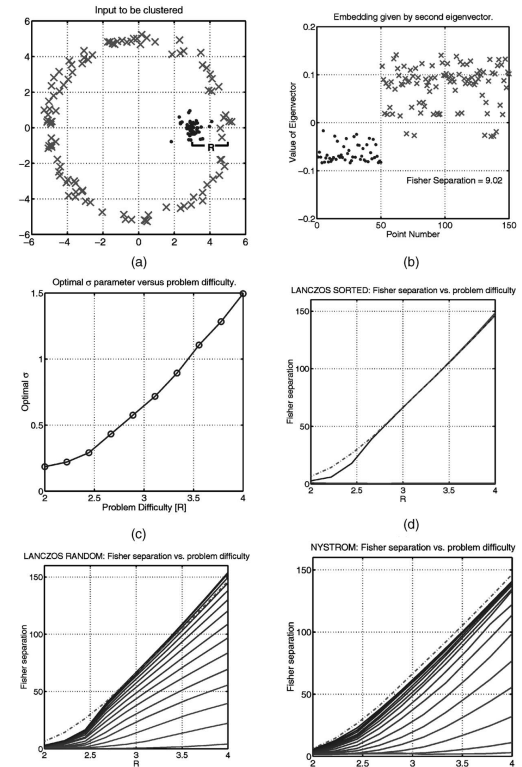

应用于NCut和基于Lrw的Normalized Clustering

论文的第三部分还分别讨论A是正定矩阵和非正定矩阵这两种情况下构造W的近似表示的方法。应用于基于NCut的聚类时,可以通过W的近似结果将D-1/2WD-1/2的近似结果表示出来,从而在求解Lsym的这一步骤,避免了处理整个数据集的问题,提升了整个算法的性能。最后,根据Fisher criterion的度量方法,结合大量实验,对算法做了性能和误差的分析。论文比较了在稀疏表示下,Nystrom Approximation方法和dense solution的估计结果。对于有许多0或者近似为0的元素时,前者的估计非常准确且很好地保留了特征状态。但是这种方法依然需要O(N2)的时间复杂度来计算亲和度(除了需要计算A,还需要计算B),原文中的Fig.3列出了在实验中对于同一个图像,对于不同的样本集规模应用近似算法求得特征向量近似结果的评估值(基于Fisher criterion)。

图中,a)是150个输入点,b)是150个Normalized Laplacian矩阵的特征向量,其中1-50是聚成堆状的50个点对应的特征向量。c)显示了采用高斯加权的欧氏距离计算相似度时,参数的不同取值对应两个cluster之间的距离。d)e)f)比较了两种算法的性能度量。

我的想法:

1,如果在聚类时使用k近邻图(k-nearest neiborhood graph)作为相似度图,用高斯加权的欧氏距离公式Sij=exp(-||xi-xj||2/(2d2)),那么是否有方法能够优化参数d和k,使得聚类结果最优?

Tutorial of the Spectral Clustering 中的 8.1.3 讲到,求解最优的k,目前极少的文献可以指导我们完成这一工作。然而我们知道,参数k的选用应该至少使得图中的连通分量比目标聚类数少。

虽然不能确定相似度图的connectivity parameters,但是现有的许多方法能够选择最佳的目标聚类数k。例如,求矩阵的前k个较小的特征值后,如果第k+1个特征值较大,则目标聚类数选为k。

2,是否能够在实验中或理论中找到一个方法,比较和度量Tutorial中提到的三种谱聚类算法的聚类结果?

从图的分割的角度,聚类的优化目标有二,1,类间相似度和最小;2,类内相似度和最大。因此可以通过比较类间相似度和以及类内相似度和这两个量,定量地衡量聚类算法的性能。

同时达到两个目的的,是NCut和MinmaxCut(其中根据分析,前者优于后者),而来源于RatioCut的unnormalized clustering算法只达到了第一条目的。这个角度上说,采用Lrw作为拉普拉斯矩阵的归一化谱聚类算法是最优的。

以上结果有待在具体实验中展现。

精读:

[1] 2007 Springer. Ulrike von Luxburg, A Tutorial on Spectral Clustering.

介绍了laplacian graph,similarity graph等谱聚类基础知识,以及利用三种laplacian graph进行聚类的谱聚类算法极其来由。最后介绍了诸如拉普拉斯矩阵的选择,聚类参数的选择,特征向量的求解等子问题的求解方法和进展。

[2] 2004 IEEE. Charless Fowlkes, Serge Belongie, Fan Chung, and Jitendra Malik, Spectral Grouping Using the Nystrom Method.

介绍了将用于求解积分方程的Nystrom method通过变换,用于聚类算法的方法,这么做的好处,是通过对数据集中的抽样数据集进行Nystrom approximation,通过样本集的相似度矩阵估算出整个数据集的相似度矩阵,通过样本集的拉普拉斯矩阵的特征向量估算出整个数据集的拉普拉斯矩阵的特征向量,从而大大降低了处理大数据谱聚类问题的计算开销。

[3] 2008 ICML. Kai Zhang, Ivor W.Tsang, James T.Kwok, Improved Nystrom Low-Rank Approximation and Error Analysis.

小秩矩阵估计有许多方法,贪心算法,Nystrom Method和随机化算法。而其中Nystrom的性能和效率较高。该文首先对Nystrom approximation进行误差分析,并据此提出用KM算法求解landmark points从而得到样本集,并验证了这种方法由从算法的时间复杂度和为Nystrom low-rank approximation抽样时所带来的误差大小上,效果都优于前面三种抽样方法。

[4] 2009 KDD - Fast Approximating Spectral Clustering

说明了Nystrom low-rannk approximation的缺陷

1,抽样时,并不关系相似度矩阵包含的信息(描述太抽象,不理解)。

2,空间复杂度大(不仅使用了样本集,未被采样的数据点集合也参与了计算,参考精读[2],C是由A和B同时参与计算得到的)

3,如果原数据集是不平衡(unbalanced,这个概念在 2007 IEEE A Tutorial on the spectral clustering 中提到,和指示向量是否相互正交化有关)的,可以用于计算的样本集将会很小,这将很大程度影响最后计算结果的准确度。(精读[3]中提到,用k_means方法采样使得Nystrom low-rank approximation的误差达到接近最小化的程度,但确实也回避了原数据集不平衡的问题)

随后提出了自己的框架FASP,并在此框架下设计了采用K-Means的KASP和采用随机游走的RASP,通过实验说明了框架的优势:在聚类效果上牺牲了极小的代价,换来了计算的时间复杂度和空间复杂度很大的节约。随后通过微扰理论为框架提供了一定的理论支持。(个人认为该文章是先作出FASP优于其他算法的猜想,再用实验验证,最后理论上分析算法的误差和性能。)

[5] 2011 AISTATS Dimension Reduction for Spectral Clustering

其一,髙维度的数据点构建NN(近邻)图时会失效,原因是维度太高时,两点之间的距离将趋于常数;其二,谱聚类具有很大的灵活性,可用于许多数据类型的处理,但其致命弱点是对不重要的数据和噪点非常敏感。DRSC的目的是将原本高维数据降到线性空间,以便于作为谱聚类算法的输入;并因为降维时为了求降维子空间,用到的优化目标函数和Lsym谱聚类算法的优化目标函数相同,作者尽可能地将它与谱聚类算法结合起来。

DRSC是一个迭代算法次。对于一个数据集X,通过迭代最终求得它在central subspace上的正交投影。

引用次数仅1次的这篇论文,引用了许多论文,用到很多其他的理论,要弄懂这篇文章,需要阅读甚至精读很多参考文献,任务繁重。在阅读完它的重要参考文献(包括SDR等)之前,还没明白算法的由来。

[6] 2008 [NIPS] Spectral clustering with perturbed data

这篇目前引用量是43的文章,可以说是FASP框架灵感的来源。这篇文章沿着谱聚类(确切说,是bipartition)的算法流程,从数据集X上的扰动开始到相似度矩阵K的扰动、拉普拉斯矩阵Lrw的扰动,最终分析得到此扰动对谱聚类结果的影响(mis-clustering rate)的上界。

作者在分析中发现,聚类效果很大程度受到数据的均方差的影响,因而认为减小均方差可以提高聚类的准确性。实际上FASP确实是在实施聚类之前对数据进行预处理,达到上述目的。【鸣谢FIATLUX】

[7] 2006 [ICDM] Fast and extract out-of-core K-means clustering

K-Means虽然被称为是一种简单快速的方法,但是每次更新质心时,所有的数据点都需要参与计算,实际运行效果有待改善,而改善的空间在于,导致质心的位移的数据点只有簇的边界点。前人很多工作为了加快KM,都付出了准确度上的代价,FEKM的优势在于,提高了算法效率的同时还能精确地计算出一组质心,它和直接对大数据实施KM得到的一组质心是相同的。FEKM还有对抽样规模不敏感等优点。但是仍未解决KM原生的诸如对离群点和噪点敏感等许多问题。

作者用归纳方法对算法的正确性给出了证明。

[8] 1999 [ICDT] When is nearest neighbor meaningful[cited 1301]

引用次数上千,是研究NN和降维的重要文献。其中讨论了髙维度空间上NN失效的问题,用Slutsky定理给出了证明了满足一定条件时,维度的增大将导致数据集中各点的距离趋于相等。并通过实验找到了一个维度上限的经验值15,并且对满足不同概率分布的数据集进行了大致分析,分析此数据是否存在高维NN失效的问题。

[9] 2003 [Citeseer] A Comparison of Spectral Clustering Algorithms

这篇对比分析性的文章比较了当时最提出的四种主要的谱聚类算法(该文章作者也是提出了其中两种算法的大牛)。分为两类:迭代的和非迭代的。理论上证明了将Lsym和Lrw两个矩阵作为L的两种算法(NJW和Meila-Shi算法)是等价的。并用实验结果分析比较了四种算法,不过,作者并没有达到文章开始提到的“ find out which of the sub-components are important and which not,and to see if some combinations of these works the best.”的目的,目前的谱聚类算法的主体,仍然没超越大牛当年的思想。

[10]2013 A Comparative of Initialization Methods of K-Means

从1965年的文献开始,罗列了许多IMs of KM。依次介绍了各个方法及其优缺点,并从复杂度角度比较了两种复杂度的算法及其应用。作为一篇导论性或综述性的文章具有一定可读性。

泛读:

[1] 1997 Graph Theory, Combinatorics and Application. Bojan Mohar, THE LAPLACIAN SPECTRUM OF GRAPHS.(被精读[1]所引用)

系统地介绍了拉普拉斯图极其性质。

[2] 2002 [Springer Annals of the Institute of Statistical] SDR and Graphics in Regression

主要阅读了SDR部分,介绍Sufficient Dimension Reduction,一种监督降维方法。引用次数为32,许多论文在此基础上提出了其他的降维方法和应用。

学习了谱聚类的算法,以及unnormalized spectral clustering和采用Lrw的谱聚类算法这两种聚类算法的来由后,继续学习了采用Lsym的谱聚类算法的原理。在 Setc.5.4 中有所阐述,原理和推导和前面类似。

Sect.6介绍了随机游走,Sect.7介绍的微扰理论是一种重要的近似方法,分别就两个不同角度解释了why spectral clustering works这个问题。Sect 8从实现的细节这个角度,继续阐述谱聚类算法的一些重要细节。本篇笔记将在今后继续完善下去。

用于求解积分方程的 Nystrom Method 可用于用小样本估测整个数据集的相似度矩阵的特征向量,在谱聚类算法尤其是基于NCut的谱聚类算法中有重要应用,故本周主要阅读了2004 IEEE的Spectral Grouping Using the Nystrom Method。

Sect 8.1 相似度图

首先看相似度函数。

1,被相似度函数“认为”相似度大的点,实际情况应该是确实更接近。反之亦然。

2,全局的、绝对的相似度并不重要,两点之间的相似度是0.1或者0.01并不重要,因为0.01和0.1都是很小的相似度,除非用全连通图(就算是全连通图,那些很小的相似度也不影响聚类结果,并不因为两点之间有一条权值很小的边,就将两点聚为一起),在图中,这两个点不会被一条边连接。

3,相似度函数的选用和数据定义域和数据的分布有关系。一般情况下选用高斯化欧氏距离函数是合适的。

相似度图:

1,e-图难以确定合适的e,因为一个数据集中可能存在不同的数据分布。

2,Mutual KNN相对于KNN的优点:可以避免将密度不同的两“堆”点连接起来。缺点,可能造成相似度图中边太少的问题。

3,全连通图也是一种选择,不过它将导致得到的拉普拉斯矩阵不是稀疏矩阵,在求特征向量时,将增大计算开销并影响准确度。

4,一般情况下,推荐使用KNN。

Sect 8.2 计算特征值

1,如果是KNN或者e-图,L将是稀疏的,此时有许多方法求解L的特征向量:the power method、Krylov Subspace method、Lanczos method等等。

2,典型算法的收敛速度为rk=|eigval(k)-eigval(k+1)|。

2,如果特征值有重根,比如当有k个不相连的类(相似度图有k个连通分支)则有k个为0的特征值。

Sect 8.3 最佳的k(类的个数)

eigengap heuristic 方法:如果前k个特征值较小,而第k+1个特征值较大,则聚类的类个数选为k。(如此说来,这种方法可配合计算特征值和特征向量使用。)

这种方法在各个cluster分开得很明显的情况下,否则如果受到过多噪声的影响,或者类之间的相互覆盖很严重,则这种方法有效性欠佳。

Sect 8.5 Laplacian 图的选择。

选择通过哪一个拉普拉斯矩阵的特征向量来聚类,是一个重要的问题。用L,Lrw和Lsym都可以达到聚类的目的。经过实验,三者的效果是有差别的。一般而言,归一化的谱聚类算法优于未归一化的谱聚类算法,而前者中,采用Lrw的算法优于采用Lsym的算法。

首先回顾聚类的目的。在Sect 5中一直将聚类看成一种最优化问题,具体而言需要优化的目的是要找到一个图的划分,使得:1,类间相似度最小,即cut(A,B)最小;2,类内相似度最大,即W(A,A)和W(A,B)最大。

假使k=2,A和B是V的两个割。W(A,A)=W(A,V)-W(A,B)=vol(A) - W(A,B)。所以为达到上面的优化目的,vol(A)必须最大化,cut(A,B)最小化。

而显然。NCut所解决的真是这个问题。故而,Lrw作为拉普阿斯矩阵是最合理的。NCut中含有vol(A)的优化问题,而,vol(A)=cut(A,B)+W(A,A) ,可是MinmaxCut只涉及到W(A,A)的优化,所以我们有理由相信,在谱聚类中,Lrw优于Lsym。

再看RatioCut,其优化目的是使得:1,cut(A,B)最小;2,|A|最大。但是类内相似度和集合中点的个数无关,而与集合中的点之间相似度有关。故而RatioCut对应的unnormalized spectral clustering算法不能很好地达到聚类目的。

本文引用了以下文章

http://blog.sciencenet.cn/blog-799581-626691.html

http://blog.sciencenet.cn/blog-799581-628674.html

http://blog.sciencenet.cn/blog-799581-626676.html

http://blog.sciencenet.cn/blog-799581-631128.html

背景:谱聚类算法的大致步骤是,求数据集之间的相似度矩阵,并构造出相似度图,然后求得某种形式上的 Laplacian Matrix(L, Lrw或者Lsym),然后求laplacian matrix的前K个特征向量,随后以k个特征向量组成的矩阵U的前K个行向量作为输入,运行k-means算法,得到最后的聚类结果。这要求对整个数据集进行处理,在很多应用中是不符合实际的。把Nystrom Method应用到聚类算法上,求解得到通过样本集的相似度矩阵得到的Laplacian Matrix的特征向量,通过局部数据的特征向量推导出整个数据集的特征向量的近似值,可应用于当数据规模巨大时运行谱聚类算法的场景。

Nystrom Method

Nystrom Method用于求解如下形式的积分方程:

在[a,b]中间取n个均分点,并运用矩形公式将积分写成数值计算的形式:

特殊地,令[a,b]为[0,1],于是上面的式子可以表示成矩阵形式:

。于是得到Nystrom Extension公式:

。于是得到Nystrom Extension公式: (1)

(1)利用这个公式,可以实现背景中所述的目的。

运用于矩阵的估计和矩阵特征值的估计

A为样本点集合的相似度矩阵,C为非样本点集合的相似度矩阵,B是所有样本点和非样本点之间的相似度构成的矩阵。下面将使用上式,用A,B表示出C的估计值。,从而得到整个相似度矩阵。

这是原始矩阵,包含了整个数据集中任何两个点之间的相似度。

Nystrom Extension的矩阵形式为

(可推导),其中U是样本集的特征向量构成的矩阵(见Tutorials中U的定义),通过(1),得到W的特征向量的估计和W本身的估计:

(可推导),其中U是样本集的特征向量构成的矩阵(见Tutorials中U的定义),通过(1),得到W的特征向量的估计和W本身的估计:

Nystrom extension可用BTA-1B对C进行估计,于是,可以用||C-BTA-1B||作为以上近似运算准确性的衡量。

应用于NCut和基于Lrw的Normalized Clustering

论文的第三部分还分别讨论A是正定矩阵和非正定矩阵这两种情况下构造W的近似表示的方法。应用于基于NCut的聚类时,可以通过W的近似结果将D-1/2WD-1/2的近似结果表示出来,从而在求解Lsym的这一步骤,避免了处理整个数据集的问题,提升了整个算法的性能。最后,根据Fisher criterion的度量方法,结合大量实验,对算法做了性能和误差的分析。论文比较了在稀疏表示下,Nystrom Approximation方法和dense solution的估计结果。对于有许多0或者近似为0的元素时,前者的估计非常准确且很好地保留了特征状态。但是这种方法依然需要O(N2)的时间复杂度来计算亲和度(除了需要计算A,还需要计算B),原文中的Fig.3列出了在实验中对于同一个图像,对于不同的样本集规模应用近似算法求得特征向量近似结果的评估值(基于Fisher criterion)。

图中,a)是150个输入点,b)是150个Normalized Laplacian矩阵的特征向量,其中1-50是聚成堆状的50个点对应的特征向量。c)显示了采用高斯加权的欧氏距离计算相似度时,参数的不同取值对应两个cluster之间的距离。d)e)f)比较了两种算法的性能度量。

我的想法:

1,如果在聚类时使用k近邻图(k-nearest neiborhood graph)作为相似度图,用高斯加权的欧氏距离公式Sij=exp(-||xi-xj||2/(2d2)),那么是否有方法能够优化参数d和k,使得聚类结果最优?

Tutorial of the Spectral Clustering 中的 8.1.3 讲到,求解最优的k,目前极少的文献可以指导我们完成这一工作。然而我们知道,参数k的选用应该至少使得图中的连通分量比目标聚类数少。

虽然不能确定相似度图的connectivity parameters,但是现有的许多方法能够选择最佳的目标聚类数k。例如,求矩阵的前k个较小的特征值后,如果第k+1个特征值较大,则目标聚类数选为k。

2,是否能够在实验中或理论中找到一个方法,比较和度量Tutorial中提到的三种谱聚类算法的聚类结果?

从图的分割的角度,聚类的优化目标有二,1,类间相似度和最小;2,类内相似度和最大。因此可以通过比较类间相似度和以及类内相似度和这两个量,定量地衡量聚类算法的性能。

同时达到两个目的的,是NCut和MinmaxCut(其中根据分析,前者优于后者),而来源于RatioCut的unnormalized clustering算法只达到了第一条目的。这个角度上说,采用Lrw作为拉普拉斯矩阵的归一化谱聚类算法是最优的。

以上结果有待在具体实验中展现。

精读:

[1] 2007 Springer. Ulrike von Luxburg, A Tutorial on Spectral Clustering.

介绍了laplacian graph,similarity graph等谱聚类基础知识,以及利用三种laplacian graph进行聚类的谱聚类算法极其来由。最后介绍了诸如拉普拉斯矩阵的选择,聚类参数的选择,特征向量的求解等子问题的求解方法和进展。

[2] 2004 IEEE. Charless Fowlkes, Serge Belongie, Fan Chung, and Jitendra Malik, Spectral Grouping Using the Nystrom Method.

介绍了将用于求解积分方程的Nystrom method通过变换,用于聚类算法的方法,这么做的好处,是通过对数据集中的抽样数据集进行Nystrom approximation,通过样本集的相似度矩阵估算出整个数据集的相似度矩阵,通过样本集的拉普拉斯矩阵的特征向量估算出整个数据集的拉普拉斯矩阵的特征向量,从而大大降低了处理大数据谱聚类问题的计算开销。

[3] 2008 ICML. Kai Zhang, Ivor W.Tsang, James T.Kwok, Improved Nystrom Low-Rank Approximation and Error Analysis.

小秩矩阵估计有许多方法,贪心算法,Nystrom Method和随机化算法。而其中Nystrom的性能和效率较高。该文首先对Nystrom approximation进行误差分析,并据此提出用KM算法求解landmark points从而得到样本集,并验证了这种方法由从算法的时间复杂度和为Nystrom low-rank approximation抽样时所带来的误差大小上,效果都优于前面三种抽样方法。

[4] 2009 KDD - Fast Approximating Spectral Clustering

说明了Nystrom low-rannk approximation的缺陷

1,抽样时,并不关系相似度矩阵包含的信息(描述太抽象,不理解)。

2,空间复杂度大(不仅使用了样本集,未被采样的数据点集合也参与了计算,参考精读[2],C是由A和B同时参与计算得到的)

3,如果原数据集是不平衡(unbalanced,这个概念在 2007 IEEE A Tutorial on the spectral clustering 中提到,和指示向量是否相互正交化有关)的,可以用于计算的样本集将会很小,这将很大程度影响最后计算结果的准确度。(精读[3]中提到,用k_means方法采样使得Nystrom low-rank approximation的误差达到接近最小化的程度,但确实也回避了原数据集不平衡的问题)

随后提出了自己的框架FASP,并在此框架下设计了采用K-Means的KASP和采用随机游走的RASP,通过实验说明了框架的优势:在聚类效果上牺牲了极小的代价,换来了计算的时间复杂度和空间复杂度很大的节约。随后通过微扰理论为框架提供了一定的理论支持。(个人认为该文章是先作出FASP优于其他算法的猜想,再用实验验证,最后理论上分析算法的误差和性能。)

[5] 2011 AISTATS Dimension Reduction for Spectral Clustering

其一,髙维度的数据点构建NN(近邻)图时会失效,原因是维度太高时,两点之间的距离将趋于常数;其二,谱聚类具有很大的灵活性,可用于许多数据类型的处理,但其致命弱点是对不重要的数据和噪点非常敏感。DRSC的目的是将原本高维数据降到线性空间,以便于作为谱聚类算法的输入;并因为降维时为了求降维子空间,用到的优化目标函数和Lsym谱聚类算法的优化目标函数相同,作者尽可能地将它与谱聚类算法结合起来。

DRSC是一个迭代算法次。对于一个数据集X,通过迭代最终求得它在central subspace上的正交投影。

引用次数仅1次的这篇论文,引用了许多论文,用到很多其他的理论,要弄懂这篇文章,需要阅读甚至精读很多参考文献,任务繁重。在阅读完它的重要参考文献(包括SDR等)之前,还没明白算法的由来。

[6] 2008 [NIPS] Spectral clustering with perturbed data

这篇目前引用量是43的文章,可以说是FASP框架灵感的来源。这篇文章沿着谱聚类(确切说,是bipartition)的算法流程,从数据集X上的扰动开始到相似度矩阵K的扰动、拉普拉斯矩阵Lrw的扰动,最终分析得到此扰动对谱聚类结果的影响(mis-clustering rate)的上界。

作者在分析中发现,聚类效果很大程度受到数据的均方差的影响,因而认为减小均方差可以提高聚类的准确性。实际上FASP确实是在实施聚类之前对数据进行预处理,达到上述目的。【鸣谢FIATLUX】

[7] 2006 [ICDM] Fast and extract out-of-core K-means clustering

K-Means虽然被称为是一种简单快速的方法,但是每次更新质心时,所有的数据点都需要参与计算,实际运行效果有待改善,而改善的空间在于,导致质心的位移的数据点只有簇的边界点。前人很多工作为了加快KM,都付出了准确度上的代价,FEKM的优势在于,提高了算法效率的同时还能精确地计算出一组质心,它和直接对大数据实施KM得到的一组质心是相同的。FEKM还有对抽样规模不敏感等优点。但是仍未解决KM原生的诸如对离群点和噪点敏感等许多问题。

作者用归纳方法对算法的正确性给出了证明。

[8] 1999 [ICDT] When is nearest neighbor meaningful[cited 1301]

引用次数上千,是研究NN和降维的重要文献。其中讨论了髙维度空间上NN失效的问题,用Slutsky定理给出了证明了满足一定条件时,维度的增大将导致数据集中各点的距离趋于相等。并通过实验找到了一个维度上限的经验值15,并且对满足不同概率分布的数据集进行了大致分析,分析此数据是否存在高维NN失效的问题。

[9] 2003 [Citeseer] A Comparison of Spectral Clustering Algorithms

这篇对比分析性的文章比较了当时最提出的四种主要的谱聚类算法(该文章作者也是提出了其中两种算法的大牛)。分为两类:迭代的和非迭代的。理论上证明了将Lsym和Lrw两个矩阵作为L的两种算法(NJW和Meila-Shi算法)是等价的。并用实验结果分析比较了四种算法,不过,作者并没有达到文章开始提到的“ find out which of the sub-components are important and which not,and to see if some combinations of these works the best.”的目的,目前的谱聚类算法的主体,仍然没超越大牛当年的思想。

[10]2013 A Comparative of Initialization Methods of K-Means

从1965年的文献开始,罗列了许多IMs of KM。依次介绍了各个方法及其优缺点,并从复杂度角度比较了两种复杂度的算法及其应用。作为一篇导论性或综述性的文章具有一定可读性。

泛读:

[1] 1997 Graph Theory, Combinatorics and Application. Bojan Mohar, THE LAPLACIAN SPECTRUM OF GRAPHS.(被精读[1]所引用)

系统地介绍了拉普拉斯图极其性质。

[2] 2002 [Springer Annals of the Institute of Statistical] SDR and Graphics in Regression

主要阅读了SDR部分,介绍Sufficient Dimension Reduction,一种监督降维方法。引用次数为32,许多论文在此基础上提出了其他的降维方法和应用。

学习了谱聚类的算法,以及unnormalized spectral clustering和采用Lrw的谱聚类算法这两种聚类算法的来由后,继续学习了采用Lsym的谱聚类算法的原理。在 Setc.5.4 中有所阐述,原理和推导和前面类似。

Sect.6介绍了随机游走,Sect.7介绍的微扰理论是一种重要的近似方法,分别就两个不同角度解释了why spectral clustering works这个问题。Sect 8从实现的细节这个角度,继续阐述谱聚类算法的一些重要细节。本篇笔记将在今后继续完善下去。

用于求解积分方程的 Nystrom Method 可用于用小样本估测整个数据集的相似度矩阵的特征向量,在谱聚类算法尤其是基于NCut的谱聚类算法中有重要应用,故本周主要阅读了2004 IEEE的Spectral Grouping Using the Nystrom Method。

Sect 8.1 相似度图

首先看相似度函数。

1,被相似度函数“认为”相似度大的点,实际情况应该是确实更接近。反之亦然。

2,全局的、绝对的相似度并不重要,两点之间的相似度是0.1或者0.01并不重要,因为0.01和0.1都是很小的相似度,除非用全连通图(就算是全连通图,那些很小的相似度也不影响聚类结果,并不因为两点之间有一条权值很小的边,就将两点聚为一起),在图中,这两个点不会被一条边连接。

3,相似度函数的选用和数据定义域和数据的分布有关系。一般情况下选用高斯化欧氏距离函数是合适的。

相似度图:

1,e-图难以确定合适的e,因为一个数据集中可能存在不同的数据分布。

2,Mutual KNN相对于KNN的优点:可以避免将密度不同的两“堆”点连接起来。缺点,可能造成相似度图中边太少的问题。

3,全连通图也是一种选择,不过它将导致得到的拉普拉斯矩阵不是稀疏矩阵,在求特征向量时,将增大计算开销并影响准确度。

4,一般情况下,推荐使用KNN。

Sect 8.2 计算特征值

1,如果是KNN或者e-图,L将是稀疏的,此时有许多方法求解L的特征向量:the power method、Krylov Subspace method、Lanczos method等等。

2,典型算法的收敛速度为rk=|eigval(k)-eigval(k+1)|。

2,如果特征值有重根,比如当有k个不相连的类(相似度图有k个连通分支)则有k个为0的特征值。

Sect 8.3 最佳的k(类的个数)

eigengap heuristic 方法:如果前k个特征值较小,而第k+1个特征值较大,则聚类的类个数选为k。(如此说来,这种方法可配合计算特征值和特征向量使用。)

这种方法在各个cluster分开得很明显的情况下,否则如果受到过多噪声的影响,或者类之间的相互覆盖很严重,则这种方法有效性欠佳。

Sect 8.5 Laplacian 图的选择。

选择通过哪一个拉普拉斯矩阵的特征向量来聚类,是一个重要的问题。用L,Lrw和Lsym都可以达到聚类的目的。经过实验,三者的效果是有差别的。一般而言,归一化的谱聚类算法优于未归一化的谱聚类算法,而前者中,采用Lrw的算法优于采用Lsym的算法。

首先回顾聚类的目的。在Sect 5中一直将聚类看成一种最优化问题,具体而言需要优化的目的是要找到一个图的划分,使得:1,类间相似度最小,即cut(A,B)最小;2,类内相似度最大,即W(A,A)和W(A,B)最大。

假使k=2,A和B是V的两个割。W(A,A)=W(A,V)-W(A,B)=vol(A) - W(A,B)。所以为达到上面的优化目的,vol(A)必须最大化,cut(A,B)最小化。

而显然。NCut所解决的真是这个问题。故而,Lrw作为拉普阿斯矩阵是最合理的。NCut中含有vol(A)的优化问题,而,vol(A)=cut(A,B)+W(A,A) ,可是MinmaxCut只涉及到W(A,A)的优化,所以我们有理由相信,在谱聚类中,Lrw优于Lsym。

再看RatioCut,其优化目的是使得:1,cut(A,B)最小;2,|A|最大。但是类内相似度和集合中点的个数无关,而与集合中的点之间相似度有关。故而RatioCut对应的unnormalized spectral clustering算法不能很好地达到聚类目的。

本文引用了以下文章

http://blog.sciencenet.cn/blog-799581-626691.html

http://blog.sciencenet.cn/blog-799581-628674.html

http://blog.sciencenet.cn/blog-799581-626676.html

0 0

- Spectral Grouping Using The Nystrom Method

- Using the callLater() method

- Using the window.open method

- Using the window.open method

- Name Disambiguation in Author Citations using a Kway Spectral Clustering Method 论文之摘要

- 对 A label propagation method using spatial-spectral consistency *** 的理解

- The method using the Chinese input method in Fedora 16

- Generalizing RDP Codes Using the Combinatorial Method

- fit the “model” to the training data using that method

- 合并两链表:LinkList:Merge Two LinkList using the general method

- using the easy connect naming method 简单连接测试

- This is class com.phonecontact.UpdateContactServlet, using the POST method

- bitcount using bit method

- GROUPING

- grouping

- Grouping

- Grouping

- GROUPING

- 2.x终于照着教程,成功使用OpenGL ES 绘制纹理贴图,增加了灰度图

- Video Object Segmentation through Spatially Accurate and Temporally Dense Extraction of Primary Object Regions

- 重要知识结构-持续更新中

- Visual Studio 2010 + CLAPACK

- VS2010编译安装OpenCV2.4.3

- Spectral Grouping Using The Nystrom Method

- nmake

- 朱镕基的六段话

- How To Read A Research Paper?---by Mubarak Shah

- MEX的几种文件后缀名

- Key-Segments for Video Object Segmentation-ICCV 2011

- 李嘉诚不败之谜

- 你要学习

- 一些精辟的话