V4L2应用程序框架

来源:互联网 发布:方舟生存进化优化mod 编辑:程序博客网 时间:2024/06/08 10:48

V4L2是V4L的升级版本,linux下视频设备程序提供了一套接口规范。

Video for Linux two(Video4Linux2)简称V4L2,是V4L的改进版。V4L2是linux操作系统下用于采集图片、视频和音频数据的API接口,配合适当的视频采集设备和相应的驱动程序,可以实现图片、视频、音频等的采集。在远程会议、可视电话、视频监控系统和嵌入式多媒体终端中都有广泛的应用。

一、Video for Linux two

在Linux下,所有外设都被看成一种特殊的文件,成为“设备文件”,可以象访问普通文件一样对其进行读写。一般来说,采用V4L2驱动的摄像头设备文件是/dev/v4l/video0。为了通用,可以建立一个到/dev/video0的链接。V4L2支持两种方式来采集图像:内存映射方式(mmap)和直接读取方式(read)。V4L2在include/linux/videodev.h文件中定义了一些重要的数据结构,在采集图像的过程中,就是通过对这些数据的操作来获得最终的图像数据。Linux系统V4L2的能力可在Linux内核编译阶段配置,默认情况下都有此开发接口。V4L2从Linux 2.5.x版本的内核中开始出现。

V4L2规范中不仅定义了通用API元素(Common API Elements),图像的格式(Image Formats),输入/输出方法(Input/Output),还定义了Linux内核驱动处理视频信息的一系列接口(Interfaces),这些接口主要有:

视频采集接口——Video Capture Interface;

视频输出接口—— Video Output Interface;

视频覆盖/预览接口——Video Overlay Interface;

视频输出覆盖接口——Video Output Overlay Interface;

编解码接口——Codec Interface。

二、应用程序通过V4L2进行视频采集的原理

V4L2支持内存映射方式(mmap)和直接读取方式(read)来采集数据,前者一般用于连续视频数据的采集,后者常用于静态图片数据的采集,本文重点讨论内存映射方式的视频采集。

应用程序通过V4L2接口采集视频数据分为五个步骤:

首先,打开视频设备文件,进行视频采集的参数初始化,通过V4L2接口设置视频图像的采集窗口、采集的点阵大小和格式;

其次,申请若干视频采集的帧缓冲区,并将这些帧缓冲区从内核空间映射到用户空间,便于应用程序读取/处理视频数据;

第三,将申请到的帧缓冲区在视频采集输入队列排队,并启动视频采集;

第四,驱动开始视频数据的采集,应用程序从视频采集输出队列取出帧缓冲区,处理完后,将帧缓冲区重新放入视频采集输入队列,循环往复采集连续的视频数据;

第五,停止视频采集。

1.视频采集的参数初始化

在Linux下,摄像头硬件已经被映射为设备文件“/dev/video0”,用open函数打开这个设备文件,获得其文件描述符fd_v4l2,然后对这个文件描述符进行参数初始化。

(1) 设置视频的采集窗口参数

设置采集窗口就是在摄像头设备的取景范围之内设定一个视频采集区域。主要是对结构体v4l2_crop赋值,v4l2_crop由一个v4l2_buffer_type枚举类型的type和v4l2_rect类型的结构体c构成,来描述视频采集窗口的类型和大小。type设置为视频采集类型V4L2_BUF_TYPE_VIDEO_CAPTURE。c是表示采集窗口的大小的结构体,它的成员Left和Top分别表示视频采集区域的起始横坐标和纵坐标,width和height分别表示采集图像的宽度和高度。赋值后,用ioctl函数通过这个结构体对fd_v4l2进行设置。

struct v4l2_crop { enum v4l2_buf_type type;

struct v4l2_rect c;

};

(2)设置视频点阵格式和点阵大小

主要是对结构体v4l2_format进行赋值,它由type和联合体fmt构成,来描述视频设备当前行为和数据的格式。

把type赋值为视频采集类型V4L2_BUF_TYPE_VIDEO_CAPTURE,表示定义了一个视频采集流类型的buffer。fmt中,pix为表示图形格式的v4l2_pix_format型结构体。需要设定pix里的几个变量,pixelformat表示采集格式,设置为V4L2_PIX_FMT_YUV420;width、height表示图像的宽度、高度,以字节为单位;sizeimage表示图像所占的存储空间大小,以字节为单位;bytesperline表示每一行的字节数。赋值后,用ioctl函数通过这个结构体对fd_ v4l2进行设置。

struct v4l2_format

{ enum v4l2_buf_type type;

union

{ struct v4l2_pix_format pix; // V4L2_BUF_TYPE_VIDEO_CAPTURE

struct v4l2_window win; // V4L2_BUF_TYPE_VIDEO_OVERLAY

__u8 raw_data[200]; // user-defined

} fmt;

};

(3)设置视频采集的帧率

结构体v4l2_streamparm来描述视频流的属性,它由type和联合体parm构成。type同上,由于选的是V4L2_BUF_TYPE_VIDEO_CAPTURE,所以仅需设定parm中的v412_capture型结构体capture即可。在其中, v4l2_fract型结构体timeperframe表示平均每一帧所占的时间,由其元素numerator和denominator共同决定,该时长为numerator/denominator;而capturemode则表示采集模式,采集高质量图片值为1,一般设为0。赋值之后,用ioctl函数通过这个结构体对fd_ v4l2进行设置。

struct v4l2_streamparm

{ enum v4l2_buf_type type;

union

{ struct v4l2_captureparm capture;

struct v4l2_outputparm output;

__u8 raw_data[200]; /* user-defined */

} parm;

};

2.申请并设置视频采集的帧缓冲区

前期初始化完成后,只是解决了一帧视频数据的格式和大小问题,而连续视频帧数据的采集需要用帧缓冲区队列的方式来解决,即要通过驱动程序在内存中申请几个帧缓冲区来存放视频数据。

应用程序通过API接口提供的方法(VIDIOC_REQBUFS)申请若干个视频数据的帧缓冲区,申请帧缓冲区数量一般不低于3个,每个帧缓冲区存放一帧视频数据,这些帧缓冲区在内核空间。

应用程序通过API接口提供的查询方法(VIDIOC_QUERYBUF)查询到帧缓冲区在内核空间的长度和偏移量地址。

应用程序再通过内存映射方法(mmap),将申请到的内核空间帧缓冲区的地址映射到用户空间地址,这样就可以直接处理帧缓冲区的数据。

(1)将帧缓冲区在视频输入队列排队,并启动视频采集

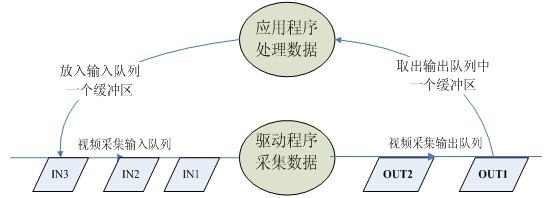

在驱动程序处理视频的过程中,定义了两个队列:视频采集输入队列(incoming queues)和视频采集输出队列(outgoing queues),前者是等待驱动存放视频数据的队列,后者是驱动程序已经放入了视频数据的队列。如图2所示。

应用程序需要将上述帧缓冲区在视频采集输入队列排队(VIDIOC_QBUF),然后可启动视频采集。

(2)循环往复,采集连续的视频数据

启动视频采集后,驱动程序开始采集一帧数据,把采集的数据放入视频采集输入队列的第一个帧缓冲区,一帧数据采集完成,也就是第一个帧缓冲区存满一帧数据后,驱动程序将该帧缓冲区移至视频采集输出队列,等待应用程序从输出队列取出。驱动程序接下来采集下一帧数据,放入第二个帧缓冲区,同样帧缓冲区存满下一帧数据后,被放入视频采集输出队列。

应用程序从视频采集输出队列中取出含有视频数据的帧缓冲区,处理帧缓冲区中的视频数据,如存储或压缩。

最后,应用程序将处理完数据的帧缓冲区重新放入视频采集输入队列,这样可以循环采集,如图1所示。

图1 视频采集输入和输出队列示意图

(3)最终停止采集,释放内存帧缓冲区

3.用V4L2采集视频的程序流程和相关API

V4L2采集视频操作基本按照打开视频设备、设置视频格式、启动视频采集,循环处理视频数据、停止视频采集、关闭视频设备,具体操作通过ioctl等函数来实现。一般操作流程如下:

(1)打开视频设备文件。int fd=open("/dev/video0",O_RDWR);

(2)查询视频设备的能力,比如是否具有视频输入,或者音频输入输出等。ioctl(fd_v4l, VIDIOC_QUERYCAP, &cap)

(3)设置视频采集的参数

设置视频的制式,制式包括PAL/NTSC,使用ioctl(fd_v4l, VIDIOC_S_STD, &std_id)

设置视频图像的采集窗口的大小,使用ioctl(fd_v4l, VIDIOC_S_CROP, &crop)

设置视频帧格式,包括帧的点阵格式,宽度和高度等,使用ioctl(fd_v4l, VIDIOC_S_FMT, &fmt)

设置视频的帧率,使用ioctl(fd_v4l, VIDIOC_S_PARM, &parm)

设置视频的旋转方式,使用ioctl(fd_v4l, VIDIOC_S_CTRL, &ctrl)

(4)向驱动申请视频流数据的帧缓冲区

请求/申请若干个帧缓冲区,一般为不少于3个,使用ioctl(fd_v4l, VIDIOC_REQBUFS, &req)

查询帧缓冲区在内核空间中的长度和偏移量 ioctl(fd_v4l, VIDIOC_QUERYBUF, &buf)

(5)应用程序通过内存映射,将帧缓冲区的地址映射到用户空间,这样就可以直接操作采集到的帧了,而不必去复制。

buffers[i].start = mmap (NULL, buffers[i].length, PROT_READ | PROT_WRITE, MAP_SHARED, fd_v4l, buffers[i].offset);

(6)将申请到的帧缓冲全部放入视频采集输出队列,以便存放采集的数据。ioctl (fd_v4l, VIDIOC_QBUF, &buf)

(7)开始视频流数据的采集。 ioctl (fd_v4l, VIDIOC_STREAMON, &type)

(8) 驱动将采集到的一帧视频数据存入输入队列第一个帧缓冲区,存完后将该帧缓冲区移至视频采集输出队列。

(9)应用程序从视频采集输出队列中取出已含有采集数据的帧缓冲区。ioctl (fd_v4l, VIDIOC_DQBUF, &buf) ,应用程序处理该帧缓冲区的原始视频数据。

(10)处理完后,应用程序的将该帧缓冲区重新排入输入队列,这样便可以循环采集数据。ioctl (fd_v4l, VIDIOC_QBUF, &buf)

重复上述步骤8到10,直到停止采集数据。

(11)停止视频的采集。ioctl (fd_v4l, VIDIOC_STREAMOFF, &type)

(12)释放申请的视频帧缓冲区unmap,关闭视频设备文件close(fd_v4l)。

以上的程序流程,包含了视频设备采集连续的视频数据的逻辑关系。而在实际运用中,往往还要加入对视频数据进行处理(如压缩编码)的工作,否则,视频流数据量相当大,需要很大的存储空间和传输带宽。

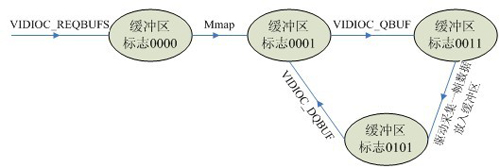

上述过程中,每一个帧缓冲区都有一个对应的状态标志变量,其中每一个比特代表一个状态

V4L2_BUF_FLAG_UNMAPPED 0B0000

V4L2_BUF_FLAG_MAPPED 0B0001

V4L2_BUF_FLAG_ENQUEUED 0B0010

V4L2_BUF_FLAG_DONE 0B0100

缓冲区的状态转化如图2所示。

图2 缓冲区的状态标志转化图

三、结束语

V4L2是Linux环境下开发视频采集设备驱动程序的一套规范(API),它为驱动程序的编写提供统一的接口,并将所有的视频采集设备的驱动程序都纳入其的管理之中。V4L2不仅给驱动程序编写者带来极大的方便,同时也方便了应用程序的编写和移植,具有广泛的应用价值。

常用的结构体在内核目录include/linux/videodev2.h中定义

struct v4l2_requestbuffers //申请帧缓冲,对应命令VIDIOC_REQBUFS

struct v4l2_capability //视频设备的功能,对应命令VIDIOC_QUERYCAP

struct v4l2_input //视频输入信息,对应命令VIDIOC_ENUMINPUT

struct v4l2_standard //视频的制式,比如PAL,NTSC,对应命令VIDIOC_ENUMSTD

struct v4l2_format //帧的格式,对应命令VIDIOC_G_FMT、VIDIOC_S_FMT等

struct v4l2_buffer //驱动中的一帧图像缓存,对应命令VIDIOC_QUERYBUF

struct v4l2_crop //视频信号矩形边框

v4l2_std_id //视频制式

V4L2采用流水线的方式,操作更简单直观,基本遵循打开视频设备、设置格式、处理数据、关闭设备,更多的具体操作通过ioctl函数来实现。

1.打开视频设备

在V4L2中,视频设备被看做一个文件。使用open函数打开这个设备:

// 用非阻塞模式打开摄像头设备

int cameraFd;

cameraFd = open("/dev/video0", O_RDWR | O_NONBLOCK, 0);

// 如果用阻塞模式打开摄像头设备,上述代码变为:

//cameraFd = open("/dev/video0", O_RDWR, 0);

应用程序能够使用阻塞模式或非阻塞模式打开视频设备,如果使用非阻塞模式调用视频设备,即使尚未捕获到信息,驱动依旧会把缓存(DQBUFF)里的东西返回给应用程序。

2. 设定属性及采集方式

打开视频设备后,可以设置该视频设备的属性,例如裁剪、缩放等。这一步是可选的。在Linux编程中,一般使用ioctl函数来对设备的I/O通道进行管理:

int ioctl (int __fd, unsigned long int __request, .../*args*/) ;

在进行V4L2开发中,常用的命令标志符如下(some are optional):

• VIDIOC_REQBUFS:分配内存

• VIDIOC_QUERYBUF:把VIDIOC_REQBUFS中分配的数据缓存转换成物理地址

• VIDIOC_QUERYCAP:查询驱动功能

• VIDIOC_ENUM_FMT:获取当前驱动支持的视频格式

• VIDIOC_S_FMT:设置当前驱动的频捕获格式

• VIDIOC_G_FMT:读取当前驱动的频捕获格式

• VIDIOC_TRY_FMT:验证当前驱动的显示格式

• VIDIOC_CROPCAP:查询驱动的修剪能力

• VIDIOC_S_CROP:设置视频信号的边框

• VIDIOC_G_CROP:读取视频信号的边框

• VIDIOC_QBUF:把数据从缓存中读取出来

• VIDIOC_DQBUF:把数据放回缓存队列

• VIDIOC_STREAMON:开始视频显示函数

• VIDIOC_STREAMOFF:结束视频显示函数

• VIDIOC_QUERYSTD:检查当前视频设备支持的标准,例如PAL或NTSC。

2.1检查当前视频设备支持的标准

在亚洲,一般使用PAL(720X576)制式的摄像头,而欧洲一般使用NTSC(720X480),使用VIDIOC_QUERYSTD来检测:

v4l2_std_id std;

do {

ret = ioctl(fd, VIDIOC_QUERYSTD, &std);

} while (ret == -1 && errno == EAGAIN);

switch (std) {

case V4L2_STD_NTSC:

//……

case V4L2_STD_PAL:

//……

}

2.2 设置视频捕获格式

当检测完视频设备支持的标准后,还需要设定视频捕获格式,结构如下:

struct v4l2_format fmt;

memset ( &fmt, 0, sizeof(fmt) );

fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.width = 720;

fmt.fmt.pix.height = 576;

fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.field = V4L2_FIELD_INTERLACED;

if (ioctl(fd, VIDIOC_S_FMT, &fmt) == -1) {

return -1;

}

v4l2_format结构如下:

struct v4l2_format {

enum v4l2_buf_type type; //数据流类型,必须永远是V4L2_BUF_TYPE_VIDEO_CAPTURE

union

{

struct v4l2_pix_format pix;

struct v4l2_window win;

struct v4l2_vbi_format vbi;

__u8 raw_data[200];

} fmt;

};

struct v4l2_pix_format {

__u32 width; // 宽,必须是16的倍数

__u32 height; // 高,必须是16的倍数

__u32 pixelformat; // 视频数据存储类型,例如是YUV4:2:2还是RGB

enum v4l2_field field;

__u32 bytesperline;

__u32 sizeimage;

enum v4l2_colorspace colorspace;

__u32 priv;

};

2.3 分配内存

接下来可以为视频捕获分配内存:

struct v4l2_requestbuffers req;

req.count = BUFFER_COUNT;

req.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

req.memory = V4L2_MEMORY_MMAP;

if (ioctl(fd, VIDIOC_REQBUFS, &req) == -1) {

return -1;

}

v4l2_requestbuffers 结构如下:

struct v4l2_requestbuffers {

u32 count;//缓存数量,也就是说在缓存队列里保持多少张照片

enum v4l2_buf_type type; //数据流类型,必须永远是V4L2_BUF_TYPE_VIDEO_CAPTURE

enum v4l2_memory memory;//V4L2_MEMORY_MMAP或V4L2_MEMORY_USERPTR

u32 reserved[2];

};

2.4 获取并记录缓存的物理空间

使用VIDIOC_REQBUFS,我们获取了req.count个缓存,下一步通过调用VIDIOC_QUERYBUF命令来获取这些缓存的地址,然后使用mmap函数转换成应用程序中的绝对地址,最后把这段缓存放入缓存队列:

typedef struct VideoBuffer {

void *start;

size_t length;

} VideoBuffer;

v4l2_buffer 结构如下:

struct v4l2_buffer {

__u32 index;

enum v4l2_buf_type type;

__u32 bytesused;

__u32 flags;

enum v4l2_field field;

struct timeval timestamp;

struct v4l2_timecode timecode;

__u32 sequence;

/* memory location */

enum v4l2_memory memory;

union {

__u32 offset;

unsigned long userptr;

} m;

__u32 length;

__u32 input;

__u32 reserved;

};

VideoBuffer* buffers = calloc( req.count, sizeof(*buffers) );

struct v4l2_buffer buf;

for (numBufs = 0; numBufs < req.count; numBufs++)

{

memset( &buf, 0, sizeof(buf) );

buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory = V4L2_MEMORY_MMAP;

buf.index = numBufs;

// 读取缓存

if (ioctl(fd, VIDIOC_QUERYBUF, &buf) == -1) {

return -1;

}

buffers[numBufs].length = buf.length;

// 转换成相对地址

buffers[numBufs].start = mmap(NULL, buf.length, PROT_READ | PROT_WRITE,

MAP_SHARED,fd, buf.m.offset);

if (buffers[numBufs].start == MAP_FAILED) {

return -1;

}

// 放入缓存队列

if (ioctl(fd, VIDIOC_QBUF, &buf) == -1) {

return -1;

}

}

2.5 视频采集方式

操作系统一般把系统使用的内存划分成用户空间和内核空间,分别由应用程序管理和操作系统管理。应用程序可以直接访问内存的地址,而内核空间存放的是供内核访问的代码和数据,用户不能直接访问。v4l2捕获的数据,最初是存放在内核空间的,这意味着用户不能直接访问该段内存,必须通过某些手段来转换地址。

一共有三种视频采集方式:使用read/write方式;内存映射方式和用户指针模式。

read、write方式,在用户空间和内核空间不断拷贝数据,占用了大量用户内存空间,效率不高。

内存映射方式:把设备里的内存映射到应用程序中的内存控件,直接处理设备内存,这是一种有效的方式。上面的mmap函数就是使用这种方式。

用户指针模式:内存片段由应用程序自己分配。这点需要在v4l2_requestbuffers里将memory字段设置成V4L2_MEMORY_USERPTR。

2.6 处理采集数据

V4L2有一个数据缓存,存放req.count数量的缓存数据。数据缓存采用FIFO的方式,当应用程序调用缓存数据时,缓存队列将最先采集到的视频数据缓存送出,并重新采集一张视频数据。这个过程需要用到两个ioctl命令,VIDIOC_DQBUF和VIDIOC_QBUF:

struct v4l2_buffer buf;

memset(&buf,0,sizeof(buf));

buf.type=V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory=V4L2_MEMORY_MMAP;

buf.index=0;

//读取缓存

if (ioctl(cameraFd, VIDIOC_DQBUF, &buf) == -1)

{

return -1;

}

//…………视频处理算法

//重新放入缓存队列

if (ioctl(cameraFd, VIDIOC_QBUF, &buf) == -1) {

return -1;

}

3. 关闭视频设备

使用close函数关闭一个视频设备

close(cameraFd)

如果使用mmap,最后还需要使用munmap方法。

下面是damo程序(经过实际验证,修改了网上的例程的错误)

-----------------------------------------------------------------------------------------------------------

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <assert.h>

#include <getopt.h>

#include <fcntl.h>

#include <unistd.h>

#include <errno.h>

#include <malloc.h>

#include <sys/stat.h>

#include <sys/types.h>

#include <sys/time.h>

#include <sys/mman.h>

#include <sys/ioctl.h>

#include <asm/types.h>

#include <linux/videodev2.h>

#define CAMERA_DEVICE "/dev/video0"

#define CAPTURE_FILE "frame.jpg"

#define VIDEO_WIDTH 640

#define VIDEO_HEIGHT 480

#define VIDEO_FORMAT V4L2_PIX_FMT_YUYV

#define BUFFER_COUNT 4

typedef struct VideoBuffer {

void *start;

size_t length;

} VideoBuffer;

int main()

{

int i, ret;

// 打开设备

int fd;

fd = open(CAMERA_DEVICE, O_RDWR, 0);

if (fd < 0) {

printf("Open %s failed\n", CAMERA_DEVICE);

return -1;

}

// 获取驱动信息

struct v4l2_capability cap;

ret = ioctl(fd, VIDIOC_QUERYCAP, &cap);

if (ret < 0) {

printf("VIDIOC_QUERYCAP failed (%d)\n", ret);

return ret;

}

// Print capability infomations

printf("Capability Informations:\n");

printf(" driver: %s\n", cap.driver);

printf(" card: %s\n", cap.card);

printf(" bus_info: %s\n", cap.bus_info);

printf(" version: %08X\n", cap.version);

printf(" capabilities: %08X\n", cap.capabilities);

// 设置视频格式

struct v4l2_format fmt;

memset(&fmt, 0, sizeof(fmt));

fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.width = VIDEO_WIDTH;

fmt.fmt.pix.height = VIDEO_HEIGHT;

fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.field = V4L2_FIELD_INTERLACED;

ret = ioctl(fd, VIDIOC_S_FMT, &fmt);

if (ret < 0) {

printf("VIDIOC_S_FMT failed (%d)\n", ret);

return ret;

}

// 获取视频格式

ret = ioctl(fd, VIDIOC_G_FMT, &fmt);

if (ret < 0) {

printf("VIDIOC_G_FMT failed (%d)\n", ret);

return ret;

}

// Print Stream Format

printf("Stream Format Informations:\n");

printf(" type: %d\n", fmt.type);

printf(" width: %d\n", fmt.fmt.pix.width);

printf(" height: %d\n", fmt.fmt.pix.height);

char fmtstr[8];

memset(fmtstr, 0, 8);

memcpy(fmtstr, &fmt.fmt.pix.pixelformat, 4);

printf(" pixelformat: %s\n", fmtstr);

printf(" field: %d\n", fmt.fmt.pix.field);

printf(" bytesperline: %d\n", fmt.fmt.pix.bytesperline);

printf(" sizeimage: %d\n", fmt.fmt.pix.sizeimage);

printf(" colorspace: %d\n", fmt.fmt.pix.colorspace);

printf(" priv: %d\n", fmt.fmt.pix.priv);

printf(" raw_date: %s\n", fmt.fmt.raw_data);

// 请求分配内存

struct v4l2_requestbuffers reqbuf;

reqbuf.count = BUFFER_COUNT;

reqbuf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

reqbuf.memory = V4L2_MEMORY_MMAP;

ret = ioctl(fd , VIDIOC_REQBUFS, &reqbuf);

if(ret < 0) {

printf("VIDIOC_REQBUFS failed (%d)\n", ret);

return ret;

}

// 获取空间

VideoBuffer* buffers = calloc( reqbuf.count, sizeof(*buffers) );

struct v4l2_buffer buf;

for (i = 0; i < reqbuf.count; i++)

{

buf.index = i;

buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory = V4L2_MEMORY_MMAP;

ret = ioctl(fd , VIDIOC_QUERYBUF, &buf);

if(ret < 0) {

printf("VIDIOC_QUERYBUF (%d) failed (%d)\n", i, ret);

return ret;

}

// mmap buffer

framebuf[i].length = buf.length;

framebuf[i].start = (char *) mmap(0, buf.length, PROT_READ|PROT_WRITE, MAP_SHARED, fd, buf.m.offset);

if (framebuf[i].start == MAP_FAILED) {

printf("mmap (%d) failed: %s\n", i, strerror(errno));

return -1;

}

// Queen buffer

ret = ioctl(fd , VIDIOC_QBUF, &buf);

if (ret < 0) {

printf("VIDIOC_QBUF (%d) failed (%d)\n", i, ret);

return -1;

}

printf("Frame buffer %d: address=0x%x, length=%d\n", i, (unsigned int)framebuf[i].start, framebuf[i].length);

}

// 开始录制

enum v4l2_buf_type type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

ret = ioctl(fd, VIDIOC_STREAMON, &type);

if (ret < 0) {

printf("VIDIOC_STREAMON failed (%d)\n", ret);

return ret;

}

// Get frame

ret = ioctl(fd, VIDIOC_DQBUF, &buf);

if (ret < 0) {

printf("VIDIOC_DQBUF failed (%d)\n", ret);

return ret;

}

// Process the frame

FILE *fp = fopen(CAPTURE_FILE, "wb");

if (fp < 0) {

printf("open frame data file failed\n");

return -1;

}

fwrite(framebuf[buf.index].start, 1, buf.length, fp);

fclose(fp);

printf("Capture one frame saved in %s\n", CAPTURE_FILE);

// Re-queen buffer

ret = ioctl(fd, VIDIOC_QBUF, &buf);

if (ret < 0) {

printf("VIDIOC_QBUF failed (%d)\n", ret);

return ret;

}

// Release the resource

for (i=0; i< 4; i++)

{

munmap(framebuf[i].start, framebuf[i].length);

}

close(fd);

printf("Camera test Done.\n");

return 0;

}

-----------------------------------------------------------------------------------------------------------

附件:

void *mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset);

int munmap(void *start, size_t length);

参数说明:

——start:映射区的开始地址。

——length:映射区的长度。

——prot:期望的内存保护标志,不能与文件的打开模式冲突。是以下的某个值,可以通过or运算合理地组合在一起

—PROT_EXEC //页内容可以被执行

—PROT_READ //页内容可以被读取

—PROT_WRITE //页可以被写入

—PROT_NONE //页不可访问

——flags:指定映射对象的类型,映射选项和映射页是否可以共享。它的值可以是一个或者多个以下位的组合体

—MAP_FIXED //使用指定的映射起始地址,如果由start和len参数指定的内存区重叠于现存的映射空间,重叠部分将会被丢弃。如果指定的起始地址不可用,操作将会失败。并且起始地址必须落在页的边界上。

—MAP_SHARED //与其它所有映射这个对象的进程共享映射空间。对共享区的写入,相当于输出到文件。直到msync()或者munmap()被调用,文件实际上不会被更新。

—MAP_PRIVATE //建立一个写入时拷贝的私有映射。内存区域的写入不会影响到原文件。这个标志和以上标志是互斥的,只能使用其中一个。

—MAP_DENYWRITE //这个标志被忽略。

—MAP_EXECUTABLE //同上

—MAP_NORESERVE //不要为这个映射保留交换空间。当交换空间被保留,对映射区修改的可能会得到保证。当交换空间不被保留,同时内存不足,对映射区的修改会引起段违例信号。

—MAP_LOCKED //锁定映射区的页面,从而防止页面被交换出内存。

—MAP_GROWSDOWN //用于堆栈,告诉内核VM系统,映射区可以向下扩展。

—MAP_ANONYMOUS //匿名映射,映射区不与任何文件关联。

—MAP_ANON //MAP_ANONYMOUS的别称,不再被使用。

—MAP_FILE //兼容标志,被忽略。

—MAP_32BIT //将映射区放在进程地址空间的低2GB,MAP_FIXED指定时会被忽略。当前这个标志只在x86-64平台上得到支持。

—MAP_POPULATE //为文件映射通过预读的方式准备好页表。随后对映射区的访问不会被页违例阻塞。

—MAP_NONBLOCK //仅和MAP_POPULATE一起使用时才有意义。不执行预读,只为已存在于内存中的页面建立页表入口。

——fd:有效的文件描述词。如果MAP_ANONYMOUS被设定,为了兼容问题,其值应为-1。

——offset:被映射对象内容的起点。

返回值:

成功执行时,mmap()返回被映射区的指针,munmap()返回0。

失败时,mmap()返回MAP_FAILED[其值为(void *)-1],munmap返回-1。errno被设为以下的某个值。

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架介绍

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- V4L2应用程序框架

- Balanced Binary Tree

- 服务器php安装configure: error: mcrypt.h not found. Please reinstall libmcrypt

- 如何进入开发板不需要密码

- open和fopen的区别:

- Visual Studio从2010升级到2012或2013后,打开Opencv相关项目可能出现的问题

- V4L2应用程序框架

- samba 设置匿名访问目录

- fullJustify

- DBUtils学习

- halcon测量一个圆的直径

- UItableView(重点:xib封装view)

- 正则表达式之BRE与ERE字符集

- VC添加文件到工程出错问题--FileTool.dll

- centos 6.4 用openswan ipsec和xl2tpd搭建l2tp VPN