Eclipse的安装和Hadoop的配置

来源:互联网 发布:编程方向 编辑:程序博客网 时间:2024/04/30 22:41

第一次使用hadoop,另外eclipse也不太熟悉,现在把自己在安装过程中得琐碎问题记录下来。

eclipse版本:eclipse-jee-indigo-SR2-linux-gtk.tar.gz

hadoop版本:hadoop-0.20.203.0

本文前提是,你已经正确安装了hadoop-0.20.203.0,hadoop伪分布模式的安装过程网上有很多。

eclipse下载解压后,直接点击eclipse图标打开即可(很绿色环保~~)

1.插件安装

在$HADOOP_HOME/contrib/eclipse-plugin/文件夹中有个hadoop-eclipse-plugin-0.20.203.0.jar,把这个文件复制到eclipse/plugins(这是eclipse的插件目录)下面即可。

注意在直接复制时会出错,主要是缺少jar包。

解决方法:(1)将commons-httpclient-3.0.1.jar,jackson-core-asl-1.0.1.jar,jackson-mapper-asl-1.0.1.jar,commons-configuration-1.6.jar,lcommons-lang-2.4.jar(这几个jar包在$HADOOP_HOME/lib/下找到)放入hadoop-0.20.203.0-eclipse-plugin的lib下

(2)修改hadoop-0.20.203.0-eclipse-plugin/META-INF/MANIFEST.MF 中的Bundle-ClassPath项

Bundle-ClassPath: classes/,lib/hadoop-core.jar,lib/commons-cli-1.2.jar,lib/commons-httpclient-3.0.1.jar,lib/jackson-core-asl-1.0.1.jar,lib/jackson-mapper-asl-1.0.1.jar,lib/commons-configuration-1.6.jar,lib/commons-lang-2.4.jar2.环境配置

启动Eclipse,然后在Window->Preferences->Hadoop Map/Reduce中添加Hadoop的安装目录

配置hadoop环境:在Window–>Show View中打开Map/Reduce Locations,在底部会看到新的选项。然后右键–>New Hadoop Location,

Location name是你自己取的名字,我这里用了hadoop,Map/Reduce Master这里的host和port对应上面mapred-site.xml中mapred.job.tracker的值,我配置的是localhost和9001;DFS Master对应上面core-site.xml中fs.default.name中的值,我配置的是localhost和9000.

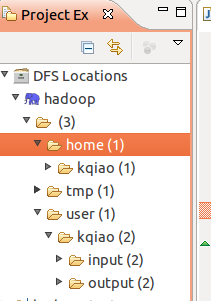

完成后,如果屏幕左上方的DFS Locations中的内容可以正常显示,说明配置一切成功。

3.运行wordcount

使用Eclipse编写Hadoop的程序了,按该方式创建File->New->Project->Map/Reduce Project.命名为hadoop-test。

将hadoop-0.20.203.0/src/examples/org/apache/hadoop/examples下的wordcount.java复制到当前项目中。

注意:要在src中看到WordCount.java文件,如果已经复制过来还看不到,在hadoop-test上右击选择refresh试一试。

另外,直接复制过来的文件,第一行要注释掉 //package org.apache.hadoop.examples;

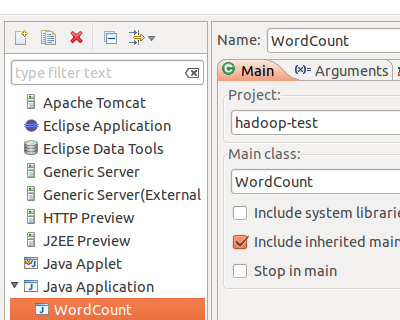

在Run configuration/Java Application/WordCount下进行程序参数设置

input为又本地导入HDFS得输入文件,其中包含两个文本文件,file01和file02

完成后,使用 Run As/Run on Hadoop运行~~~~

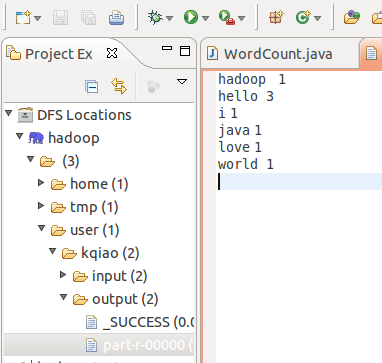

在HDFS系统视图下可以看到刚才得运行结果

中途碰到得问题:装得时候不知道怎么回事,项目侧边栏(Project explorer)看不见了。或者侧边栏是Package explorer,这种情况下是看不见DFS Locations的,应该在菜单栏

Window/Open pespective/<Map/Reduce>。然后就能看到HDFS文件系统已经所创建得一些项目。

参考博客:http://phz50.iteye.com/blog/932373

http://chaoswork.com/blog/2011/12/25/

http://qa.taobao.com/?p=10659

» 下一篇:hadoop Streaming的使用

- Eclipse的安装和Hadoop的配置

- eclipse上hadoop插件的安装和配置

- 2.1hadoop伪分布式----eclipse的安装和配置

- Hadoop的安装和配置

- 安装配置hadoop和eclipse插件遇到的坑和解决办法

- Hadoop的安装方法,以及Eclipse编写MapReduce的配置,

- Hadoop 2.x 的安装和配置

- hadoop集群的安装步骤和配置

- hadoop分布式模式的安装和配置

- Centos7上Hadoop的安装和配置

- hadoop-2.7.3的安装和配置

- Hadoop的安装配置

- Hadoop的安装配置

- Hadoop的安装配置

- Hadoop的安装配置

- hadoop的配置安装

- win7安装hadoop及eclipse调试mapreduce的配置方法

- Hadoop开发环境的配置(安装eclipse)

- 关于systemd和sysvinit的说明

- 排序的比较

- matlab里面有关的函数(杂)

- 文件读写&文件夹遍历

- 低音增强

- Eclipse的安装和Hadoop的配置

- OJ类模板

- 翻转字符串中单词的顺序

- PHP源码分析-面向对象(一)

- 搜索引擎-架构概述(2)

- (转载)android学习之旅-Intent详解

- Java内存泄露及避免方法

- Shell基础-脚本执行方式

- 让mysql支持远程登录