关于librtmp接收数据

来源:互联网 发布:单片机进阶书籍 编辑:程序博客网 时间:2024/06/06 17:41

关于librtmp接收数据,过程比较简单,但是细节还是比较麻烦;

简单的librtmp接收数据,可以参考最简单的基于librtmp的示例:接收(RTMP保存为FLV)

=====================================================

最简单的基于libRTMP的示例系列文章列表:

最简单的基于librtmp的示例:接收(RTMP保存为FLV)

最简单的基于librtmp的示例:发布(FLV通过RTMP发布)

最简单的基于librtmp的示例:发布H.264(H.264通过RTMP发布)

=====================================================

本文记录一个基于libRTMP的接收流媒体的程序:Simplest libRTMP Receive。该程序可以将RTMP流保存成本地FLV文件。实际上本文记录的程序就是一个“精简”过的RTMPDump。RTMPDump功能比较多,因而其代码比较复杂导致很多初学者不知从何下手。而本文记录的这个程序只保留了RTMPDump中最核心的函数,更加方便新手入门学习libRTMP。

流程图

使用librtmp接收RTMP流的函数执行流程图如下图所示。

流程图中关键函数的作用如下所列:

InitSockets():初始化Socket

RTMP_Alloc():为结构体“RTMP”分配内存。

RTMP_Init():初始化结构体“RTMP”中的成员变量。

RTMP_SetupURL():设置输入的RTMP连接的URL。

RTMP_Connect():建立RTMP连接,创建一个RTMP协议规范中的NetConnection。

RTMP_ConnectStream():创建一个RTMP协议规范中的NetStream。

RTMP_Read():从服务器读取数据。

RTMP_Close():关闭RTMP连接。

RTMP_Free():释放结构体“RTMP”。

CleanupSockets():关闭Socket。

其中NetStream和NetConnection是RTMP协议规范中的两个逻辑结构。NetStream建立在NetConnection之上。一个NetConnection可以包含多个NetStream。它们之间的关系如下图所示。

源代码

运行结果

程序运行后,会将URL为“rtmp://live.hkstv.hk.lxdns.com/live/hks”的直播流(实际上是香港卫视)在本地保存为“receive.flv”。保存后的文件使用播放器就可以观看。

下载

Simplest LibRTMP Example

项目主页

SourceForge:https://sourceforge.net/projects/simplestlibrtmpexample/

Github:https://github.com/leixiaohua1020/simplest_librtmp_example

开源中国:http://git.oschina.net/leixiaohua1020/simplest_librtmp_example

本工程包含了LibRTMP的使用示例,包含如下子工程:

simplest_librtmp_receive: 接收RTMP流媒体并在本地保存成FLV格式的文件。

simplest_librtmp_send_flv: 将FLV格式的视音频文件使用RTMP推送至RTMP流媒体服务器。

simplest_librtmp_send264: 将内存中的H.264数据推送至RTMP流媒体服务器。

上述内容 比较简明;

如果想通过librtmp自己分开接收音视频数据,要怎么处理呢?

视频接收:

可以参考 http://www.programering.com/a/MTOyQzNwATc.html

The H264 bitstream extraction to receive the flv stream in librtmp: according to

If the audio or video convection in a separate processing, to extract respectively based on flv protocol.

Simple modifications to the rtmpdump code, to increase the corresponding function.

1 audio extraction:

Rtmpdump download cycle in the Download function:

....

do

{

....

nRead = RTMP_Read(rtmp, buffer, bufferSize);

....

}while(!RTMP_ctrlC && nRead > -1 && RTMP_IsConnected(rtmp) && !RTMP_IsTimedout(rtmp));

....

The original program is written documents received, generate flv.

Now, are extracted from the audio and video before writing, audio extraction is simple, direct analysis of the buffer (Reference method for the RTMP_Write function).

Note that, rtmpdump is used in the RTMP_Read to receive, pay attention to its parameters. For the sake of convenience, can be directly used RTMP_ReadPacket. Behind the video using RTMP_ReadPacket to receive and process.

int RTMP_Write2(RTMP *r, const char *buf, int size)

{

RTMPPacket *pkt = &r->m_write;

char *pend, *enc;

int s2 = size, ret, num;

if (size <11) {

/* FLV pkt too small */

return 0;

}

if (buf[0] == 'F' && buf[1] == 'L' && buf[2] == 'V')

{

buf += 13;

s2 -= 13;

}

pkt->m_packetType = *buf++;

pkt->m_nBodySize = AMF_DecodeInt24(buf);

buf += 3;

pkt->m_nTimeStamp = AMF_DecodeInt24(buf);

buf += 3;

pkt->m_nTimeStamp |= *buf++ <<24;

buf += 3;

s2 -= 11;

if (((pkt->m_packetType == RTMP_PACKET_TYPE_AUDIO

|| pkt->m_packetType == RTMP_PACKET_TYPE_VIDEO) &&

!pkt->m_nTimeStamp) || pkt->m_packetType == RTMP_PACKET_TYPE_INFO)

{

pkt->m_headerType = RTMP_PACKET_SIZE_LARGE;

if (pkt->m_packetType == RTMP_PACKET_TYPE_INFO)

pkt->m_nBodySize += 16;

}

else

{

pkt->m_headerType = RTMP_PACKET_SIZE_MEDIUM;

}

BYTE outbuf2[640];

int nLen2 = 640;

AVManager::GetInstance()->Decode((BYTE*)(pkt->m_body+1), pkt->m_nBodySize-1, outbuf2, nLen2);

//The actual audio content for the pkt-> m_body+1, size is pkt-> m_nBodySize-1. Here is the voice of Speex code.

Why to skip the first byte, can refer to: http://bbs.rosoo.net/thread-16488-1-1.html

evt_OnReceivePacket((char*)outbuf2, nLen2);//The callback.

RTMPPacket_Free(pkt);

pkt->m_nBytesRead = 0;

2

Video processing

You can refer to the rtmpsrv.c

The nRead = RTMP_Read (RTMP, buffer, bufferSize); change:

RTMPPacket pc = { 0 }, ps = { 0 };

bool bFirst = true;

while (RTMP_ReadPacket(rtmp, &pc))

{

if (RTMPPacket_IsReady(&pc))

{

if (pc.m_packetType == RTMP_PACKET_TYPE_VIDEO && RTMP_ClientPacket(rtmp, &pc))

{

bool bIsKeyFrame = false;

if (result == 0x17)//I frame

{

bIsKeyFrame = true;

}

else if (result == 0x27)

{

bIsKeyFrame = false;

}

static unsigned char const start_code[4] = {0x00, 0x00, 0x00, 0x01};

fwrite(start_code, 1, 4, pf );

//int ret = fwrite(pc.m_body + 9, 1, pc.m_nBodySize-9, pf);

if( bFirst) {

//AVCsequence header

//ioBuffer.put(foredata);

//Access to SPS

int spsnum = data[10]&0x1f;

int number_sps = 11;

int count_sps = 1;

while (count_sps<=spsnum){

int spslen =(data[number_sps]&0x000000FF)<<8 |(data[number_sps+1]&0x000000FF);

number_sps += 2;

fwrite(data+number_sps, 1, spslen, pf );

fwrite(start_code, 1, 4, pf );

//ioBuffer.put(data,number_sps, spslen);

//ioBuffer.put(foredata);

number_sps += spslen;

count_sps ++;

}

//Get PPS

int ppsnum = data[number_sps]&0x1f;

int number_pps = number_sps+1;

int count_pps = 1;

while (count_pps<=ppsnum){

int ppslen =(data[number_pps]&0x000000FF)<<8|data[number_pps+1]&0x000000FF;

number_pps += 2;

//ioBuffer.put(data,number_pps,ppslen);

//ioBuffer.put(foredata);

fwrite(data+number_pps, 1, ppslen, pf );

fwrite(start_code, 1, 4, pf );

number_pps += ppslen;

count_pps ++;

}

bFirst =false;

} else {

//AVCNALU

int len =0;

int num =5;

//ioBuffer.put(foredata);

while(num<pc.m_nBodySize)

{

len =(data[num]&0x000000FF)<<24|(data[num+1]&0x000000FF)<<16|(data[num+2]&0x000000FF)<<8|data[num+3]&0x000000FF;

num = num+4;

//ioBuffer.put(data,num,len);

//ioBuffer.put(foredata);

fwrite(data+num, 1, len, pf );

fwrite(start_code, 1, 4, pf );

num = num + len;

}

}

}

}

The video analysis.

1.ADTS是个啥

ADTS全称是(Audio Data Transport Stream),是AAC的一种十分常见的传输格式。

记得第一次做demux的时候,把AAC音频的ES流从FLV封装格式中抽出来送给硬件解码器时,不能播;保存到本地用pc的播放器播时,我靠也不能播。当时崩溃了,后来通过查找资料才知道。一般的AAC解码器都需要把AAC的ES流打包成ADTS的格式,一般是在AAC ES流前添加7个字节的ADTS header。也就是说你可以吧ADTS这个头看作是AAC的frameheader。

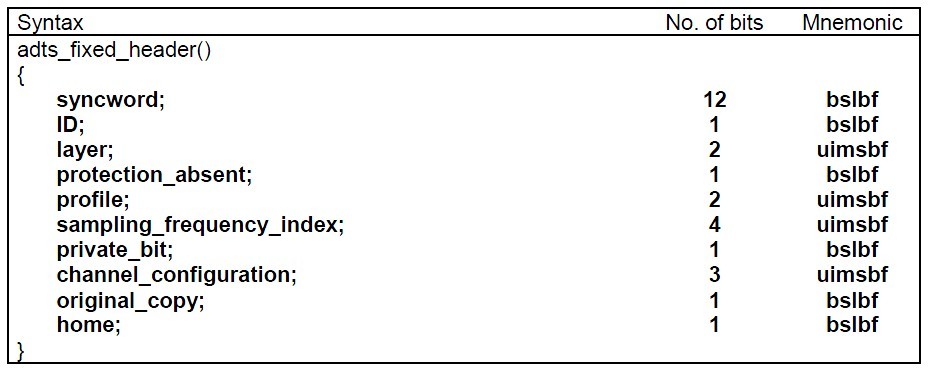

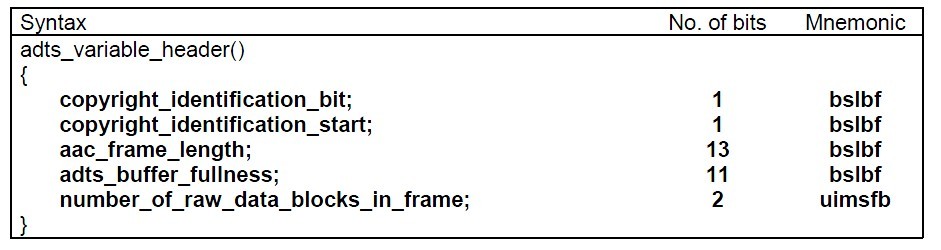

2.ADTS内容及结构

ADTS 头中相对有用的信息 采样率、声道数、帧长度。想想也是,我要是解码器的话,你给我一堆得AAC音频ES流我也解不出来。每一个带ADTS头信息的AAC流会清晰的告送解码器他需要的这些信息。

一般情况下ADTS的头信息都是7个字节,分为2部分:

adts_fixed_header();

adts_variable_header();

syncword :同步头 总是0xFFF, all bits must be 1,代表着一个ADTS帧的开始

ID:MPEG Version: 0 for MPEG-4, 1 for MPEG-2

Layer:always: '00'

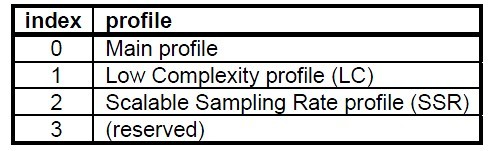

profile:表示使用哪个级别的AAC,有些芯片只支持AAC LC 。在MPEG-2 AAC中定义了3种:

sampling_frequency_index:表示使用的采样率下标,通过这个下标在 Sampling Frequencies[ ]数组中查找得知采样率的值。

There are 13 supported frequencies:

- 0: 96000 Hz

- 1: 88200 Hz

- 2: 64000 Hz

- 3: 48000 Hz

- 4: 44100 Hz

- 5: 32000 Hz

- 6: 24000 Hz

- 7: 22050 Hz

- 8: 16000 Hz

- 9: 12000 Hz

- 10: 11025 Hz

- 11: 8000 Hz

- 12: 7350 Hz

- 13: Reserved

- 14: Reserved

- 15: frequency is written explictly

- 0: Defined in AOT Specifc Config

- 1: 1 channel: front-center

- 2: 2 channels: front-left, front-right

- 3: 3 channels: front-center, front-left, front-right

- 4: 4 channels: front-center, front-left, front-right, back-center

- 5: 5 channels: front-center, front-left, front-right, back-left, back-right

- 6: 6 channels: front-center, front-left, front-right, back-left, back-right, LFE-channel

- 7: 8 channels: front-center, front-left, front-right, side-left, side-right, back-left, back-right, LFE-channel

- 8-15: Reserved

frame_length : 一个ADTS帧的长度包括ADTS头和AAC原始流.

adts_buffer_fullness:0x7FF 说明是码率可变的码流

3.将AAC打包成ADTS格式

如果是通过嵌入式高清解码芯片做产品的话,一般情况的解码工作都是由硬件来完成的。所以大部分的工作是把AAC原始流打包成ADTS的格式,然后丢给硬件就行了。

通过对ADTS格式的了解,很容易就能把AAC打包成ADTS。我们只需得到封装格式里面关于音频采样率、声道数、元数据长度、aac格式类型等信息。然后在每个AAC原始流前面加上个ADTS头就OK了。

贴上ffmpeg中添加ADTS头的代码,就可以很清晰的了解ADTS头的结构:

- int ff_adts_write_frame_header(ADTSContext *ctx,

- uint8_t *buf, int size, int pce_size)

- {

- PutBitContext pb;

- init_put_bits(&pb, buf, ADTS_HEADER_SIZE);

- /* adts_fixed_header */

- put_bits(&pb, 12, 0xfff); /* syncword */

- put_bits(&pb, 1, 0); /* ID */

- put_bits(&pb, 2, 0); /* layer */

- put_bits(&pb, 1, 1); /* protection_absent */

- put_bits(&pb, 2, ctx->objecttype); /* profile_objecttype */

- put_bits(&pb, 4, ctx->sample_rate_index);

- put_bits(&pb, 1, 0); /* private_bit */

- put_bits(&pb, 3, ctx->channel_conf); /* channel_configuration */

- put_bits(&pb, 1, 0); /* original_copy */

- put_bits(&pb, 1, 0); /* home */

- /* adts_variable_header */

- put_bits(&pb, 1, 0); /* copyright_identification_bit */

- put_bits(&pb, 1, 0); /* copyright_identification_start */

- put_bits(&pb, 13, ADTS_HEADER_SIZE + size + pce_size); /* aac_frame_length */

- put_bits(&pb, 11, 0x7ff); /* adts_buffer_fullness */

- put_bits(&pb, 2, 0); /* number_of_raw_data_blocks_in_frame */

- flush_put_bits(&pb);

- return 0;

- }

如何生成 AAC ADTS 基本流与 Android MediaCodec

想做什么:使用 Android 的 MediaCodec 将编码到原始的 AAC 文件的原始 PCM 音频采样。

的问题:当我使用 FFMPEG 生成原始的 AAC 文件打包到 M4A 容器,FFMPEG 抱怨缺少的编解码器参数文件中。

详细信息:

由于生成的输出 AAC 文件的音频编码器为找不到任何 MediaCodec 的示例代码,我试着修改到音频编码器的视频编码器。这里的原始代码是: source_code

我配置的音频编码器,像这样:

mEncoderFormat = MediaFormat.createAudioFormat("audio/mp4a-latm", (int)mAudioSampleRate, 2); // redundant? mEncoderFormat.setString(MediaFormat.KEY_MIME, "audio/mp4a-latm"); mEncoderFormat.setInteger(MediaFormat.KEY_AAC_PROFILE, MediaCodecInfo.CodecProfileLevel.AACObjectELD); mEncoderFormat.setInteger(MediaFormat.KEY_SAMPLE_RATE, kSampleRates); mEncoderFormat.setInteger(MediaFormat.KEY_BIT_RATE, kBitRates); mEncoderFormat.setInteger(MediaFormat.KEY_CHANNEL_COUNT, 2); testEncoderWithFormat("audio/mp4a-latm", mEncoderFormat); try { codec.configure( mEncoderFormat, null /* surface */, null /* crypto */, MediaCodec.CONFIGURE_FLAG_ENCODE); } catch (IllegalStateException e) { Log.e(TAG, "codec '" + componentName + "' failed configuration."); return; } Log.d(TAG, " testEncoder configured with format = " + format);然后我喂编码器与价值的 PCM 样品每帧 10ms年。编码器需要每个帧,将生成的位流,一个框架和 FileOutputStream 位流写入。循环继续直到输入文件的末尾。

代码运行到终点。我做 '亚行拉' 生成的 AAC 文件从设备获取到我的 PC,并使用 FFMPEG 来阅读它。下面是命令和 FFMPEG 吐出的错误:

$ ffmpeg -f aac -i BlessedNoColor_nexus7_api18.aacffmpeg version N-45739-g04bf2e7 Copyright (c) 2000-2012 the FFmpeg developers built on Oct 20 2012 00:20:36 with gcc 4.7.2 (GCC) configuration: --enable-gpl --enable-version3 --disable-pthreads --enable-runtime-cpudetect --enable-avisynth --enable-bzlib --enable-frei0r --enable-libass --enable-libopencore-amrnb --enable-libopencore-amrwb --enable-libfreetype --enable-libgsm --enable-libmp3lame --enable-libnut --enable-libopenjpeg --enable-libopus --enable-librtmp --enable-libschroedinger --enable-libspeex --enable-libtheora --enable-libutvideo --enable-libvo-aacenc --enable-libvo-amrwbenc --enable-libvorbis --enable-libvpx --enable-libx264 --enable-libxavs --enable-libxvid --enable-zlib libavutil 51. 76.100 / 51. 76.100 libavcodec 54. 67.100 / 54. 67.100 libavformat 54. 33.100 / 54. 33.100 libavdevice 54. 3.100 / 54. 3.100 libavfilter 3. 19.103 / 3. 19.103 libswscale 2. 1.101 / 2. 1.101 libswresample 0. 16.100 / 0. 16.100 libpostproc 52. 1.100 / 52. 1.100[aac @ 00000000002efae0] channel element 2.0 is not allocated[aac @ 00000000003cf520] decoding for stream 0 failed[aac @ 00000000003cf520] Could not find codec parameters for stream 0 (Audio: aac, 0 channels, s16): unspecified sample rateConsider increasing the value for the 'analyzeduration' and 'probesize' options[aac @ 00000000003cf520] Estimating duration from bitrate, this may be inaccurateBlessedNoColor_nexus7_api18.aac: could not find codec parameters我的问题:

- 我已经在调用 codec.start() 之前配置编码器。所生成的 AAC 文件为什么缺少的编解码器参数?

- 在原始的视频编解码器示例中,参数"惩教署-0"从编码器传递到解码器,但不是会写到码流文件中明确。我需要显式地将它们写入到 AAC 文件吗?

- 我把输入的 PCM 样本分为每个框架,不一定会产生一个完整的输出数据包 10ms年。为每个输入的帧,我只是写不管编码器输出到文件中。那是令人担忧吗?

任何可以帮助将深为感激。如果有一个示例项目,不会想在这里做什么,那就再好不过。如果我的源代码可以帮你帮助我,我就把它寄。我需要做一些清理。谢谢 !

编辑: 从"初级 AAC 文件由 MediaCodec 缺少的编解码器的参数生成"更改标题为"如何生成 AAC ADTS 基本流与 Android MediaCodec"

解决方法 1:

我最后生成的 android 系统的设备和 Windows 主机计算机上可播放的 AAC 文件。我张贴我的解决方案在这里,希望它能帮助其他人。

首先,Android MediaCodec 编码器生成基本的 AAC 流我先前假设不是准确的。MediaCodec 编码器生成的原始的 AAC 流。这就是为什么无法播放文件。原始的 AAC 流需要转换成一个可播放格式,例如ADTS流。我已更改以反映我的新认识这篇文章的标题。有另一篇文章,问了一个类似的问题,并有一个优秀的答案。然而,一个新手未必了解那里的简要说明。我相当没我阅读这篇文章的第一次。

所以,为了生成 AAC 码流可以发挥的一个媒体播放器,我开始给出的 EncoderTest 示例由法登在他第一次的意见,但修改的原代码添加 ADTS 头每输出帧 (访问单位),并将结果流写入到一个文件中 (更换线路通过 267 248 的原代码与下面的代码段):

if (index >= 0) { int outBitsSize = info.size; int outPacketSize = outBitsSize + 7; // 7 is ADTS size ByteBuffer outBuf = codecOutputBuffers[index]; outBuf.position(info.offset); outBuf.limit(info.offset + outBitsSize); try { byte[] data = new byte[outPacketSize]; //space for ADTS header included addADTStoPacket(data, outPacketSize); outBuf.get(data, 7, outBitsSize); outBuf.position(info.offset); mFileStream.write(data, 0, outPacketSize); //open FileOutputStream beforehand } catch (IOException e) { Log.e(TAG, "failed writing bitstream data to file"); e.printStackTrace(); } numBytesDequeued += info.size; outBuf.clear(); codec.releaseOutputBuffer(index, false /* render */); Log.d(TAG, " dequeued " + outBitsSize + " bytes of output data."); Log.d(TAG, " wrote " + outPacketSize + " bytes into output file.");}else if (index == MediaCodec.INFO_OUTPUT_BUFFERS_CHANGED) {}else if (index == MediaCodec.INFO_OUTPUT_FORMAT_CHANGED) { codecOutputBuffers = codec.getOutputBuffers();}在循环外我定义函数 addADTStoPacket 像这样:

/** * Add ADTS header at the beginning of each and every AAC packet. * This is needed as MediaCodec encoder generates a packet of raw * AAC data. * * Note the packetLen must count in the ADTS header itself. **/private void addADTStoPacket(byte[] packet, int packetLen) { int profile = 2; //AAC LC //39=MediaCodecInfo.CodecProfileLevel.AACObjectELD; int freqIdx = 4; //44.1KHz int chanCfg = 2; //CPE // fill in ADTS data packet[0] = (byte)0xFF; packet[1] = (byte)0xF9; packet[2] = (byte)(((profile-1)<<6) + (freqIdx<<2) +(chanCfg>>2)); packet[3] = (byte)(((chanCfg&3)<<6) + (packetLen>>11)); packet[4] = (byte)((packetLen&0x7FF) >> 3); packet[5] = (byte)(((packetLen&7)<<5) + 0x1F); packet[6] = (byte)0xFC;}我还添加了代码来控制如何停止生成 AAC ADTS 流,但这是应用程序特定的所以我在这里不会详细说明。所有这些变化,生成的 AAC 文件可以在 Android 设备上,在我 Windows PC 上,演奏和 ffmpeg 是和他们一起快乐。

RTMP直播到FMS中的AAC音频直播

本文引用了下面几个网友的文章:

http://sun3eyes.blog.163.com/blog/#m=0&t=3&c=rtmp

http://sun3eyes.blog.163.com/blog/static/1070797922012913337667/

http://sun3eyes.blog.163.com/blog/static/107079792201291112451996/

http://blog.csdn.net/helunlixing/article/details/7417778

直播的视频用H264,音频用AAC,从FAAC里面压缩出来的一帧音频数据,要经过简单处理才能打包用RTMP协议发送到FMS上,包括保存成FLV文件,都要稍微处理一下,主要是把AAC的帧头去掉,并提取出相应的信息。

1024字节的G.711A数据,AAC一般也就300多个字节。

可以把FAAC压缩出来的帧直接保存成AAC文件,用windows7自带的播放器可以播放的,方便测试。

AAC的帧头一般7个字节,或者包含CRC校验的话9个字节,这里面包括了声音的相关参数。

结构如下:

Structure

AAAAAAAA AAAABCCD EEFFFFGH HHIJKLMM MMMMMMMM MMMOOOOO OOOOOOPP (QQQQQQQQ QQQQQQQQ)

Header consists of 7 or 9 bytes (without or with CRC).

http://wiki.multimedia.cx/index.php?title=ADTS

其中最重要的就是E,F,H。

E就是类型了

1: AAC Main

2: AAC LC (Low Complexity)

3: AAC SSR (Scalable Sample Rate)

4: AAC LTP (Long Term Prediction)

F就是采样频率

0: 96000 Hz

H就是声道

1: 1 channel: front-center

有了这三个参数,就可以发送音频的第一帧了,然后后面的帧,把包头的7个字节去掉?,打包到RTMP协议发送就可以了。

http://wiki.multimedia.cx/index.php?title=MPEG-4_Audio#Audio_Object_Types

当然发送的时候要打上RTMP的包头,数据部分用 AF 00 代替AAC的包头。长度再计算一下。时间戳用采样的时间也可以,自己另算也可以。

第一个音频包那就是AAC header.

如:af 00 13 90。包长4个字节,解释如下,

1)第一个字节af,a就是10代表的意思是AAC,

Format of SoundData. The following values are defined:

0 = Linear PCM, platform endian

1 = ADPCM

2 = MP3

3 = Linear PCM, little endian

4 = Nellymoser 16 kHz mono

5 = Nellymoser 8 kHz mono

6 = Nellymoser

7 = G.711 A-law logarithmic PCM

8 = G.711 mu-law logarithmic PCM

9 = reserved

10 = AAC

11 = Speex

14 = MP3 8 kHz

15 = Device-specific sound

Formats 7, 8, 14, and 15 are reserved.

AAC is supported in Flash Player 9,0,115,0 and higher.

Speex is supported in Flash Player 10 and higher.

2)第一个字节中的后四位f代表如下

前2个bit的含义 抽样频率,这里是二进制11,代表44kHZ

Sampling rate. The following values are defined:

0 = 5.5 kHz

1 = 11 kHz

2 = 22 kHz

3 = 44 kHz

第3个bit,代表 音频用16位的

Size of each audio sample. This parameter only pertains to

uncompressed formats. Compressed formats always decode

to 16 bits internally.

0 = 8-bit samples

1 = 16-bit samples

第4个bit代表声道

Mono or stereo sound

0 = Mono sound

1 = Stereo sound

3)第2个字节

AACPacketType,这个字段来表示AACAUDIODATA的类型:0 = AAC sequence header,1 = AAC raw。第一个音频包用0,后面的都用1

4)第3,4个字节内容AudioSpecificConfig如下

AAC sequence header存放的是AudioSpecificConfig结构,该结构则在“ISO-14496-3 Audio”中描述。AudioSpecificConfig结构的描述非常复杂,这里我做一下简化,事先设定要将要编码的音频格式,其中,选择"AAC-LC"为音频编码,音频采样率为44100,于是AudioSpecificConfig简化为下表:

0x13 0x90(1001110010000) 表示 ObjectProfile=2, AAC-LC,SamplingFrequencyIndex=7,ChannelConfiguration=声道2

AudioSpecificConfig,即为ObjectProfile,SamplingFrequencyIndex,ChannelConfiguration,TFSpecificConfig。

其中,ObjectProfile (AAC main ~1, AAC lc ~2, AAC ssr ~3);

SamplingFrequencyIndex (0 ~ 96000, 1~88200, 2~64000, 3~48000, 4~44100, 5~32000, 6~24000, 7~ 22050, 8~16000...),通常aac固定选中44100,即应该对应为4,但是试验结果表明,当音频采样率小于等于44100时,应该选择3,而当音频采样率为48000时,应该选择2;

ChannelConfiguration对应的是音频的频道数目。单声道对应1,双声道对应2,依次类推。

TFSpecificConfig的说明见标准14496-3中(1.2 T/F Audio Specific Configuration)的讲解,这里恒定的设置为0;

索引值如下含义:

There are 13 supported frequencies:

- 0: 96000 Hz

- 1: 88200 Hz

- 2: 64000 Hz

- 3: 48000 Hz

- 4: 44100 Hz

- 5: 32000 Hz

- 6: 24000 Hz

- 7: 22050 Hz

- 8: 16000 Hz

- 9: 12000 Hz

- 10: 11025 Hz

- 11: 8000 Hz

- 12: 7350 Hz

- 13: Reserved

- 14: Reserved

- 15: frequency is written explictly

channel_configuration: 表示声道数

- 0: Defined in AOT Specifc Config

- 1: 1 channel: front-center

- 2: 2 channels: front-left, front-right

- 3: 3 channels: front-center, front-left, front-right

- 4: 4 channels: front-center, front-left, front-right, back-center

- 5: 5 channels: front-center, front-left, front-right, back-left, back-right

- 6: 6 channels: front-center, front-left, front-right, back-left, back-right, LFE-channel

- 7: 8 channels: front-center, front-left, front-right, side-left, side-right, back-left, back-right, LFE-channel

- 8-15: Reserved

后面的视频包都是AF 01 + 去除7个字节头的音频AAC数据

- 关于librtmp接收数据

- 关于librtmp接收数据(接收网络电视的数据流)

- 用librtmp 接收数据

- RTMPdump(libRTMP) 源代码分析 9: 接收消息(Message)(接收视音频数据)

- RTMPdump(libRTMP) 源代码分析 9: 接收消息(Message)(接收视音频数据)

- RTMPdump(libRTMP) 源代码分析 9: 接收消息(Message)(接收视音频数据)

- RTMPdump(libRTMP) 源代码分析 9: 接收消息(Message)(接收视音频数据)

- 关于GPRS的数据接收

- LibRTMP源代码分析9:接收消息

- 使用librtmp推送AVC数据

- [C#]关于TcpClient编程数据接收问题

- 关于异步socket接收数据的困惑

- 关于wince串口接收数据异常

- 关于蓝牙接收数据的解决方案

- 关于post数据服务器端接收不全

- LibRTMP源代码分析9:接收消息(Receive Message)

- 使用librtmp接收直播流和点播流并保存

- 使用librtmp接收直播流和点播流并保存

- 蓝牙驱动

- iOS开发-控制状态栏

- 对一阶二阶低通数字滤波器的理解(基于匿名六轴),感谢社区

- SAT阅读考试备考方法详解

- 风险控制技巧

- 关于librtmp接收数据

- SpringMVC拦截器实现登录控制

- 对四元数解算姿态的理解(基于匿名六轴),感谢社区

- 教大家一种推理方法实现破解QQ空间访问权限,本人原创

- Android应用打包安装过程详解

- 对串级PID和单级PID的理解(基于匿名六轴),感谢社区

- jQuery插件开发

- NSLocalizedString和NSLocalizedStringFromTable区别

- GRE备考全攻略:三个月阶段性备考规划