Expectation Maximization

来源:互联网 发布:电气cad制图软件 编辑:程序博客网 时间:2024/06/10 19:59

阅读http://blog.pluskid.org/?p=81文章中的一些知识整理:

=====================================================================

Andrew Ng 关于EM有两个不错的课件

http://www.stanford.edu/class/cs229/notes/cs229-notes7b.pdf Mixtures of Gaussians and the EM algorithm

http://www.stanford.edu/class/cs229/notes/cs229-notes8.pdf The EM algorithm

=====================================================================

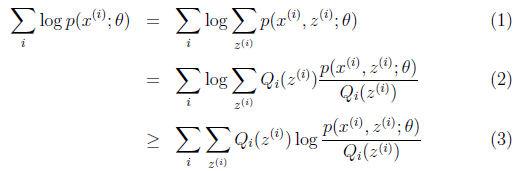

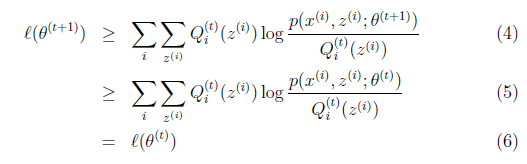

EM算法前面公式推导就是利用Jensen不等式缩放期望。建立下界然后优化下界。

.

.

.

.

![]() .

.

.

.

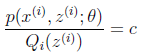

在给定![]() 时

时 .

.

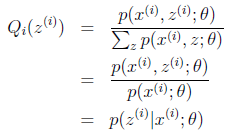

固定![]() ,并将

,并将![]() 视作变量,对上面的

视作变量,对上面的![]() 求导后,得到

求导后,得到![]() .

.

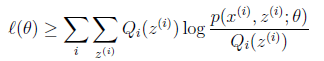

而对于所有的![]() 和

和![]() 都成立

都成立

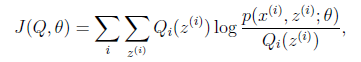

如果我们定义 从前面的推导中我们知道

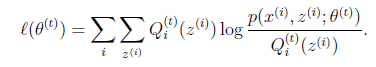

从前面的推导中我们知道![]() ,EM可以看作是J的坐标上升法,E步固定

,EM可以看作是J的坐标上升法,E步固定![]() ,优化

,优化![]() ,M步固定

,M步固定![]() 优化

优化![]() 。

。

图解:

图中的直线式迭代优化的路径,可以看到每一步都会向最优值前进一步,而且前进路线是平行于坐标轴的,因为每一步只优化一个变量。犹如在x-y坐标系中找一个曲线的极值,然而曲线函数不能直接求导,因此什么梯度下降方法就不适用了。但固定一个变量后,另外一个可以通过求导得到,因此可以使用坐标上升法,一次固定一个变量,对另外的求极值,最后逐步逼近极值。对应到EM上,E步:固定θ,优化Q;M步:固定Q,优化θ;交替将极值推向最大。

高斯的EM应用见,http://blog.csdn.net/abcjennifer/article/details/8198352

====================================================================

- Expectation Maximization

- Expectation Maximization

- expectation maximization

- Expectation Maximization(EM) algorithm

- Clustering (番外篇): Expectation Maximization

- EM算法:Expectation-Maximization

- EM(Expectation-Maximization)算法

- EM算法(Expectation Maximization)

- EM, Expectation maximization

- EM算法(Expectation Maximization)

- EM, Expectation maximization

- EM (Expectation-Maximization) Algorithm

- Expectation-Maximization(EM) 算法

- EM算法(Expectation Maximization)

- EM算法-expectation-maximization

- EM算法--expectation maximization

- Expectation Maximization(EM)算法

- Expectation–Maximization Algorithm

- web项目访问首页问题

- 云计算 基础

- 使用IOCP需要注意的一些问题~~(不断补充)

- zeromq高水位

- MATLAB 图像处理小实践

- Expectation Maximization

- 静态库没有更新

- 2014年7月华为校招机试真题1

- 如果本地化自己的iOS App(iOS8 & xcode6)

- 【ThinkPHP】ThinkPHP下载、部署,Helloworld,消除难看的index.php

- 输出链表时倒数第K个结点

- C++一些语法总结

- nyoj 20 吝啬的国度(邻接表+bfs)

- 文章链接