CNN 学习小结

来源:互联网 发布:大众汽车斯柯达软件 编辑:程序博客网 时间:2024/06/05 19:21

- 神经网路主要算法简介

- CNN

- RNN

- DNN

- CNN

- CNN两大核心

- 局部感知野

- 参数共享

- 多卷积核池化Down-Pooling

- CNN两大核心

神经网路主要算法简介

CNN

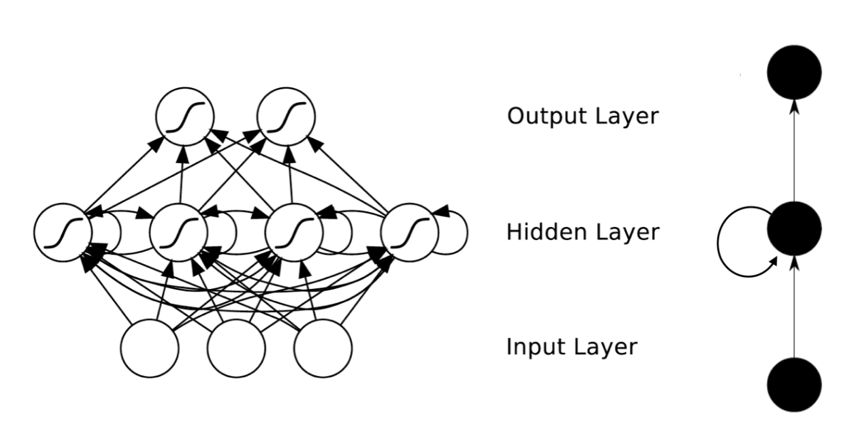

Convolutional Neural Network 卷积神经网路 空间上深度的神经网路 多用于图像分类、语音识别等。RNN

Recurrent Neural Networks 循环神经网路时间上深度的神经网络隐含层增加自连边跟互连边,隐含层相互连接。回归型网络,用于序列数据,并且有了一定的记忆效应,辅之以lstm。

DNN

Deep Neural Networks 深度神经网络全连接神经元结构,广义上包括 CNN、DNN。CNN

CNN两大核心

保证CNN计算效率的两大神器,减少参数数目,共享神经元特征提取权重。局部感知野

一般认为人对外界的认知是从局部到全局的,而图像的空间联系也是局部的像素联系较为紧密,而距离较远的像素相关性则较弱。因而,每个神经元其实没有必要对全局图像进行感知,只需要对局部进行感知,然后在更高层将局部的信息综合起来就得到了全局的信息。)参数共享

不同的神经元,通过通过使用相同的参数做特征提取,大大减少了特征提取的工作量。 图像的一部分的统计特性与其他部分是一样的。这也意味着我们在这一部分学习的特征也能用在另一部分上,所以对于这个图像上的所有位置,我们都能使用同样的学习特征。多卷积核&池化(Down-Pooling)

为了学习到图像的更多的特征,一般我们会用多个不同的卷积核对图像进行卷积操作,最后再将学习到的特征通过例如 softmax 分类器等做分类处理。 但是一般卷积操作过后,每个卷积核生成的卷积特征矩阵仍然是很大的,会带来巨大的据算量。所以我们通过池化方式,对特征矩阵进行降维操作。 池化的基本原理就是,通过对图像的局部进行聚合操作,如求最大值或者平均值的方法。 池化的优点,不仅会使分类计算量大大减少,而且还会避免过拟的发生。参考文章:http://blog.csdn.net/stdcoutzyx/article/details/41596663

0 0

- CNN 学习小结

- Mask R-CNN小结

- CNN学习

- CNN学习

- CNN模型小结(1)

- CNN学习笔记

- CNN的学习

- 深度学习-CNN入门

- CNN的学习资料

- CNN学习笔记

- CNN 学习 待续

- CNN学习记录

- CNN学习笔记

- R-CNN学习笔记

- R-CNN学习笔记

- CNN学习(一)

- cnn 学习笔记 2

- cnn 学习笔记 3

- IOS开发语言OC的基本语法以及结构

- listview 禁止item点击

- LeetCode 24. Swap Nodes in Pairs

- [TIRTOS--Introduction]TI RTOS Kernel

- Django提示django-admin.py: command not found

- CNN 学习小结

- c语言指针--动态内存分配

- ZOJ 3705 Applications

- 个人笔记

- 欢迎使用CSDN-markdown编辑器

- mac下安装 Django

- mac下建立Django项目(通过termina…

- Django项目结构

- MySQL5.6 服务与登陆