ubuntu14.4(虚拟机)搭建hadoop 2.7.2

来源:互联网 发布:java工程师岗位管理 编辑:程序博客网 时间:2024/06/03 21:29

64P[[@_[9XD}2~H4O.png)

64P[[@_[9XD}2~H4O.png)

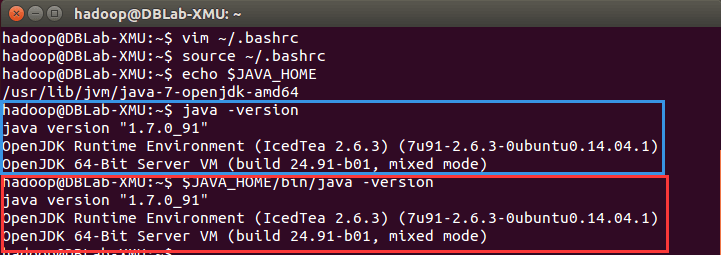

- 接下来这个是配置环境变量

- vim~/.bashrc

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

export HADOOP_INSTALL=/usr/local/hadoop

export PATH=$PATH:$HADOOP_INSTALL/bin

export PATH=$PATH:$HADOOP_INSTALL/sbin

export HADOOP_MAPRED_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_HOME=$HADOOP_INSTALL

export HADOOP_HDFS_HOME=$HADOOP_INSTALL

export YARN_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

#HADOOP VARIABLES END

- <property>

- <name>hadoop.tmp.dir</name>

- <value>file:/usr/local/hadoop/tmp</value>

- <description>Abase for other temporary directories.</description>

- </property>

- <property>

- <name>fs.defaultFS</name>

- <value>hdfs://localhost:9000</value>

- </property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

关于mapred-site.xml:<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

关于 hdfs-site.xml :

先做以下工作:

然后一样 加上:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hdfs/data</value>

</property>

关于 hadoop-env.sh

把export JAVA_HOME 改成 export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

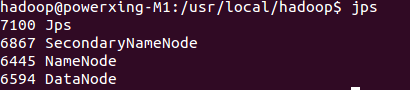

./bin/hdfs namenode -format

- ubuntu14.4(虚拟机)搭建hadoop 2.7.2

- Hadoop-2.7.2高可用集群搭建(Ubuntu14.04)

- ubuntu14.04 i686搭建hadoop-2.5.2

- ubuntu14上hadoop的搭建(1)

- Hadoop集群搭建(hadoop+zookeeper+hbase)Ubuntu14.04

- ubuntu14.04搭建hadoop集群

- Hadoop环境搭建(一、创建虚拟机)

- 虚拟机搭建hadoop集群

- 虚拟机中搭建hadoop

- ubuntu14.04的hadoop环境搭建(全分布模式)

- Hadoop实战(2)_虚拟机搭建Hadoop的全分布模式

- java 虚拟机 hadoop 环境搭建 (本次搭建全过程)

- ubuntu14.04.1虚拟机搭建git服务器

- VMware12使用三台虚拟机Ubuntu16.04系统搭建hadoop-2.7.1+hbase-1.2.4(完全分布式)

- UBUNTU14.04 hadoop搭建的注意事项

- ubuntu14.01.1 搭建eclipse Hadoop开发环境

- ubuntu14.04搭建hadoop伪集群环境

- Hadoop集群环境搭建(虚拟机)

- 设计模式学习--(1)

- iOS view controller 生命周期

- pandas 基础

- Java Servlet完全教程

- spring中注入日期方案

- ubuntu14.4(虚拟机)搭建hadoop 2.7.2

- MySQL Replication 常用架构

- 程序猿相关笑话

- Matlab图像边缘检测Roberts\Sobel\Prewitt\Canny算子

- Python 中的 property 属性

- PHP获取一天起始时间戳,结束时间戳

- A simple explanation of the Lasso and Least Angle Regression

- iOS学习笔记34-加速计和陀螺仪

- eclipse再见,android studio 新手入门教程(二)项目的导入