logistic regress and softmax

来源:互联网 发布:fresh玫瑰化妆水知乎 编辑:程序博客网 时间:2024/06/07 00:22

1、逻辑回归为softmax的一个特例:二分类

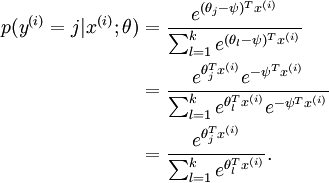

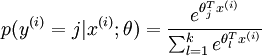

2、softmax由于属于 j 类概率可写成如下公式:

回归的参数向量减去一个常数向量,会有什么结果:

没有变化!这说明如果某一个向量是代价函数的极小值点,那么这个向量在减去一个任意的常数向量也是极小值点,这是因为 softmax 模型被过度参数化了。

为了解决softmax模型被过度参数化的问题,加入权重衰减因子,

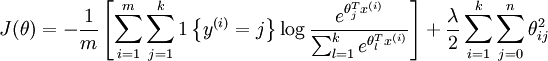

加入权重衰减后的代价函数是:

等号右边第一项是训练样本 label 对应的输出节点上的概率的负对数,第二项是 weight decay ,可以使用梯度下降法和 L-BFGS 等算法可以保证收敛到全局最优解。

1、公式如何得来的?

2、负对数的意义何在?

3、weight decay 是个什么鬼东西?

参考文章:

http://www.cnblogs.com/daniel-D/archive/2013/05/30/3109276.html

http://blog.csdn.net/zouxy09/article/details/20319673

http://blog.csdn.net/pi9nc/article/details/19336629

http://blog.csdn.net/rtygbwwwerr/article/details/42147783

0 0

- logistic regress and softmax

- Softmax loss, softmax, multinominal and logistic loss

- Softmax Regression and Logistic Regression

- Sigmoid/Logistic function and softmax without overflow

- Logistic and Softmax Regression (逻辑回归和Softmax回归)

- Logistic and Softmax Regression (逻辑回归和Softmax回归)

- Logistic & softmax

- Logistic regression ,Softmax regression and Newton's method

- Logistic Regression & softmax

- softmax 与 logistic Regression

- python:logistic,softmax函数

- softmax logistic loss详解

- 机器学习笔记(十)——Logistic Function AND Softmax Function

- logistic和softmax原理、联系

- logistic回归和softmax回归

- Softmax回归与Logistic回归

- logistic函数和softmax函数

- logistic函数和softmax函数

- ssh 免密码登录

- XML解析

- Android事件分发机制------------>验证+理解

- HDU 5127 Dogs' Candies

- 台湾印象: 平民之港

- logistic regress and softmax

- 面试:数组:数组配对

- IMF传奇行动第86课:Spark Streaming第五课:Spark Streaming数据源Flume实际案例分享

- [A* K短路 || 可持久化堆] POJ 2449 Remmarguts' Date

- Matlab——filter函数和butter函数

- BLE 读取characteristic时,为什么没有 'BLE_GATTS_EVT_READ' ?

- 循环中的闭包

- 台湾印象: 国境以南

- 设计模式总结