最小二乘法

来源:互联网 发布:java socket 发送 编辑:程序博客网 时间:2024/06/02 00:11

概念

最小二乘法多项式曲线拟合,根据给定的m个点,并不要求这条曲线精确地经过这些点,而是曲线y=f(x)的近似曲线y= φ(x)。

原理

[原理部分由个人根据互联网上的资料进行总结,希望对大家能有用]给定数据点pi(xi,yi),其中i=1,2,…,m。求近似曲线y= φ(x)。并且使得近似曲线与y=f(x)的偏差最小。近似曲线在点pi处的偏差δi= φ(xi)-y,i=1,2,...,m。

常见的曲线拟合方法:

1.使偏差绝对值之和最小

![]()

2.使偏差绝对值最大的最小

3.使偏差平方和最小

![]()

按偏差平方和最小的原则选取拟合曲线,并且采取二项式方程为拟合曲线的方法,称为最小二乘法。

推导过程:

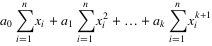

1. 设拟合多项式为:

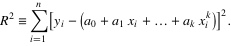

2. 各点到这条曲线的距离之和,即偏差平方和如下:

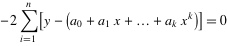

3. 为了求得符合条件的a值,对等式右边求ai偏导数,因而我们得到了:

.......

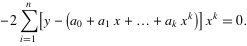

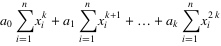

4. 将等式左边进行一下化简,然后应该可以得到下面的等式:

.......

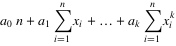

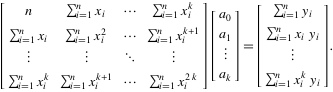

5. 把这些等式表示成矩阵的形式,就可以得到下面的矩阵:

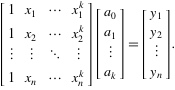

6. 将这个范德蒙得矩阵化简后可得到:

7. 也就是说X*A=Y,那么A = (X'*X)-1*X'*Y,便得到了系数矩阵A,同时,我们也就得到了拟合曲线。

实现

运行前提:

- Python运行环境与编辑环境;

- Matplotlib.pyplot图形库,可用于快速绘制2D图表,与matlab中的plot命令类似,而且用法也基本相同。

代码:

- # coding=utf-8

- '''''

- 作者:Jairus Chan

- 程序:多项式曲线拟合算法

- '''

- import matplotlib.pyplot as plt

- import math

- import numpy

- import random

- fig = plt.figure()

- ax = fig.add_subplot(111)

- #阶数为9阶

- order=9

- #生成曲线上的各个点

- x = numpy.arange(-1,1,0.02)

- y = [((a*a-1)*(a*a-1)*(a*a-1)+0.5)*numpy.sin(a*2) for a in x]

- #ax.plot(x,y,color='r',linestyle='-',marker='')

- #,label="(a*a-1)*(a*a-1)*(a*a-1)+0.5"

- #生成的曲线上的各个点偏移一下,并放入到xa,ya中去

- i=0

- xa=[]

- ya=[]

- for xx in x:

- yy=y[i]

- d=float(random.randint(60,140))/100

- #ax.plot([xx*d],[yy*d],color='m',linestyle='',marker='.')

- i+=1

- xa.append(xx*d)

- ya.append(yy*d)

- '''''for i in range(0,5):

- xx=float(random.randint(-100,100))/100

- yy=float(random.randint(-60,60))/100

- xa.append(xx)

- ya.append(yy)'''

- ax.plot(xa,ya,color='m',linestyle='',marker='.')

- #进行曲线拟合

- matA=[]

- for i in range(0,order+1):

- matA1=[]

- for j in range(0,order+1):

- tx=0.0

- for k in range(0,len(xa)):

- dx=1.0

- for l in range(0,j+i):

- dx=dx*xa[k]

- tx+=dx

- matA1.append(tx)

- matA.append(matA1)

- #print(len(xa))

- #print(matA[0][0])

- matA=numpy.array(matA)

- matB=[]

- for i in range(0,order+1):

- ty=0.0

- for k in range(0,len(xa)):

- dy=1.0

- for l in range(0,i):

- dy=dy*xa[k]

- ty+=ya[k]*dy

- matB.append(ty)

- matB=numpy.array(matB)

- matAA=numpy.linalg.solve(matA,matB)

- #画出拟合后的曲线

- #print(matAA)

- xxa= numpy.arange(-1,1.06,0.01)

- yya=[]

- for i in range(0,len(xxa)):

- yy=0.0

- for j in range(0,order+1):

- dy=1.0

- for k in range(0,j):

- dy*=xxa[i]

- dy*=matAA[j]

- yy+=dy

- yya.append(yy)

- ax.plot(xxa,yya,color='g',linestyle='-',marker='')

- ax.legend()

- plt.show()

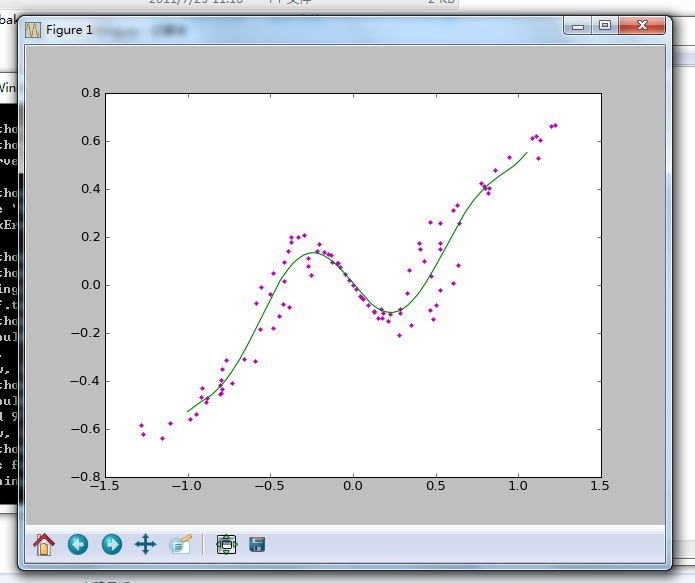

运行效果:

本博客中所有的博文都为笔者(Jairus Chan)原创。

如需转载,请标明出处:http://blog.csdn.net/JairusChan。

如果您对本文有任何的意见与建议,请联系笔者(JairusChan)。

一.背景

最小二乘法(又称最小平方法)是一种数学优化技术。它通过最小化误差的平方和寻找数据的最佳函数匹配。利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。最小二乘法还可用于曲线拟合。其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

二. 最小二乘法

,以

,以 为变量,把它们看作是Q的函数,就变成了一个求极值的问题,可以通过求导数得到。求Q对两个待估参数的偏导数(偏导数存在):

为变量,把它们看作是Q的函数,就变成了一个求极值的问题,可以通过求导数得到。求Q对两个待估参数的偏导数(偏导数存在):

这就是最小二乘法的解法,就是求得平方损失函数的极值点。

四. 最小二乘法与梯度下降法

1.本质相同:两种方法都是在给定已知数据(independent & dependent variables)的前提下对dependent variables算出出一个一般性的估值函数。然后对给定新数据的dependent variables进行估算。

2.目标相同:都是在已知数据的框架内,使得估算值与实际值的总平方差尽量更小(事实上未必一定要使用平方)

1.实现方法和结果不同:最小二乘法是直接对求导找出全局最小,是非迭代法。而梯度下降法是一种迭代法,先给定一个

,然后向

下降最快的方向调整

,在若干次迭代之后找到局部最小。梯度下降法的缺点是到最小点的时候收敛速度变慢,并且对初始点的选择极为敏感,其改进大多是在这两方面下功夫。

逻辑回归logicalistic regression 本质上仍为线性回归,为什么被单独列为一类?

其存在一个非线性的映射关系,处理的一般是二元结构的0,1问题,是线性回归的扩展,应用广泛,被单独列为一类。

线性回归的损失函数是平方函数,而逻辑回归的损失函数是对数函数。

原文:http://www.cnblogs.com/iamccme/archive/2013/05/15/3080737.html

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- 最小二乘法

- Spring3 MVC请求参数获取的几种方法

- Log篇

- 记录android第一个hello world

- Activity启动流程以及View的绘制流程

- C# 数据绑定

- 最小二乘法

- border-image-slice

- 日常开发——Android请求自定义证书的https

- Web - HTTPS

- java入门教程-3.1Java类的定义及其实例化

- HIVESQL中row_number使用

- linux 下连接mysql服务器

- iOS开发之适配IPV6更新网络处理为AFNetworking3.x, 集成以及遇到的一些问题总结。

- RecyclerView滑动停止加载图片,空闲时间加载图片