深度学习之CNN一 卷积与池化

来源:互联网 发布:isis网络恐怖主义活动 编辑:程序博客网 时间:2024/06/16 12:47

1 卷积

连续:

一维卷积:

二维卷积:

离散:

一维卷积:

二维卷积:

卷积具有交换性,即

编程实现中:

二维卷积:

这个定义就不具有交换性

上面的

2 卷积神经网络

卷积神经网络主要利用3个思想:稀疏连接、参数共享、平移不变性。

- 稀疏连接

一个神经元的感知视野是指能够影响该神经元的其他神经元。如上图中x3 的感知视野是s2,s3,s4 。深度卷经网络中,深层单元的感知视野比浅层单元的大。 - 参数共享

稀疏连接和参数共享都能显著减少参数。 - 平移不变性

参数共享会导致平移不变性。称f(x) 对g(x) 是不变的,如果f(g(x))=g(f(x)) 。例如I(x,y) 是一张图像,g(I)=I(x−1,y) ,则(g(I)∗K)=g((I∗K)) 。

池化(pooling)

池化输出的是邻近区域的概括统计量,一般是矩形区域。池化有最大池化、平均池化、滑动平均池化、

池化能使特征获得平移不变性。如果我们只关心某些特征是否存在而不是在哪里时,平移不变性就很有用了。卷积也会产生平移不变性,注意区分,卷积对输入平移是不变的,池化对特征平移是不变的。

池化能显著地减少参数,若滑动距离stride大小为

池化能解决不同规格的输入的问题。如下图池化时,将图片区域四等分,不管图片的大小。

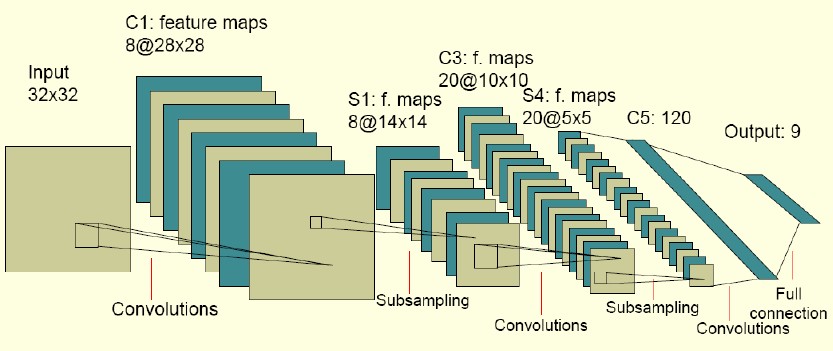

完整的CNN结构:

由上面的两幅图可以看到,为了提取不同的特征,每个卷积层都有多种卷积(通道, channel)。

一般来说,输入并不只是一张灰度图,更多的是彩图,这样输入就是一个三维张量(tensor)

其中

滑动长度为

神经网络在实现中还要注意输入的补零方式。如果不补零的话,由于卷积核的关系,特征的大小(size)总是小于输入的大小,致使整个网络的深度是有限的。

如上图所示,补零的方式有两种:

valid:也就是不补零。

same:在图像边缘补零,使得输入和输出大小相同。

- 深度学习之CNN一 卷积与池化

- 深度学习(DL)与卷积神经网络(CNN)学习随笔-05-基于Python的LeNet之CNN

- 深度学习(DL)与卷积神经网络(CNN)学习随笔-05-基于Python的LeNet之CNN

- 深度学习(DL)与卷积神经网络(CNN)学习随笔-05-基于Python的LeNet之CNN

- 深度学习(DL)与卷积神经网络(CNN)学习随笔-05-基于Python的LeNet之CNN

- [深度学习之CNN] 卷积神经网络(CNN)基础介绍

- [深度学习之CNN]CNN卷积神经网络LeNet-5

- 【深度学习】CNN-卷积概念

- 深度学习:卷积神经网络CNN

- 深度学习与自然语言处理之四:卷积神经网络模型(CNN)

- 深度学习与自然语言处理之四:卷积神经网络模型(CNN)

- 【神经网络与深度学习】卷积神经网络(CNN)

- 深度学习阅读笔记(四)之卷积网络CNN

- Deep Learning深度学习之(五)CNN卷积神经网络

- 深度学习之:CNN卷积神经网基本概念理解

- 深度学习之神经网络结构——卷积神经网络CNN

- Tensorflow深度学习之二:简单卷积神经网络CNN

- 干货 | 深度学习之卷积神经网络(CNN)的模型结构

- Eclipse快捷键

- 博客搬家~

- 智能电视、数字家庭、智慧城市的三位一体化<中层设计>

- 《App后台开发运维和架构实践》推荐序

- Docker Swarm搭建生产环境的集群

- 深度学习之CNN一 卷积与池化

- 亿级Web系统搭建:单机到分布式集群

- 第二波激情

- Python-OpenCV:sift(),SURF() 特征提取

- 柴俊理金:6月5号当周黄金,宁贵沥青操作策略

- markdown编辑器使用方法

- 遗传算法优化的BP神经网络建模

- "CVPR 2014 Tutorial Supervised Deep Learning"阅读总结

- Linux 基础重要命令