spark概述与编程模型

来源:互联网 发布:windows无法格式化 编辑:程序博客网 时间:2024/06/05 06:13

spark快的原因

1.内存计算

2.DAG

spark shell已经初始化好了SparkContext,直接用sc调用即可

lineage 血统

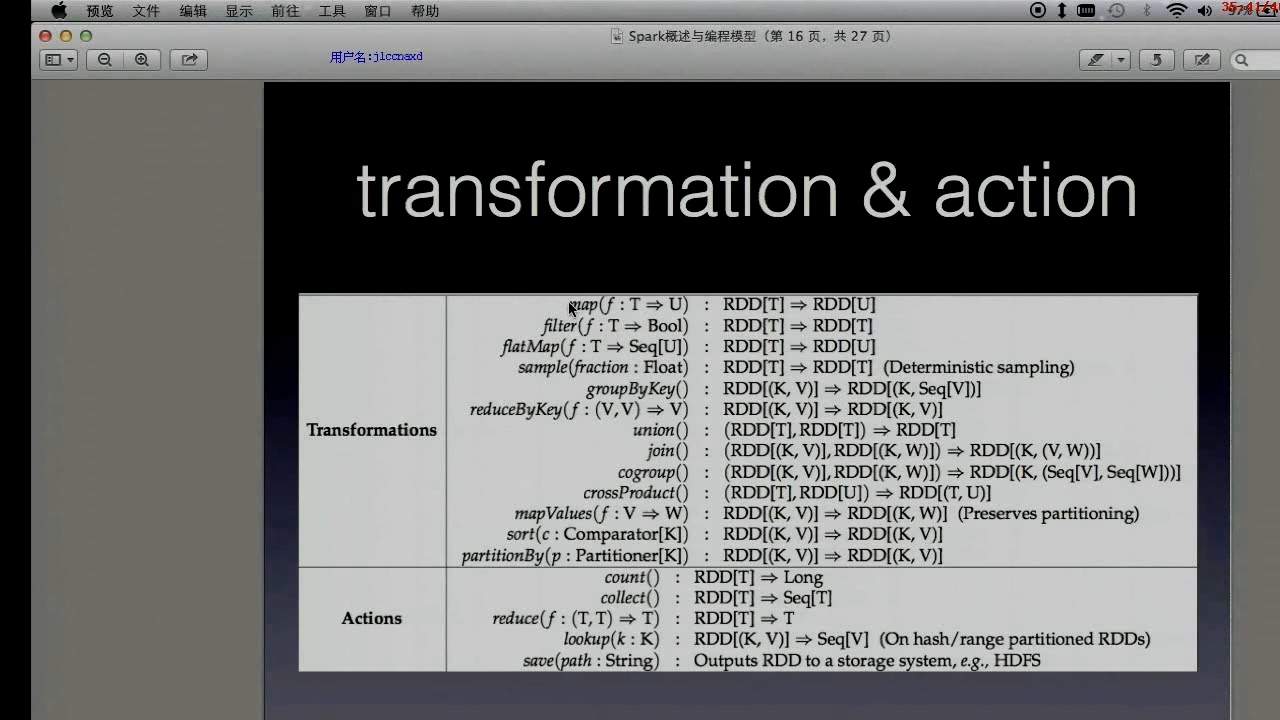

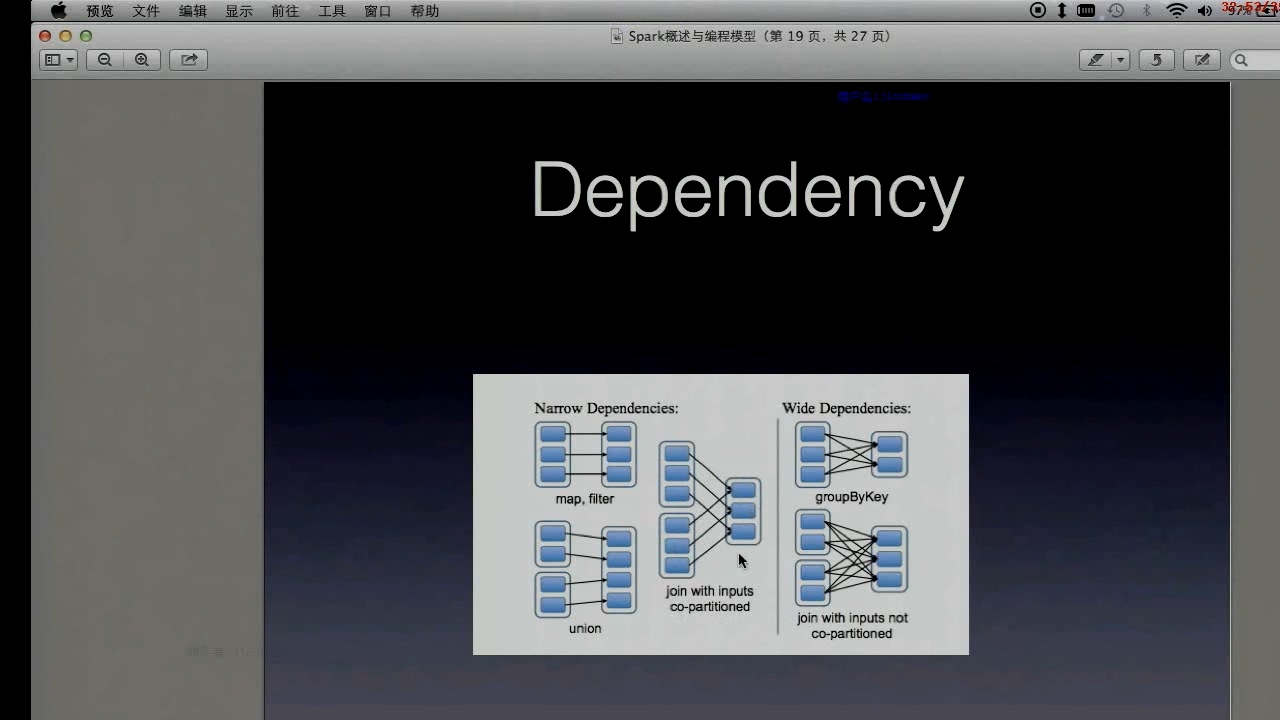

RDD wide and narrow dependencies

窄依赖每个 RDD partition最多被一个子RDD partirion依赖

/sbin(system binary)放的都是涉及系统管理的命令。

有些系统里面,普通用户没有执行这些命令的权限。

有些系统里面,普通用户的PATH不包括/sbin

data.cache 数据放到内存中

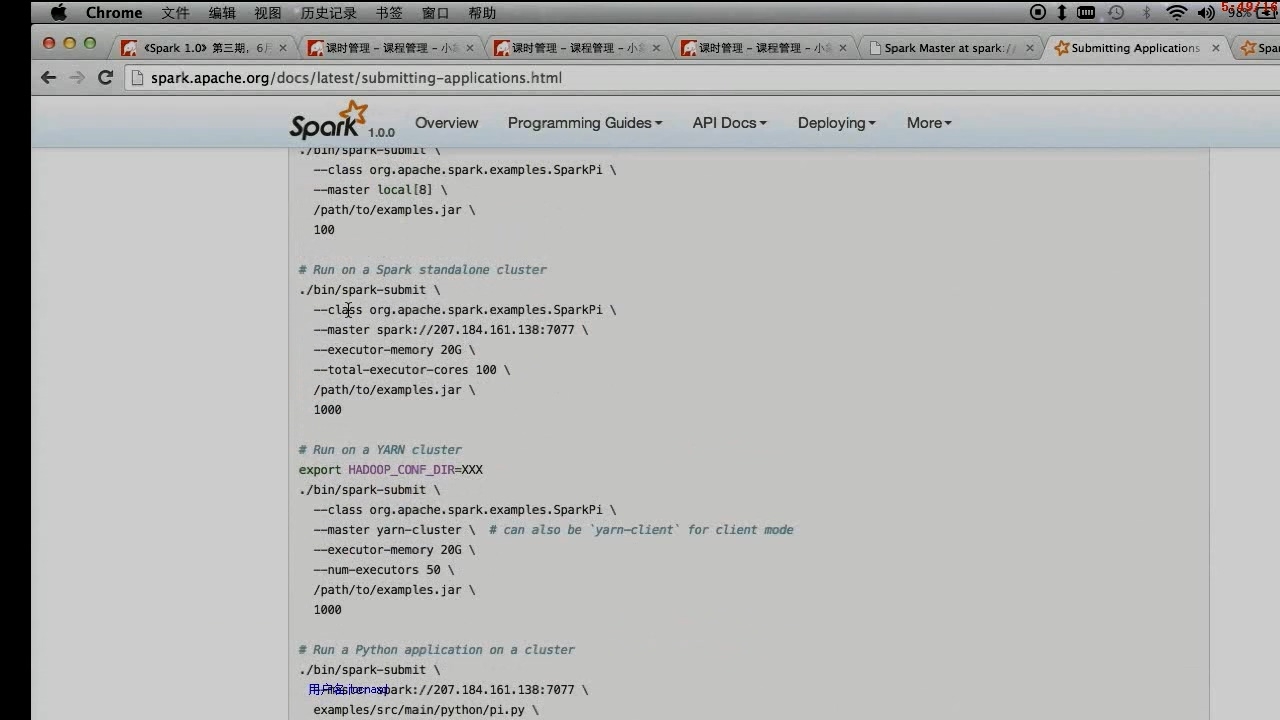

spark-submit提交任务

scala代码

package cn.chinahadoop.sparkimport org.apache.spark.{SparkContext, SparkConf}import scala.collection.mutable.ListBufferimport org.apache.spark.SparkContext._/** * Created by chenchao on 14-3-1. */class Analysis {}object Analysis{ def main(args : Array[String]){ if(args.length != 2){ println("Usage : java -jar code.jar file_location save_location") System.exit(0) } val conf = new SparkConf() conf.setSparkHome("/data/software/crazyjvm/spark") val sc = new SparkContext(conf) val data = sc.textFile(args(0)) data.cache println(data.count) data.filter(_.split(' ').length == 3).map(_.split(' ')(1)).map((_,1)).reduceByKey(_+_) .map(x => (x._2, x._1)).sortByKey(false).map( x => (x._2, x._1)).saveAsTextFile(args(1)) }}本文出自 “点滴积累” 博客,请务必保留此出处http://tianxingzhe.blog.51cto.com/3390077/1700727

0 0

- Spark 概述与编程模型

- spark概述与编程模型

- 1.Spark概述与编程模型

- Spark编程模型概述

- spark概念、编程模型和模块概述

- Spark入门到精通视频学习资料--第二章:Spark生态系统介绍,Spark整体概述与Spark编程模型(2讲)

- spark编程模型与基本架构图

- 内存计算模型spark概述

- spark 概述与安装

- Spark中的编程模型

- Spark编程模型

- Spark编程模型

- Spark中的编程模型

- spark编程模型

- spark编程模型二

- Spark中的编程模型

- Spark--RDD编程模型

- Spark-编程模型

- 多线程同步基础

- flume+kafka+hdfs详解

- java读取Excel文件

- runtime.exec()

- sqoop详解

- spark概述与编程模型

- storm-kafka(storm spout作为kafka的消费端)

- storm详解

- java中long和Long的区别

- spark内核

- spark调优

- Avro数据序列化

- Spark on yarn

- 使用IDEA社区版开发Web项目