Spark 2.0.1 运行环境的安装与测试

来源:互联网 发布:武汉地质大学网络教育 编辑:程序博客网 时间:2024/06/05 11:48

转自:http://www.cnblogs.com/anlei/p/5996818.html

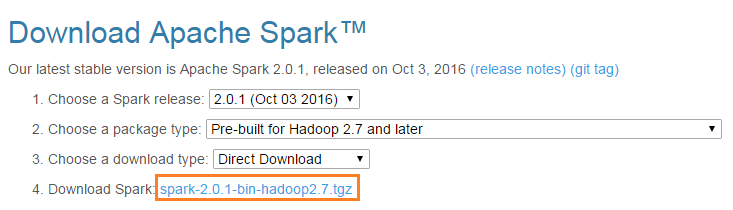

1. 官网下载

wget http://d3kbcqa49mib13.cloudfront.net/spark-2.0.1-bin-hadoop2.7.tgz

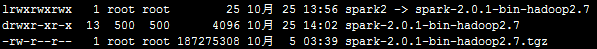

2. 解压

tar -zxvf spark-2.0.1-bin-hadoop2.7.tgz

ln -s spark-2.0.1-bin-hadoop2.7 spark2

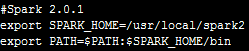

3. 环境变量

vi /etc/profile

#Spark 2.0.1

export SPARK_HOME=/usr/local/spark2

export PATH=$PATH:$SPARK_HOME/bin

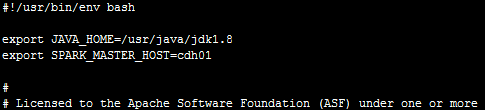

4. 配置文件(/usr/local/spark2/conf)

1) spark-env.sh

cp -a spark-env.sh.template spark-env.sh

vi spark-env.sh

export JAVA_HOME=/usr/java/jdk1.8

export SPARK_MASTER_HOST=cdh01

2) slaves

cp -a slaves.template slaves

vi slaves

cdh02

cdh03

5. 复制到其他节点

scp -r spark-2.0.1-bin-hadoop2.7 root@cdh02:/usr/local

scp -r spark-2.0.1-bin-hadoop2.7 root@cdh03:/usr/local

6. 启动

$SPARK_HOME/sbin/start-all.sh

7. 运行

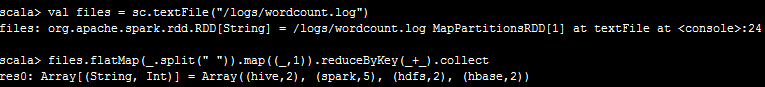

1) 准备一个文本文件放在/logs/wordcount.log内容为:

hdfs hbase hive hdfs

hive hbase spark spark

spark spark spark

2) 运行spark-shell

3) 运行wordcount

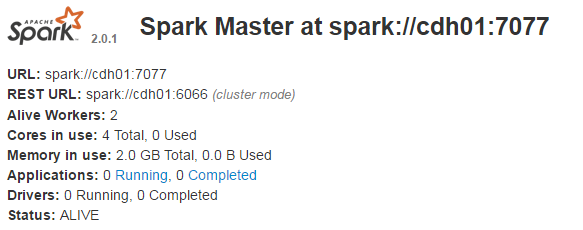

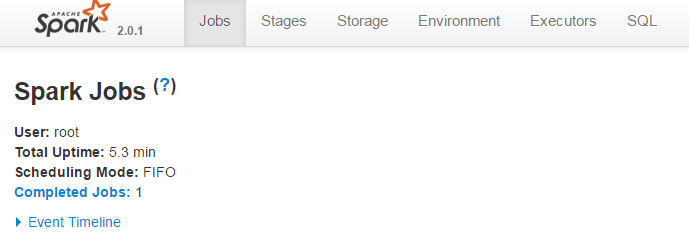

8. Web界面

http://cdh01:8080/jobs/

http://cdh01:4040/jobs/

- Spark 2.0.1 运行环境的安装与测试

- Spark运行环境的安装(Standalone)

- spark 安装与运行

- Spark系列(1)—Spark单机安装与测试

- SparkML (一) Spark的环境搭建与运行

- php运行环境与测试环境的搭建

- spark-shell的环境测试

- Spark安装与环境配置

- JAVA运行环境的安装与配置

- Redis 环境的安装与测试

- 走进Spark生态圈:环境的安装与配置

- Java 运行环境的安装、配置与运行

- Java 运行环境的安装、配置与运行

- spark的安装及测试

- Spark组件之SparkR学习1--安装与测试

- Spark快速安装与部署运行

- spark伪分布式安装与测试

- Spark学习之Hadoop安装与测试

- Tiny210(S5PV210) U-BOOT(六)----DDR内存配置

- vim去掉蓝色

- 类模板

- Java分支和循环语句及方法的使用

- PHP Ajax 跨域问题最佳解决方案

- Spark 2.0.1 运行环境的安装与测试

- Linux虚拟机网络配置

- nohup命令

- Server.xml配置

- POJ 1694 古老的游戏

- 百度富文本编辑器 UEditor 1.4.3 + Spring MVC 4.0

- cmder修改提示符为美元符号

- 微信公众号 errcode=41011, errmsg=missing agentid

- 源码研究推荐