KL距离

来源:互联网 发布:freebsd python 编辑:程序博客网 时间:2024/05/17 08:43

定义 : 两个概率质量函数为

理解

如果随机变量的真实分布为

总结就是,使用由

其他统计距离

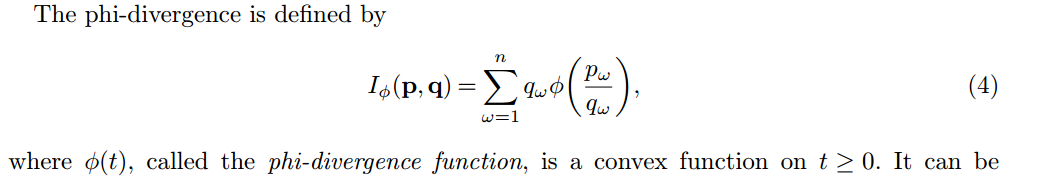

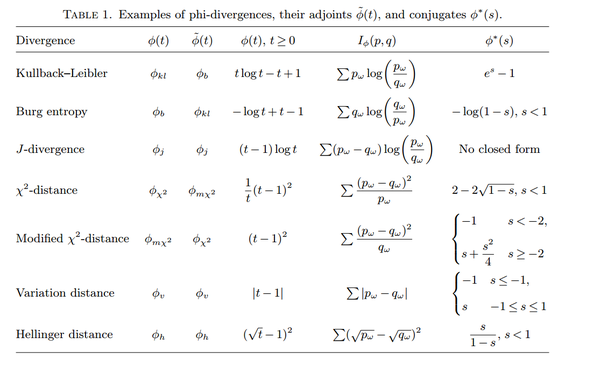

至于general的统计距离,当然,它们其实没有本质差别。更广泛的来看,KL divergence可以看成是phi-divergence的一种特殊情况(phi取log)。注意下面的定义是针对discrete probability distribution,但是把sum换成integral很自然可以定义连续版本的。

用其它的divergence理论来做上是没有本质区别的,只要phi是convex, closed的。

因为它们都有相似的概率意义,比如说pinsker’s theorem保证了KL-divergence是total variation metric的一个tight bound. 其它divergence metric应该也有类似的bound,最多就是order和常数会差一些。而且,用这些divergence定义的minimization问题也都会是convex的,但是具体的computation performance可能会有差别,所以KL还是用的多。

作者:覃含章

链接:https://www.zhihu.com/question/29980971/answer/103807952

来源:知乎

著作权归作者所有,转载请联系作者获得授权。

参考资料

- https://www.zybuluo.com/a335031/note/43211

- KL距离

- KL距离

- KL距离

- KL距离

- KL距离

- KL距离

- KL距离

- KL距离

- KL距离

- KL散度=KL距离

- KL距离 相对熵

- 【转】KL距离

- KL距离(相对熵)

- (转载)KL距离

- KL距离,Kullback-Leibler Divergence

- KL距离,Kullback-Leibler Divergence

- KL距离,Kullback-Leibler Divergence

- 信息度量与KL距离

- php对多维数组的某个键值排序方法

- Java 环境搭建 —— Git 从无到有

- mac自带计算器 进制转换

- Eclipse一点击右键就卡死

- bzoj 3398: [Usaco2009 Feb]Bullcow 牡牛和牝牛 动态规划

- KL距离

- 制作三级菜单

- 标签检查

- 随机颜色输入框

- SWUN_2016级新生校赛_开关灯

- 简单的,使用套接字实现TCP通信(用线程实现并发)

- HDU1269 迷宫城堡,Tarjan算法入门

- html简介

- java爬虫