hadoop2.X如何将namenode与SecondaryNameNode分开配置

来源:互联网 发布:mac做java开发怎么样 编辑:程序博客网 时间:2024/05/04 23:21

问题导读

1.如何将namenode与SecondaryNameNode分开?

2.SecondaryNameNode单独配置,需要修改那些配置文件?

3.masters文件的作用是什么?

我们这里假设你已经安装配置了hadoop2.2,至于如何配置可以参考,hadoop2.2完全分布式最新高可靠安装文档。

在这个基础上,我们对配置文件做一些修改:

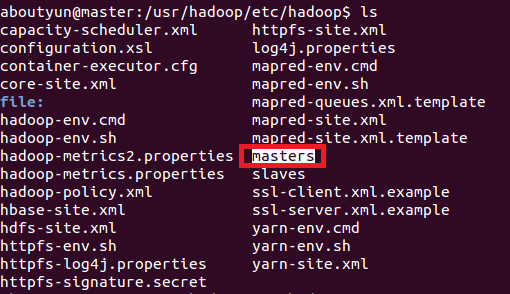

1.增加masters文件

这里面放什么内容还是比较关键的,这里我们指定slave1节点上运行SecondaryNameNode。

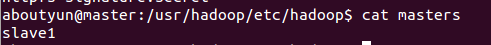

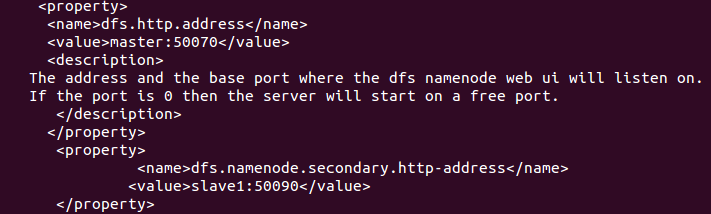

2.修改hdfs-site.xml

在下面文件中增加如下内容:(记得下面亦可写成ip地址,这里为了理解方便,写的是hostname)

3.修改core-site.xml文件

上面修改完毕,相应的节点也做同样的修改

下面我们开始启动节点:

输出如下内容:

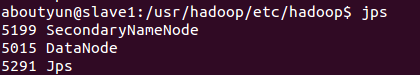

然后查看节点:

(1)master节点:

(2)slave1节点

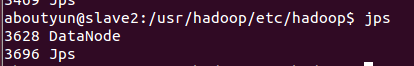

(3)slave2节点

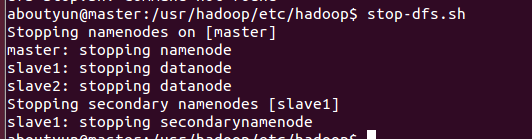

停止节点:

Secondarynamenode的单独启动和停止

启动:

bin/hadoop-daemons.sh --config conf/ --hosts masters start secondarynamenode

停止:

bin/hadoop-daemons.sh --config conf/ --hosts masters stop secondarynamenode

hadoop的启动命令:

start-dfs.sh

一旦执行这个脚本,它就会启动master,slave,然后secondarynamenode。

也就是说start-dfs.sh对它们进行了定义,你可以修改里面的脚本。

0 0

- hadoop2.X如何将namenode与SecondaryNameNode分开配置

- hadoop2.X如何将namenode与SecondaryNameNode分开配置

- hadoop2.X如何将namenode与SecondaryNameNode分开配置

- hadoop2.X如何将namenode与SecondaryNameNode分开配置

- 基于hadoop2.2的namenode与SecondaryNameNode分开配置在不同的计算机

- 基于hadoop2.2的namenode与SecondaryNameNode分开配置在不同的计算机

- hadoop2.X配置SecondaryNameNode

- hadoop1.x下的NameNode与SecondaryNameNode

- Hadoop2.x版本中配置SecondaryNameNode

- secondaryNamenode配置与nameNode故障恢复

- Hadoop中namenode和secondarynamenode分开部署

- NameNode 与 SecondaryNameNode 的关系

- Hadoop2.2.0中配置SecondaryNameNode

- 配置hadoop2.X的namenode HA及Yarn HA

- hadoop2.x 如何解决NameNode单节点故障问题?

- hadoop集群管理之SecondaryNameNode与NameNode

- NameNode,SecondaryNameNode与Datanode文件详解

- Hadoop的NameNode与SecondaryNameNode,DataNode

- Jmeter测试Java请求示例

- token认证,基础知识

- iOS Blocks 编程(一)

- flex布局总结

- Android 计时器 Chronometer or timer+timerTask

- hadoop2.X如何将namenode与SecondaryNameNode分开配置

- 为Oraclespatial表添加记录和创建空间索引

- Backbone入门指南(四):Model(数据模型)

- JSP九大内置对象(Request,Response,Out,Session,Application,Cookie,Config,Page,Exception)

- iOS Blocks 编程(二)

- java多线程3(线程的阻塞和生命周期)

- java Web 转发 重定向

- mysql 和 redis的一些区别

- App 上传APPStore报错 ERROR ITMS-90086?