线性支持向量机中KKT条件的讨论

来源:互联网 发布:windows 开启远程桌面 编辑:程序博客网 时间:2024/06/05 02:33

线性支持向量机中KKT条件的讨论

此处的模型为训练样本不可分时的线性支持向量机,简称为线性支持向量机。即考虑松弛变量

原始问题

则线性不可分的线性支持向量机的学习问题变成如下的凸二次规划(convex quadratic programming)问题,即原始问题

对偶问题

原始问题的拉格朗日函数为

对偶问题拉格朗日函数的极大极小问题,得到以下等价优化问题

KKT条件

原始问题的解对偶问题的解相同需要满足KKT对偶互补条件,即

对样本

Platt在序列最小优化(SMO)方法1中提到,对正定二次优化问题(a positive definite QP problem)的优化点的充分必要条件为KKT条件(Karush-Kuhn-Tucker conditions)。

对于所有的

其中

KKT条件的推导

下面我们将要讨论如何从式(1)、(2)得到式(3) ~ (5)。

(1)

由

则由式(2)可知,

再由原始问题的约束条件

(2)

将

又

因为

又由式(1),有

(3)

由式(1),有

因为

即可得式(3) ~ (5),KKT条件得以推导。

KKT条件的几何解释

在线性不可分的情况下,将对偶问题的解

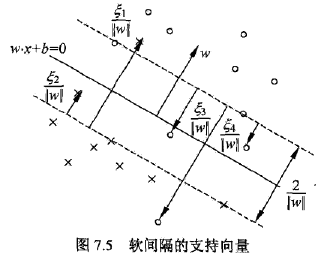

如下图所示,分离超平面由实线表示,间隔用虚线表示,正例由“o”表示,负例由“x”表示。实例

软间隔的支持向量

这里可以从两种角度来解释,第一种角度就像李航在《统计学习方法》第113页中用到间隔边界的距离边界

若

α∗i<C ,则ξi=0 ,支持向量xi 恰好落在间隔边界上;

若α∗i=C,0<ξi<1 ,则分类正确,xi 在间隔边界与分离超平面之间;

若α∗i=C,ξi=1 ,则xi 在分离超平面上;

若α∗i=C,ξi>1 ,则xi 位于分离超平面误分一侧。

现在我们要从另外一种角度,也就是KKT条件(式(3)~(5)),通过数学推导来得到上面的结果。

在间隔边界上

由式(3)可知,当

在间隔边界与分离超平面之间

当

则说明

在分离超平面上

当

即

在分离超平面误分一侧

当

则分类错误,

以上就是对线性支持向量机中KKT条件的仔细讨论,从公式推导和几何意义上一同解释了为什么

这是我在看书的时候不是很明白的问题,现在通过理论上的推导能够清楚地得到结果,也希望能够解答其他有同样问题人的疑惑。

问题是越思考越清楚,希望在今后的学习中继续保持这种认真对待知识的态度。

- 李航. 统计学习方法[J]. 清华大学出版社, 北京, 2012. ↩

- 线性支持向量机中KKT条件的讨论

- SVM(支持向量机)中拉格朗日乘子法(Lagrange Multiplier) 和KKT条件

- 线性支持向量机

- 线性支持向量机

- 线性支持向量机

- PRML读书会第七章 Sparse Kernel Machines(支持向量机, support vector machine ,KKT条件,RVM)

- 【机器学习-西瓜书】六、支持向量机(SVM):最大间隔;对偶问题;KKT条件

- KKT条件的推导

- 线性支持向量机中最优参数b

- 支持向量机中所谓的支持向量究竟是什么?

- 支持向量机中所谓的支持向量究竟是什么?

- SVM支持向量机原理(二) 线性支持向量机的软间隔最大化模型

- 支持向量机原理(二) 线性支持向量机的软间隔最大化模型

- 支持向量机对线性不可分数据的处理

- 逻辑回归和线性支持向量机之间的区别

- 支持向量机之线性支持向量机(三)

- SVM支持向量机原理(一) 线性支持向量机

- 支持向量机专题——线性支持向量机

- SSRS fetchxml中like的写法

- 欢迎使用CSDN-markdown编辑器

- 网络编程之IPC通信

- HTML学习---------1.14 在文本中插入一行或多行代码使用的标签<code> <pre>

- 史上最简单的SpringCloud教程 | 第九篇: 服务链路追踪(Spring Cloud Sleuth)

- 线性支持向量机中KKT条件的讨论

- 大话设计模式阅读笔记-迪米特法则

- Pandas透视表(pivot_table)详解

- R-test

- Java中的Arrays类

- 以socket为基础的java聊天软件

- java递归方法

- 小明的棋盘(烽火2017校园招聘)

- js实现排序