深度模型中的优化算法

来源:互联网 发布:百度的大数据 编辑:程序博客网 时间:2024/06/05 08:57

某猪场的笔试题问到了深度学习中的优化算法,由于准备不足扑街了,后来补了一下这方面的知识,整理如下:

基本算法

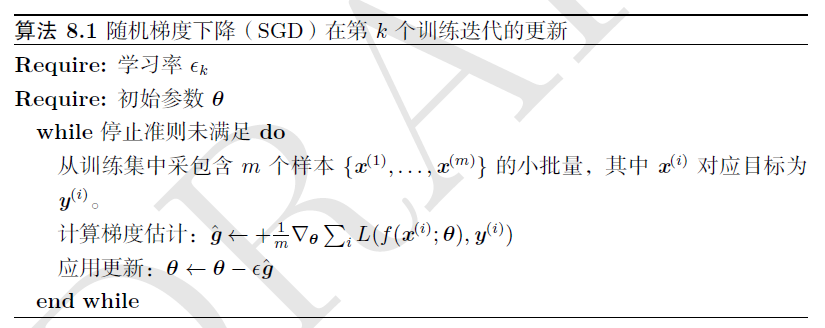

随机梯度下降(SGD)

实践中,一般会线性衰减学习率直到第

其中,

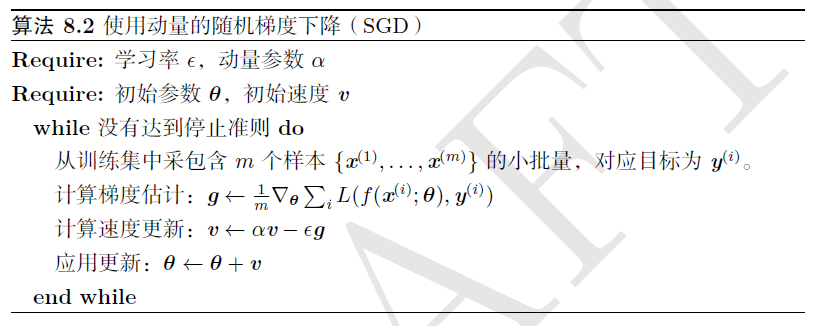

动量(momentum)

如果动量算法总是观测到梯度

因此,

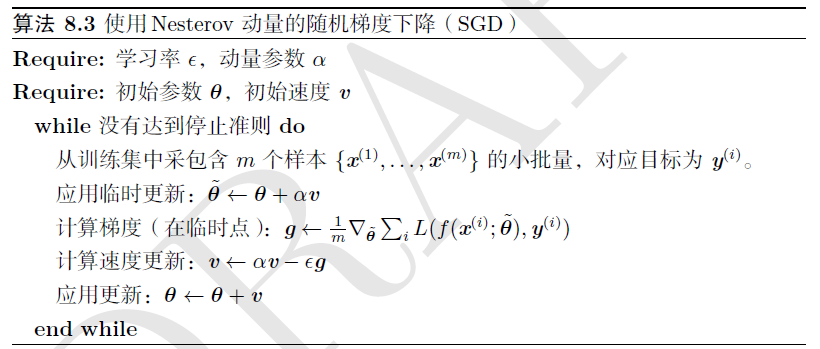

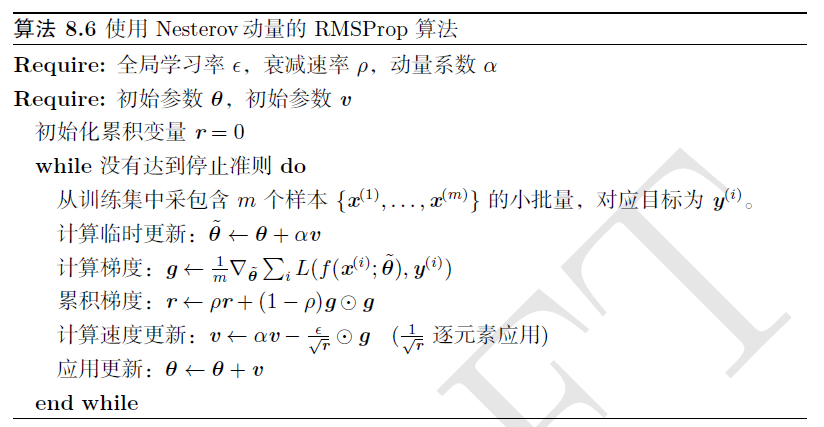

Nesterov动量

Nesterov 动量中,梯度计算在施加当前速度之后。因此,Nesterov 动量可以解释为往标准动量方法中添加了一个校正因子。

在凸批量梯度下有改进,但是在随机梯度下没有改进收敛率。

参数初始化策略

Gaussian initialization

Xavier initialization

He initialization

Batch Normlization

参数初始化部分可以参考知乎的这篇文章。

自适应学习率算法

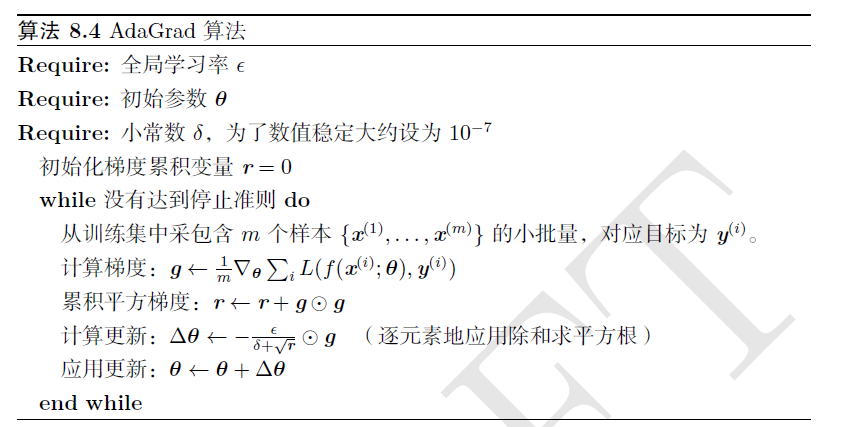

AdaGrad

在凸优化背景下,AdaGrad算法具有一些令人满意的理论性质。

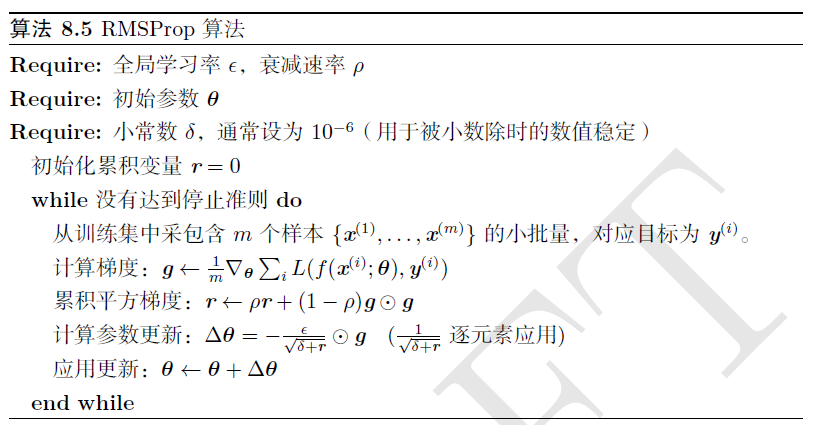

RMSProp

RMSProp 算法(Hinton, 2012) 修改AdaGrad 以在非凸设定下效果更好,改变梯度积累为指数加权的移动平均。

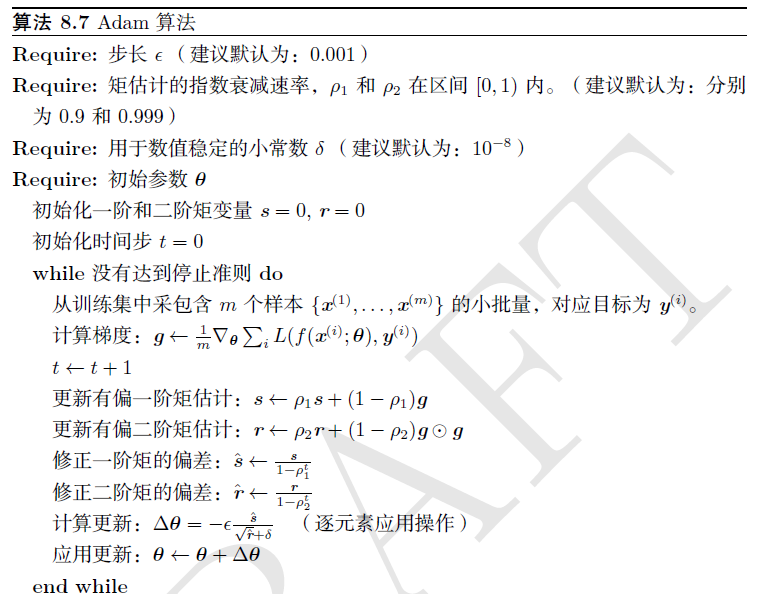

Adam

Adam通常被认为对超参数的选择相当鲁棒。

以上截图出自“花书”——Goodfellow的《深度学习》。

阅读全文

0 0

- 深度模型中的优化算法

- 深度学习中的优化算法

- 深度学习中的优化算法

- Deep Learning读书笔记4---深度模型中的优化

- 【回顾】Deep Learning 读书分享:深度模型中的优化

- 深度学习中的优化不同于一般优化算法

- 深度学习第八章自学笔记——深度模型中的优化

- 深度学习中的梯度下降优化算法笔记

- 深度学习中的概率统计、数值优化算法

- 深度学习 优化算法

- 优化:深度学习优化算法

- 优化:深度学习中的优化

- 深度理解Powell优化算法

- 【深度学习】常见优化算法

- 【深度学习】常见优化算法

- 深度优化&广度优先 算法

- 深度学习常用优化算法

- 深度学习中的优化方法

- redis集群搭建

- spring cloud搭建微服务second-fiberhome(四):结合consul和config,进行网关GetWay搭建

- VC与Matlab混合编程

- Android百分比布局库

- 正交相机视野控制

- 深度模型中的优化算法

- 解决maven clean install后tomcat启动项目提示“is out of sync”的错误

- jdk1.7的switch语句支持String数据类型了

- 3、flask第三站-模板

- 枚举enum(Swift)

- 线程锁

- 【NOIP2013提高组】花匠

- asp.net中web.config配置错误页

- #Git原理的简单理解