概率基础及贝叶斯决策理论

来源:互联网 发布:淘宝衣服检测 编辑:程序博客网 时间:2024/05/16 08:20

- 引言

- 概率基础

- 条件概率

- 全概率公式

- 贝叶斯公式

贝叶斯分类算法是统计学的一种分类方法,它是一类利用概率统计知识进行分类的算法。在许多场合,朴素贝叶斯(Naive Bayes,NB)分类算法可以与决策树和神经网络分类算法相媲美,该算法能运用到大型数据库中,而且方法简单、分类准确率高、速度快。但由于该算法以自变量之间的独立(条件特征独立)性和连续变量的正态性假设为前提,就会导致算法精度在某种程度上受影响,以上信息来自百度百科。

引言

问题:张三是男生还是女生?简单的两类决策问题。

1. 在没有任何信息的情况下,根据类别的先验知识进行判断

2. 根据对张三的观测现象(扎马尾,穿裙子)进行推断

- 目标(事物)的观察值是随机的,服从一定的概率分布。即:模式不是一个确定向量,而是一个随机向量。

概率基础

条件概率

条件概率(conditional probability)就是事件A在另外一个事件B已经发生条件下的发生概率。条件概率表示为P(A|B),读作“在B条件下A的概率”。在有的时候也叫做后验概率,如下图可知:

即:

同理可得:

因此:

即:

全概率公式

全概率公式为概率论中的重要公式,它将对一复杂事件A的概率求解问题转化为了在不同情况下发生的简单事件的概率的求和问题。如下图,假设S空间划分为B1、B2……Bn,一共n个部分。

因此,

而有前面的条件概率可以进一步得到:

这就是全概率公式,详细可参考全概率公式百度百科。

贝叶斯公式

对条件概率公式进行变形,可以得到如下形式:

- 我们把

P(A) 称为”先验概率”(Prior probability),即在B事件发生之前,我们对A事件概率的一个判断。P(A|B) 称为”后验概率”(Posterior probability),即在B事件发生之后,我们对A事件概率的重新评估。P(B|A)/P(B) 称为”可能性函数”(Likelyhood),这是一个调整因子,使得预估概率更接近真实概率。

因此,条件概率可以理解成下面的式子:后验概率=先验概率x调整因子

这就是贝叶斯推断的含义。我们先预估一个”先验概率”,然后加入实验结果,看这个实验到底是增强还是削弱了”先验概率”,由此得到更接近事实的”后验概率”。 在这里,如果”可能性函数”

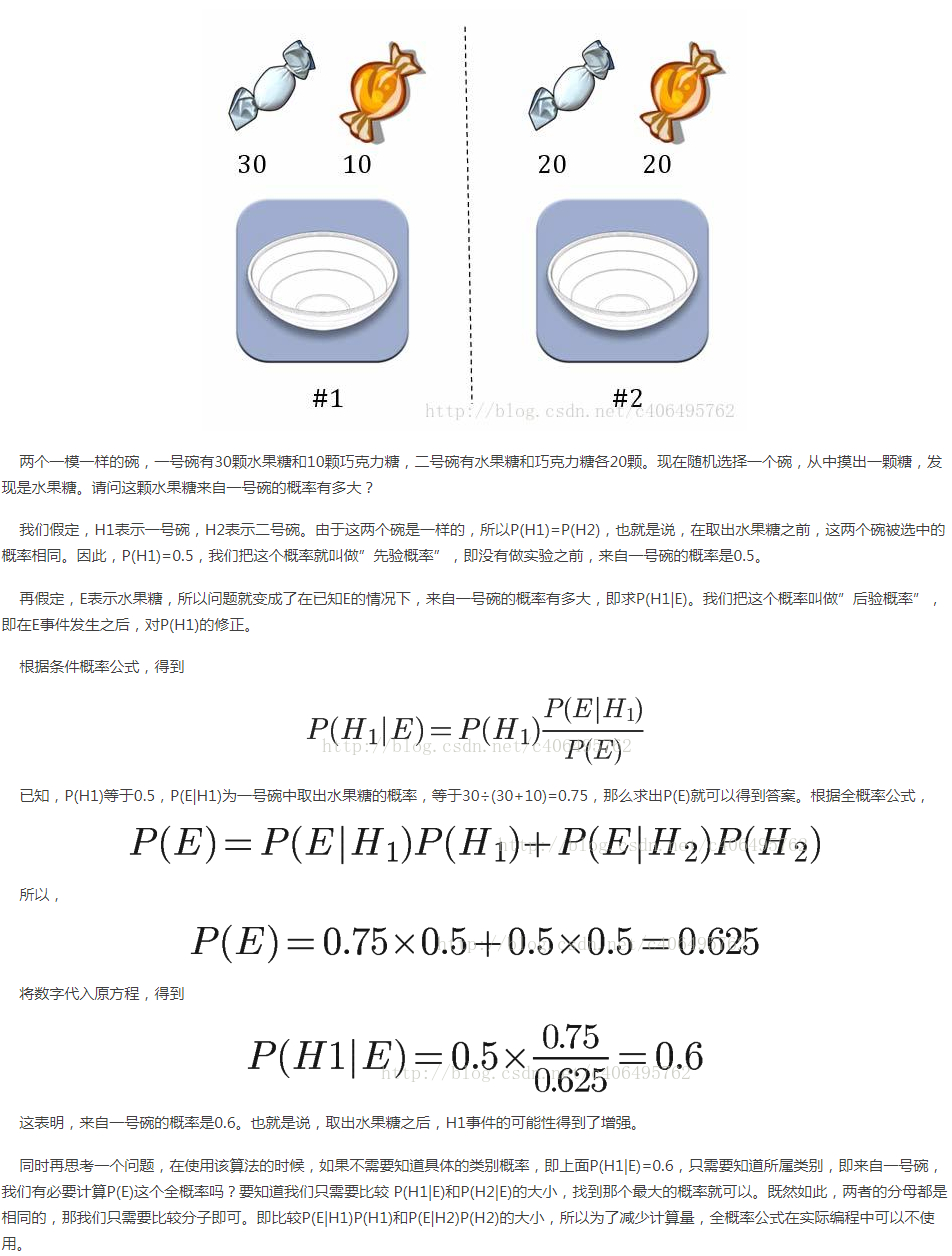

接下来举一个简单的例子来加深印象:

- 参考链接

[1]https://baike.baidu.com/item/%E6%9C%B4%E7%B4%A0%E8%B4%9D%E5%8F%B6%E6%96%AF

[2]https://baike.baidu.com/item/%E8%B4%9D%E5%8F%B6%E6%96%AF%E5%88%86%E7%B1%BB%E7%AE%97%E6%B3%95/7346561

- 概率基础及贝叶斯决策理论

- 贝叶斯决策理论和概率密度估计方法

- 贝叶斯决策理论

- 贝叶斯(Bayes)决策理论

- 贝叶斯(Bayes)决策理论

- 贝叶斯(Bayes)决策理论

- 贝叶斯决策理论

- 贝叶斯决策理论

- 贝叶斯决策理论

- 贝叶斯决策理论

- 贝叶斯决策理论

- 贝叶斯(Bayes)决策理论

- 模式识别(一)贝叶斯决策理论和未知概率密度函数估计

- 贝叶斯决策理论(一)

- 贝叶斯决策理论(二)

- 贝叶斯决策理论(三)

- 模式识别简介&贝叶斯决策理论

- 模式识别入门与贝叶斯决策理论

- linux下进程间通信方式之(1)-管道及fork()函数

- 将less文件转换成css文件

- 51单片机矩阵键盘C程序

- Intellij IDEA新建SpringMVC配置

- Oi

- 概率基础及贝叶斯决策理论

- 计算几何(具象的难题)

- <Myeclipse> Servlet之连接数据库查询

- 操作系统之内存管理(一)(未引入虚拟内存之前部分)

- Rust : 求出一个字符串数组中最长的公共连续子序列

- 10.15总结

- 2016级算法第一次上机——E ModricWang's QuickSort

- 猜数字游戏

- centos7 配置多个Tomcat