14过拟合(Overfitting)

来源:互联网 发布:淘宝免运费怎么赚钱 编辑:程序博客网 时间:2024/09/21 08:16

过拟合:我们通过训练集训练的模型对于训练样本的的拟合程度十分高,就会放大一些不必要的特征,再对测试集进行测试时,就容易造成测试精度很低,也就是模型的泛化能力很弱,这就是过拟合。

那么我们如何解决过拟合问题呢?

方法一: 增加数据量, 大部分过拟合产生的原因是因为数据量太少了. 如果我们有成千上万的数据, 红线也会慢慢被拉直, 变得没那么扭曲 .

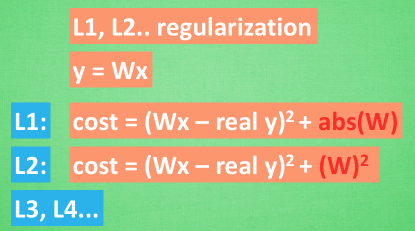

方法二:利用L1、L2正则化。利用惩罚机制,让W参数变化不会过大,这些方法适用于大多数的机器学习, 包括神经网络.

方法三:Dropout仅适用于神经网络。在训练的时候, 我们随机忽略掉一些神经元和神经联结 , 是这个神经网络变得”不完整”. 用一个不完整的神经网络训练一次.到第二次再随机忽略另一些, 变成另一个不完整的神经网络. 有了这些随机 drop 掉的规则, 我们可以想象其实每次训练的时候, 我们都让每一次预测结果都不会依赖于其中某部分特定的神经元. 像l1, l2正规化一样, 过度依赖的 W , 也就是训练参数的数值会很大, l1, l2会惩罚这些大的 参数. Dropout 的做法是从根本上让神经网络没机会过度依赖.

阅读全文

0 0

- 14过拟合(Overfitting)

- 过拟合(overfitting)

- 过拟合overfitting

- 过拟合overfitting

- overfitting(过拟合)的概念

- 过拟合(overfitting) vs 正则化(regularization)

- (过拟合及其防治)Overfitting and Its Avoidance

- 机器学习--神经网络算法系列--过拟合(overfitting)

- 欠拟合(Underfitting) & 过拟合(Overfitting) & 正则化(Regularization)

- 机器学习中:过拟合(overfitting)和欠拟合(underfitting)

- 局部加权回归、欠拟合、过拟合(Locally Weighted Linear Regression、Underfitting、Overfitting)

- 数据挖掘: overfitting 过拟合情况 整理

- 机器学习—过拟合overfitting

- Tensorflow Overfitting过拟合解决方法 Dropput()使用方法

- 机器学习-过拟合 (Overfitting)

- 听课笔记(第十三讲): 过拟合 - Overfitting (台大机器学习)

- 听课笔记(第十三讲): 过拟合 - Overfitting (台大机器学习)

- (八)Tensorflow学习之旅——理解过拟合overfitting

- PAT

- C++之--智能指针Smart Pointer

- Android Studio Bookmarks

- S32V234汽车电子应用功能挖掘的相关文章:双目立体、雷达视觉融合、ADAS集成

- IT项目制定线路图(Product Roadmap)中应注意的问题

- 14过拟合(Overfitting)

- 帧内预测-函数initAdiPattern

- Android studio 解决“Cannot resolve symbol BasicHttpparams”

- 仿网易云音乐滑动效果

- activemq试水-java

- 自定义简单日志记录类

- 自定义View(二-番外10-番外终结篇)

- Mybatis入门

- 开发环境搭建