深度机器学习中的batch

来源:互联网 发布:mac磁盘可清除怎么清除 编辑:程序博客网 时间:2024/05/18 03:38

深度学习中的 Batch_Size

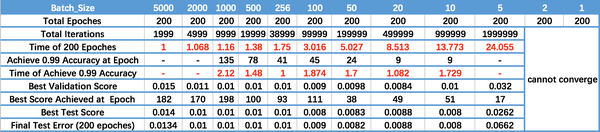

Batch_Size(批尺寸)是机器学习中一个重要参数,涉及诸多矛盾,下面逐一展开。

首先,为什么需要有 Batch_Size 这个参数?

Batch 的选择,首先决定的是下降的方向。如果数据集比较小,完全可以采用全数据集 ( Full Batch Learning )的形式,这样做至少有 2 个好处:其一,由全数据集确定的方向能够更好地代表样本总体,从而更准确地朝向极值所在的方向。其二,由于不同权重的梯度值差别巨大,因此选取一个全局的学习率很困难。 Full Batch Learning 可以使用Rprop 只基于梯度符号并且针对性单独更新各权值。

对于更大的数据集,以上 2 个好处又变成了 2 个坏处:其一,随着数据集的海量增长和内存限制,一次性载入所有的数据进来变得越来越不可行。其二,以 Rprop 的方式迭代,会由于各个 Batch 之间的采样差异性,各次梯度修正值相互抵消,无法修正。这才有了后来 RMSProp 的妥协方案。

既然 Full Batch Learning 并不适用大数据集,那么走向另一个极端怎么样?

所谓另一个极端,就是每次只训练一个样本,即 Batch_Size = 1。这就是在线学习(Online Learning)。线性神经元在均方误差代价函数的错误面是一个抛物面,横截面是椭圆。对于多层神经元、非线性网络,在局部依然近似是抛物面。使用在线学习,每次修正方向以各自样本的梯度方向修正,横冲直撞各自为政,难以达到收敛。

阅读全文

0 0

- 深度机器学习中的batch

- 深度学习中的batch size

- 深度学习中的Batch Normalization

- 深度机器学习中的batch的大小对学习效果有何影响?

- 深度机器学习中的batch的大小对学习效果有何影响?

- 深度机器学习中的batch的大小对学习效果有何影响?

- 深度机器学习中的batch的大小对学习效果有何影响?

- [调参技巧]深度机器学习中的batch的大小对学习效果有何影响?

- 深度学习中的batch、batch size与epoch

- 深度学习机器学习区别,深度学习batch大小对学习效果的影响

- 深度学习--Batch Normalization

- 【深度学习】Batch Normalization

- 机器学习: batch normalization

- 深入浅出——深度学习中的Batch Normalization使用

- #深度学习#关于训练中的batch, epoch 以及online training

- 深度学习中的batch size 以及learning rate参数理解

- 深度学习的Batch Normalization

- 深度学习: Batch Normalization (归一化)

- CCF CSP 201709-3 JSON查询

- .Net Micro Framework 快速入门

- mysql主从复制配置实现及其监控与维护

- tomcat集群会话保持

- 机器学习评估方法——P值校验

- 深度机器学习中的batch

- missing artifact com.oracle:ojdbc14:jar:10.2.0.2.0解决办法

- 七牛云存储域名配置

- 文件上传三种方式

- [虚树 + DP] BZOJ2286: [Sdoi2011]消耗战

- PMP笔记-产品核实、范围核实及质量控制的区别

- HDU 2212 DFS【思维】

- ubuntu重装的一些问题

- ARP和普通代理ARP

纳米酱

纳米酱