数据分析中会常犯哪些错误,如何解决? 四

来源:互联网 发布:迅雷 2.7.5 mac 破解 编辑:程序博客网 时间:2024/05/17 18:29

链接:https://www.zhihu.com/question/19578400/answer/24785530

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

最近发现大家对如何成为一名数据科学家?的答案比较关注,表示受宠若惊。最近有点小忙,但作为一名DMer鄙人决定继续分享一些知识来回报各位厚爱。下面是看统计报告时要注意的点。

一、数据来源如何说谎

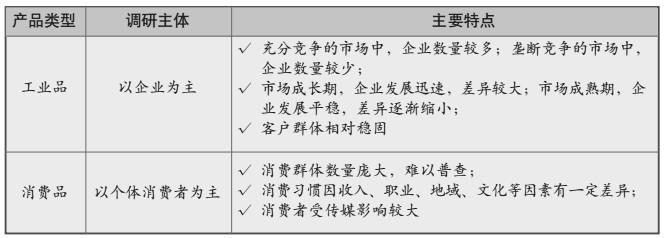

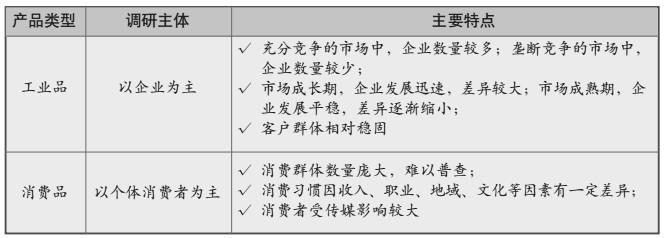

最简单的层级,在查阅统计报告之前首先应该关注的是报告出处以及数据来源。以工业品和消费品为例主要的数据来源如下所示:

关于数据的来源我们需要注意四点:

(1).数据发布机构是否权威?(代表性)

网上主流的数据资源太多,以下列举一些,不一而足。

- 国研网:行研报告,各类数据(需要付费T T)。

- 国家统计局数据库:宏观数据、金融、教育、行业数据等,包含国家一级、31个省以及200多个市的数据。

- 《中国统计年鉴》:历年统计年鉴以及普查数据、专题数据等。

- United Nations Statistics Division:联合国数据库

- Data | The World Bank: 世界银行数据库

- Federal Reserve Economic Data:美联储数据库

- Socioeconomic Data and Applications Center:美国航空航天局NASA的地球观测系统数据

(3).数据采集面向的对象?(调研主体)

举例说明。产品可分为工业类产品和消费类产品,它们在基本属性、购买特征、营销理念等方面有本质的不同,所以需要调研的主体不同。

- 工业类产品:供需双方一般都是企业,需要了解总产值、总产量、销售总额、销售总量,所以调研主体以企业为主。

- 消费类产品:面向大众消费者,统计口径一般是零售市场消费总量、总额,所以调研主体以个体消费者为主。

(4).数据是一手数据还是二手数据?(时效性,相关性)

- 一手数据(Primary data):也称原始数据。指通过人员访谈、询问、问卷、测定等方式直截获得的,时效性和相关性更好。

- 二手数据(Secondary data):利用文献,统计年报以及数据库等前人统计好的数据资料。优点是获取成本低,且现成可用。一般可以长时间保存,生成数据趋势图方便。

- 一手数据:通过电话采访工人,询问他们多久时间能回到工作、以及返回到工作流程等问题。研究人员得出结论,包括返回到工作流程包括提供优惠住宿,以及为什么一些工人拒绝了这样的提议。

- 二手数据:包括政府,企业的健康和安全记录,例如工人的受伤率,以及工人在国内不同行业的数据。研究人员发现了工伤索赔额度与全职工人工资额度之间的数量关系。

通过例子可以看出,一手数据提能够提供量身定制的信息,但往往是需要很长的时间以及昂贵的成本。二手数据通常是能够廉价的取得,而且可在更短的时间内进行分析,但由于数据获取的初始目的可能与研究目的不相关,需要梳理信息来提取您要找的内容。数据研究人员选择的类型时候应该考虑很多因素,包括所研究的问题,预算,技术和可用资源。基于这些因素的影响,他们可能会选择使用一手数据或二手数据,甚至两者兼备。

(5).数据采集方式是什么?(投票方式)

在网络上进行投票还是在现实中分发问卷有很大的不同,两者都有很多细节点需要注意。

- 网络投票:如何防止机器人,恶意投票以及UI的设计是关键。可以参考推荐系统的用户反馈设计。

- 现实问卷:如何设计题目(逻辑性、完整性、非诱导性)以及投放方式(时间、地点、对象)是关键。可以参考调查问卷的设计与评估 (豆瓣)。

二、数据统计如何说谎

数据统计中常常会出现的谎言,这是因为虽然原始的数据相同,但是数据处理的过程不同。具体情况通常可分为四种:抽样方法、样本选取、离群值处理及统计指标设置。

(1).抽样方法的区别

整体样本的维度,粒度和取数逻辑相同的情况下,不用的样本抽样规则会使数据看来更符合或不符合“预期”,从而实现特殊目的。我们知道最基本的定量研究的抽样方法分为两类,一类为非概率抽样,一类为概率抽样。其中概率抽样方法分为四种:

- 随机抽样(Simple random sampling)

优点:操作简单,均数及相应的标准误计算简单。

缺点:总体较大时,难以一一编号。

- 系统抽样(Systematic sampling,又名机械抽样、等距抽样)

优点:易于理解、简便易行。

缺点:总体有周期或增减趋势时,易产生偏差。

- 整群抽样(Cluster sampling,整体抽样)

优点:便于组织、节省经费。

缺点:抽样误差大于单纯随机抽样。

- 分层抽样(Stratified sampling)

优点:样本代表性好,抽样误差减少。

缺点:抽样过程繁杂。

栗子1:在建立客户流失模型时,使用分层抽样。假如两次调研的抽样样本分别是最近一年未消费流量的客户和最近一年未消费流量但经常收发短信的客户,不用做测试基本上就可以确定后者的流失可能性更小。而如果使用随机抽样则很难得出上述结论,所以数据抽样方法的选择对结论影响较大,实际操作时具体需要深入到SQL查询逻辑的研究。

栗子2:普林斯顿大学的信息技术政策中心(CITP)和北卡罗莱纳州大学教堂山分校(University of North Carolina at Chapel Hill)在2013年发表了一篇文章《Big Data: Pitfalls, Methods and Concepts for an Emergent Field:大数据:一个新兴领域的陷阱、方法和概念》。通过实验对一些市场营销人员发出警告:请首先确认抽样的方法是否能够真正地覆盖的整个市场,不要对从社交媒体渠道(如Twitter和Facebook)收集的消费者数据过于自信。

1.Inadequate attention to the implicit and explicit structural biases of the platform(s) most frequently used to generate datasets (the model organism problem).

2.The common practice of selecting on the dependent variable without corresponding attention to the complications of this path.

3.Lack of clarity with regard to sampling, universe and representativeness (the denominator problem).

4.Most big data analyses come from a single platform (hence missing the ecology of information flows).

作者Zeynep Tufekci(博客地址:technosociology,北卡罗来纳大学教授)通过描述对果蝇进行生物测试的方法,质疑很大程度上依赖社会化媒体形成的大数据方法论。大多数的大数据集(Big datasets)研究只包含“节点到节点”(Node-to-node)之间的信息互动;然而面对社会中的群体性事件,无论是通过经验分享或通过广播媒体传播,“场”(Field)效应的地位更加重要。一个典型营销活动(Twitter、Facebook上)的用户参与百分比只有10%,只代表一定的细分市场,可能扭曲调查结果。这些市场调差报告不能准确反映市场的数据,所以无法据此制定出可靠的未来计划。

(2).样本选取的区别

从严格意义上来说统计范围的选择问题并不一定是故意欺骗,因为在数据采集的实践中确实存在样本量失衡的情况,如果遇到这种情况一般使用欠抽样(Under-sampling)和过抽样(Oversampling)进行样本平衡。通常来说样本的问题主要分为以下三种情况:

- 样本抽取的数量。这一点很容易理解,数据样本量差距越大,可比性越小。尤其是在样本分布不均时,数据结果可信度低。

- 样本抽取的主体。为了制造某种统计结果而故意选择对结果有利的样本主体。如针对农村用户和城市用户统计某手机市场占有率,后者结果肯定优于前者。

- 样本抽取的客观环境。比如做运营商网站用户体验分析(User Experience,简称UE),ISO 9241-210标准中对用户体验的定义有如下补充说明:用户体验,即用户在使用一个产品或系统之前、使用期间和使用之后的全部感受,包括情感、信仰、喜好、认知印象、生理和心理反应、行为和成就等各个方面。三个影响用户体验的因素:系统,用户和使用环境。如果测试方法都没有完全相同的客观环境,即使选的是相同样本和用户,分析结果可信度依然较低。

更多资料推荐:

抽样调查设计导论 (豆瓣)

Sampling (豆瓣)(豆瓣版本老,现在有09年新版)

(3).离群值处理方法的区别

离群值(Outlier,异常值):指样本中的个别值,其数值明显偏离其所属样本的其余观测值。 离群值与非离群值之间并没有明显的区别。实际上,用户必须指定一个阈值,以便界定离群值。偏差度高于这个阈值的所有集群被标记为离群值集群,它们的成员都是离群值。如上图中所示。如果设定阈值600,则Cluster3为离群值。

离群值与非离群值之间并没有明显的区别。实际上,用户必须指定一个阈值,以便界定离群值。偏差度高于这个阈值的所有集群被标记为离群值集群,它们的成员都是离群值。如上图中所示。如果设定阈值600,则Cluster3为离群值。 离群值与非离群值之间并没有明显的区别。实际上,用户必须指定一个阈值,以便界定离群值。偏差度高于这个阈值的所有集群被标记为离群值集群,它们的成员都是离群值。如上图中所示。如果设定阈值600,则Cluster3为离群值。

离群值与非离群值之间并没有明显的区别。实际上,用户必须指定一个阈值,以便界定离群值。偏差度高于这个阈值的所有集群被标记为离群值集群,它们的成员都是离群值。如上图中所示。如果设定阈值600,则Cluster3为离群值。

目前对离群值(Outlier)的判别与过滤主要采用两种方法:物理判别法和统计判别法。

- 物理判别法:根据人们对客观事物已有的认识来判别由于外界干扰、人为误差等原因造成实测数据值偏离正常结果。

- 统计判别法:给定一个置信概率,并确定一个置信限,凡是超过此限的误差我们就认为它不属于随机误差范围,将其视为异常值过滤。

通常面对样本时需要做整体数据观察,以确认样本数量、均值、极值、方差、标准差以及数据范围等。极值很可能是离群值,此时如何处理离群值会直接影响数据结果。

栗子:某一周的手机销售数据中,存在异常下单行为导致某一品类的销售额和转化率异常高。如果数据分析师选择忽视该情况,结论就是该手机非常热销抓紧供货,但实际情况并非如此。通常需要把会把离群值拿出来,单独做文字说明。

(4).统计指标的区别

数据统计的业务指标成百上千,根据不同目的选择合适的指标组合,就能实现说谎的效果。

我们都知道,平均数是表示一组数据集中趋势的量数,它是反映数据集中趋势的一项指标。解答平均数应用题的关键在于确定“总数量”以及和总数量对应的总份数。在统计工作中,平均数(均值)和标准差是描述数据资料集中趋势和离散程度的两个最重要的测度值。

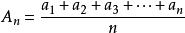

平均数在数学中可分为,算术平均数(arithmetic mean),几何平均数(geometric mean),调和平均数(harmonic mean),加权平均数(weighted average),平方平均数(quadratic mean)等。一般人大家所说的“平均数”就是算术平均数,即N个数字相加然后除以N。而“平均数”在统计学中包含三种:算术平均数、中位数、众数,都是用来描述数据平均水平的统计量。

- 算术平均数(Arithmetic mean):一组数据中所有数据之和再除以数据的个数。

- 中位数(Median):将所有数值从高到低排列,最中间的数值。

若有n个数,n为奇数,则选择第(n+1)/2个为中位数;若n为偶数,则中位数是(n/2以及n/2+1)的平均数。所以此例中位数为2.5。

- 众数(Mode):所有数字中出现频率最高的数值。

通过公式我们可以看出:算术平均数易受极端数据的影响。中位数不受分布数列的极大或极小值影响,在一定程度上对分布数列的具有代表性。但缺乏数字敏感性,有些离散型变量的单项式数列,当次数分布偏态时,中位数的代表性会受到影响。众数不受极端数据的影响,而且具有明显集中趋势点的数值,能够代表整组数据的一般水平。在这三个平均数中,算数平均数是能够取得最大数字的平均数,所以,一般的统计调查都用的是这个做结论,比如平均工资。所以有时候大家会发现自己的工资“被平均”了,或者拖后腿了就是这个原因。2013年北京月平均工资5223元

结论:对于不同的统计平均值的方法,得出的数据结论是不一样的。有太多人利用本来正确的统计数据来穿凿附会得出自己需要的结果,有些原始的统计数据往往是由权威机构或人士做出的,只是被其他人赋予了原调查目的之外的其他意义。 所以一般见到平均数后,首先查明使用的是哪种平均数计算方法,然后试着用另外两种分析一下,看看是否有破绽。

更多资料推荐:

Mind on Statistics (豆瓣)

统计学 (豆瓣)

Applied Multivariate Statistical Analysis (豆瓣)

三、数据可视化如何说谎

统计数据的表现方法千差万别。虽然数据相同,但表述方式不同,呈现的效果也不同。

(1).图表长宽

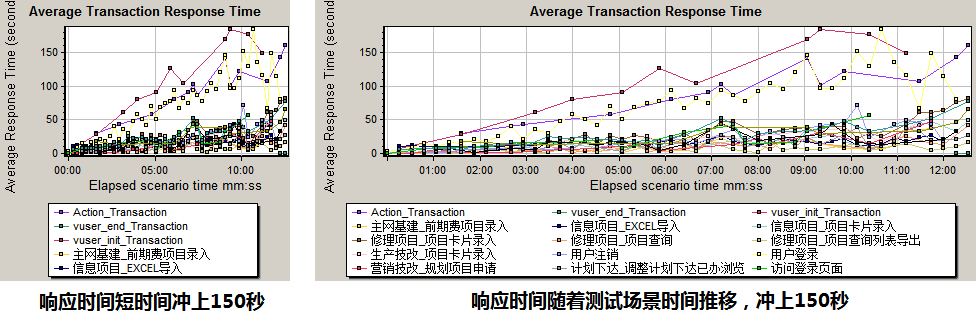

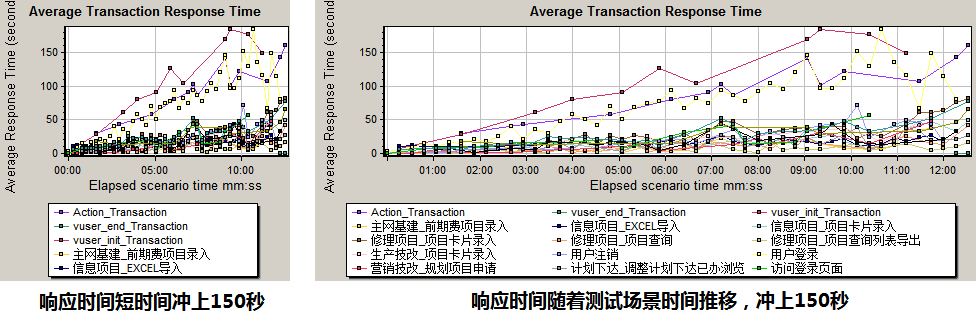

由《系统事务平均响应时间趋势图》可见,将图表的长宽比(长=横轴,宽=纵轴)从1:1拉伸到2:1后,数据发展趋势明显变缓。如果需要突出数据的爆发性增长,可以缩短时间间隔或记录次数(横坐标)。

由《系统事务平均响应时间趋势图》可见,将图表的长宽比(长=横轴,宽=纵轴)从1:1拉伸到2:1后,数据发展趋势明显变缓。如果需要突出数据的爆发性增长,可以缩短时间间隔或记录次数(横坐标)。 由《系统事务平均响应时间趋势图》可见,将图表的长宽比(长=横轴,宽=纵轴)从1:1拉伸到2:1后,数据发展趋势明显变缓。如果需要突出数据的爆发性增长,可以缩短时间间隔或记录次数(横坐标)。

由《系统事务平均响应时间趋势图》可见,将图表的长宽比(长=横轴,宽=纵轴)从1:1拉伸到2:1后,数据发展趋势明显变缓。如果需要突出数据的爆发性增长,可以缩短时间间隔或记录次数(横坐标)。- 左图暗示“系统事务平均响应时间在测试场景开始以后快速突破150秒”

- 右图暗示“系统事务平均响应时间随着测试场景执行时间延长逐渐增加”

(2).取值间隔

由上图可知,如果数据的取值间隔划分过大(等比数列1,10,100,1000,10000)而不是标准等差数列(1,2,3,4),则数据之间巨大差异会被缩小。

- 左图暗示“湖北、河南、江苏总产值排名前三远超其他省市”

- 右图暗示“各省市总产值相差并不太大”

(3).数据标准化

数据标准化也是归一化的过程。在数据分析之前通常需要先将数据标准化(Normalization),目的是去除奇异样本数据(相对于其他输入样本特别大或特别小的样本矢量),将数据按比例缩放,使之落入一个小的特定区间。或者去除数据的单位限制,将其转化为无量纲的纯数值,便于不同单位或量级的指标能够进行比较和加权,而且能保正程序运行时收敛加快。

如上图所示,正态分布中的各类分段方法。包括: Standard deviations, cumulative percentages, percentile equivalents, Z-scores, T-scores, standard nine, percent in stanine.(

如上图所示,正态分布中的各类分段方法。包括: Standard deviations, cumulative percentages, percentile equivalents, Z-scores, T-scores, standard nine, percent in stanine.( 如上图所示,正态分布中的各类分段方法。包括: Standard deviations, cumulative percentages, percentile equivalents, Z-scores, T-scores, standard nine, percent in stanine.(Standard score)

如上图所示,正态分布中的各类分段方法。包括: Standard deviations, cumulative percentages, percentile equivalents, Z-scores, T-scores, standard nine, percent in stanine.(Standard score)数据标准化常用方法有“Min-max”、“Z-score”、“Atan”和“Decimal scaling”等。

- Min-max标准化(Min-max normalization)

- Z-score 标准化(Zero-score normalization)

- Atan函数转换

使用这个方法需要注意的是如果想映射的区间为[0,1],则数据都应该大于等于0,小于0的数据将被映射到[-1,0]区间上。所以通过atan标准化会映射在区间【-1,1】上。

- 小数定标标准化(Decimal scaling)

一个简单的例子对比如下图所示:

了解更多:

- 数据可视化的优秀入门书籍有哪些?

- 数据可视化是让信息易读,还是更复杂?

- googlecode-birdeye

- Axiis : Data Visualization Framework

四、结束语

数据如同金矿,需要人使用工具来开采、提炼、加工。

所以数据不会说谎,使用数据的人才会说谎;有些人是无意,有些人是蓄意。

祝每一个DMer都挖掘到金矿和快乐:)

参考文献:

[1].维基百科Sampling (statistics)

[2].数据抽样方法(浙江大学《数据统计》)

[3].常见的“数据说谎”(TonySong,Webtrekk Business Consultant)

[4].融合过抽样和欠抽样的不平衡数据重抽样方法

[5].《Asking The Right Questions:A Guide to Critical Thinking:学会提问-批判性思维指南》

[6].《How to Lie with Statistics:统计数字会撒谎》

[7].《Big Data: Pitfalls, Methods and Concepts for an Emergent Fielde》

[8].primary data and secondary data

[9].性能测试中常见的loadrunner analysis误导

[10].《Data Mining: Concepts and Techniques》, Jiawei Han and Micheline Kamber

[11].Data Normalization and Standardization

- 数据分析中会常犯哪些错误,如何解决? 四

- 数据分析中会常犯哪些错误,如何解决的?

- 数据分析中会常犯哪些错误,如何解决? 一

- 数据分析中会常犯哪些错误,如何解决? 二

- 数据分析中会常犯哪些错误,如何解决? 三

- 数据分析中会常犯哪些错误,如何解决? 五

- 数据分析中会常犯哪些错误,如何解决? 六

- bug fixed 系列之四 : 内存错误分析解决

- 网站数据分析要分析哪些数据

- OSGI错误分析解决

- 502错误如何解决

- 如何解决段错误

- 数据分析的方法有哪些?

- 数据分析的步骤有哪些?

- 问卷数据分析方法都有哪些?

- 数据分析的步骤有哪些

- 数据分析的方法有哪些

- 分布式DB四问 1如何实现高效主键2如何解决分布式事务3如何解决数据扩容4如何进行高效的数据聚合?

- Java volatile

- Treeset根据值进行大小的排序

- 什么时候用C而不用C++

- Android中IDE、ADT、SDK、JDK、NDK的解释

- iOS设置启动图

- 数据分析中会常犯哪些错误,如何解决? 四

- 【命令】rm

- springmvc+bootstarp备份与恢复orcle10g数据库实现

- IE下判断IE版本的语句...[if lte IE 8]……[endif]

- 初探并查集

- android 的webview调用php服务器js , js 调用Android的webview

- 二叉树基础-由中根序列和后根序列重建二叉树(数据结构基础 第5周)

- laravel资源路由,控制器中的接收方式,详解

- 关于Fragment使用的一些见解