Hadoop:基于Pipes实现作业提交

来源:互联网 发布:手机淘宝上架图片尺寸 编辑:程序博客网 时间:2024/06/07 03:02

Hadoop入门教程:基于Pipes实现作业提交,在提交Hadoop Pipes作业之前首先需要将编译好的Pipes可执行程序上传到HDFS上。例如,我们将编译好的词频统计程序wordcount-simple上传到HDFS上的/user/nuoline/wordcount/bin目录下,如果wordcount-simple可执行程序就在当前目录下,则使用以下命令:

Hadoop fs -put wordcount-simple /user/nuoline/wordcount/bin

然后使用Hadoop Pipes命令提交作业到Hadoop集群,提交命令如下:

Hadoop pipes \

-D Hadoop.pipes.java.recordreader=true \

-D Hadoop.pipes.java.recordwriter=true \

-D MapRed.job.name= wordcount \

-input /user/nuoline/wordcount/test_input \

-output /user/nuoline/wordcount /test_output \

-program /user/nuoline/wordcount/bin/wordcount-simple

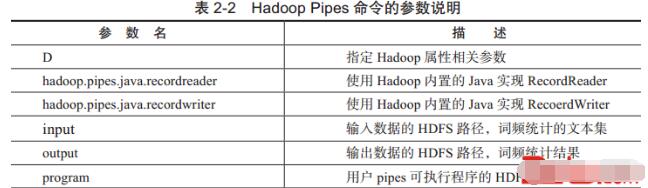

Hadoop Pipes命令的参数说明,如表2-2所示。

当然,如果用户需要自定义的Hadoop参数很多,还可以直接写成xml格式的配置文件,然后通过conf参数选项进行指定。例如可以在本地当前目录下建立一个wordcount_conf.xml文件,在此文件中指定相关Hadoop参数,执行代码如下:

<?xml version="1.0"?><conf?iguration> <property> // Set the binary path on HDFS <name>Hadoop.pipes.executable</name> <value>/user/nuoline/wordcount/bin/wordcount-simple</value> </property> <property> <name>Hadoop.pipes.java.recordreader</name> <value>true</value> </property> <property> <name>Hadoop.pipes.java.recordwriter</name> <value>true</value> </property></conf?iguration>然后通过Pipes命令的conf参数指定这个配置文件一起提交作业,执行命令如下:

hadoop pipes \

-conf /wordcount_conf.xml

-input /user/nuoline/wordcount/test_input

-output /user/nuoline/wordcount /test_output

来源:CUUG官网

- Hadoop:基于Pipes实现作业提交

- hadoop:基于Streaming实现作业提交

- Hadoop:Pipes接口实现

- hadoop C++ pipes 运行实现

- Hadoop Pipes

- Hadoop pipes

- hadoop c++ pipes接口实现

- Hadoop Pipes编程之C++实现WordCount

- hadoop 作业提交

- Hadoop作业提交分析

- Hadoop作业提交跟踪

- Hadoop作业提交解决

- Hadoop作业提交之客户端作业提交

- 基于Oozie实现MapReduce作业的自动提交功能

- 【Hadoop代码笔记】Hadoop作业提交之客户端作业提交

- hadoop之作业提交过程

- Hadoop 作业提交、查看、终止

- Hadoop作业提交终极解决

- Multiplication Table

- RESTful软件架构风格解疑

- 【HDU】5532 - Almost Sorted Array(LIS)

- Android 开始一个activity的同时保留导航

- Android 事件分发机制

- Hadoop:基于Pipes实现作业提交

- android删除私密信息

- 自适应前照明系统和夜视辅助系统

- android fragment 使用以及嵌套使用 底部菜单和顶部菜单

- IT创业疯魔史(读书笔记)

- HDU - 1728 - 逃离迷宫(dfs)

- 解决Android Webview 重定向无法 goback 的方法

- 听游记的景点介绍,语音和图文介绍,你听过这些景点吗?

- poj 3264 Balanced Lineup@