谷歌新 AI 实验室主管 Hugo 深度学习教程:神经网络、CV、NLP 难点解析

来源:互联网 发布:不用网络看电视的软件 编辑:程序博客网 时间:2024/05/22 10:59

谷歌新 AI 实验室主管 Hugo 深度学习教程:神经网络、CV、NLP 难点解析

11月22日,谷歌在蒙特利尔的现有办公室开设了一个全新的深度学习和人工智能研究小组。新团队将作为位于山景城的 Google Brain 团队的远程部门,由从 Twitter 深度学习部门出来的 Hugo Larochelle 领导。Hugo Larochelle 是 Yoshua Bengio的博士生,Geoffrey Hinton之前的博士后。本文是他主讲的神经网络教程,内容包括神经网络原理介绍、深度学习及应用层面的计算机视觉和自然语言处理等等,课程深入浅出,且全面系统,是不可多得的了解深度学习基础知识的优质材料。

11月22日,Hugo 宣布加入谷歌蒙特利尔人工智能研究小组。

【经典】Hugo Larochelle 深度学习讲课视频(时长 1 小时,建议在 WiFi 环境下观看)

课程介绍

第 0 周 引言和数学复习

总体概览:Hugo Larochelle 在Sherbrooke课程上使用的讲义

线性代数:吴恩达课程回顾

统计学:William Faris 的课程笔记第三章

抽样:Iain Murray的博士论文,第20-31页

第 1 周 前馈神经网络

主要内容:人造神经元、激活函数、单个神经元的能力、多层神经网络、神经网络的能力、生物学的启示。

第 2 周 训练神经网络

主要内容:经验风险最小化、损失函数、输出层梯度、隐藏层梯度、激活函数派生、参数梯度、反向传播、正则化、参数初始化、模型选择、优化。

第3周 条件随机场

主要内容:Motivation、直链CRF、文本窗口、计算分割函数、计算边际、执行分类、因子,有效统计和线性CRF,马尔科夫网络、因子图、信念传播(Belief Propagation)。

第4周 训练CRFs

主要内容:损失函数、一元log-factor 梯度、成对log-factor梯度、区分与生成学习、最大熵马尔科夫模型、隐藏马尔科夫模型、常规条件随机场、Pseudolikelihood

第5周 有限玻尔兹曼机器

主要内容:有限玻尔兹曼机器的定义、推理、自由能量、对比发散、对比发散(参数升级)、坚固的CD、例子、扩展。

第6周 自动编码器

主要内容:自动编码器的定义、损失函数、例子、线性自动编码器、未完成VS过完成隐藏层、去噪自动编码器、收缩自动编码器。

第7周 深度学习

主要内容:动机、训练的难度、非监督预训练、例子、漏失信息、深度自动编码器、深度信念网络、可变化的绑定、深度信念网络(DBN )预训练

第8周 稀疏编码

主要内容:定义、推理(ISTA 算法)、词典更新——映射梯度下降、词典更新——块调整下降、词学习算法、线上词学习算法、ZCA 预处理、特征提取、与V1的关系

第9周 计算机视觉

主要内容:动机、局部连接性、参数分享、离散卷积、池化与次抽样、卷积网络、物体识别、样本、数据集扩展、卷积RBM

第10周 自然语言处理

主要内容:动机、预处理、单次编码、词表征、语言建模、神经网络语言模型、分层的输出层、词标签、卷积网络、多任务学习、递归网络、合并表征、树表征、递归网络训练。

重点介绍,第7周:深度学习

1. 深度学习

主题:深度学习;分布式表征

深度学习,就是使用多层表征研究学习模型

多层(前馈)神经网络

多层图模型(深度信念网络,深度玻尔兹曼机)

每一层对应于一个分布式表征

每层中的单元并不是相互排斥的

可同时激活两个单元

它们对被区分开的(分串)输入不会有反应

在串中,输入只属于单一的串

深度学习从视觉皮质获得启发

主题:理论论证

一个深度架构可以代表特定的函数,但是在简洁性上却有指数级的进步。

一个例子:布尔函数

2. 训练的难度

为什么深度学习的训练很难?

第一个假设:优化更难(没有达到拟合)

梯度消失的问题

饱和单元会阻碍梯度传播

这是递归神经网络中的一个著名难题

第二个假设:过拟合

我们正在探索的,是一个带有复杂函数的空间

深度网络一般都有很多的参数

可能会存在于高变量/低偏见的情况下

解决方案:第一种情况,使用更好的优化;第二种情况,使用更好的正则化,非监督学习、随机训练。

3. 非监督预训练

使用非监督学习对隐藏层进行初始化

非监督式的预训练

第一层:找到隐藏层的特征,比起随机输入,训练后的输入中这些特征更加常见。

第二层:找到隐藏层中各种特征的结合点,这比随机隐藏层的特征更加常见。

第三层:找到结合中的结合……

调整:在所有的层都经过预训练后进行,这是一个监督式学习的过程。

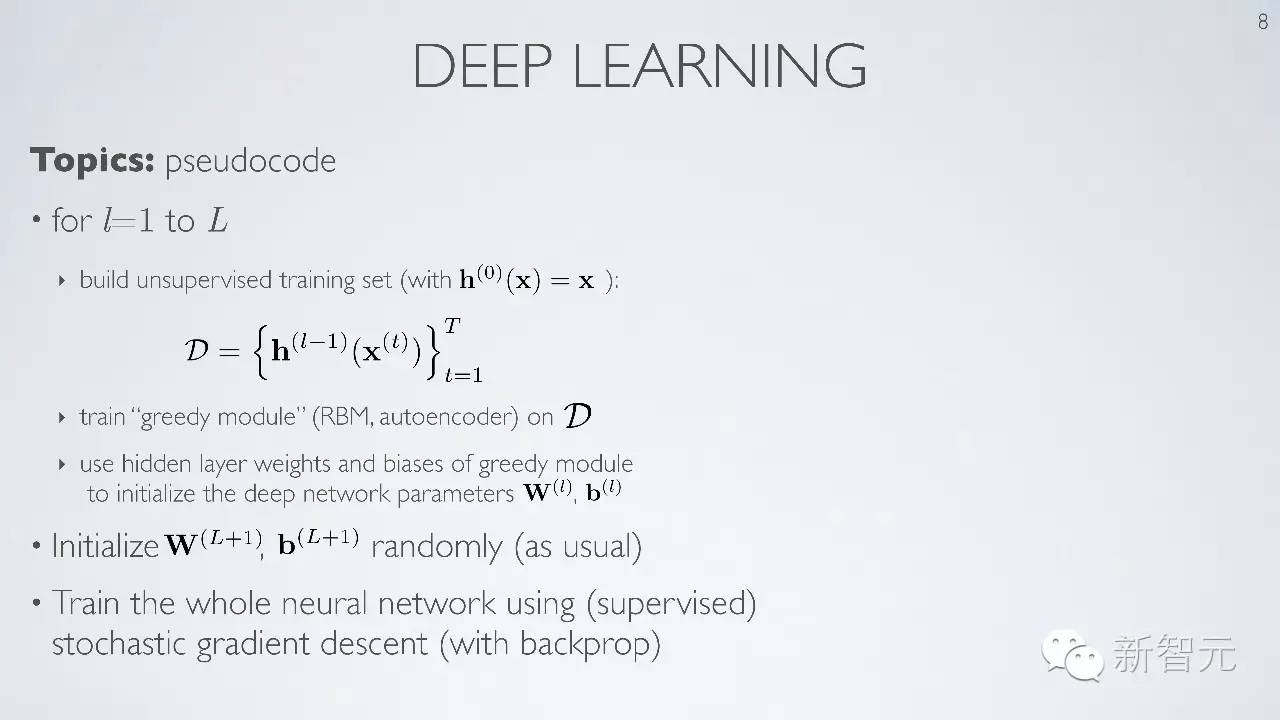

主题:伪代码

4. 深度学习原理解析

包含内容:预训练、调参、数据库等

假设:使用随机梯度下降来训练整个神经网络

5. Dropout

通过随机地一处隐藏单元,让神经网络“残废”

Dropout 概率值设定在0.5

主题:测试时间分类

6. 自动编码

预训练可用于对一个深度自动编码器进行初始化

7. 深度信念网络

可变绑定

神经网络层数的增加可以呈现递归性重复

现在可以把这一过程看成

调优由自上而下的算法完成

8. 可变绑定

9. 深度信念网络预训练

- 谷歌新 AI 实验室主管 Hugo 深度学习教程:神经网络、CV、NLP 难点解析

- 卷积神经网络CNN解析-针对斯坦福的深度学习教程

- deeplearning.ai之神经网络和深度学习

- 学习NLP,AI,Deep Learning 的牛逼的教程

- AI/DeepLearning NLP 教程地址

- AI(1)认知 人工智能、机器学习、神经网络、深度学习。

- NLP+VS︱深度学习数据集标注工具、图像语料数据库、实验室搜索ing...

- NLP+VS︱深度学习数据集标注工具、图像语料数据库、实验室搜索ing...

- NLP+VS︱深度学习数据集标注工具、图像语料数据库、实验室搜索ing...

- NLP+VS︱深度学习数据集标注工具、图像语料数据库、实验室搜索ing...

- 深度学习的难点

- NLP深度学习资源

- 经典书单 —— 语言/算法/机器学习/深度学习/AI/CV/PGM

- 神经网络解析和深度学习简介

- 百度深度学习实验室

- 机器学习语料,深度学习语料,神经网络语料,nlp语料,机器视觉语料,持续更新

- DeepLearning.ai学习笔记(一)神经网络和深度学习--Week3浅层神经网络

- DeepLearning.ai学习笔记(一)神经网络和深度学习--Week4深层神经网络

- 解决IDEA使用maven慢的问题

- BZOJ1042: [HAOI2008]硬币购物

- 分布式时序数据库InfluxDB

- [Struts2]<s:iterator>各种遍历用法

- 国内好的maven镜像仓库

- 谷歌新 AI 实验室主管 Hugo 深度学习教程:神经网络、CV、NLP 难点解析

- Leetcode Min Stack

- 股票入门基本知识5:通过交易方式选股

- web服务中三种发送接受协议SOAP/HTTP

- Android -- sp、wp智能指针的原理简介

- Visualizing GoogLeNet Classes[译]

- 设计模式-行为设计模式:观察者模式 Observer

- javascript 20161218

- (ZT)设置wifi热点的bat脚本