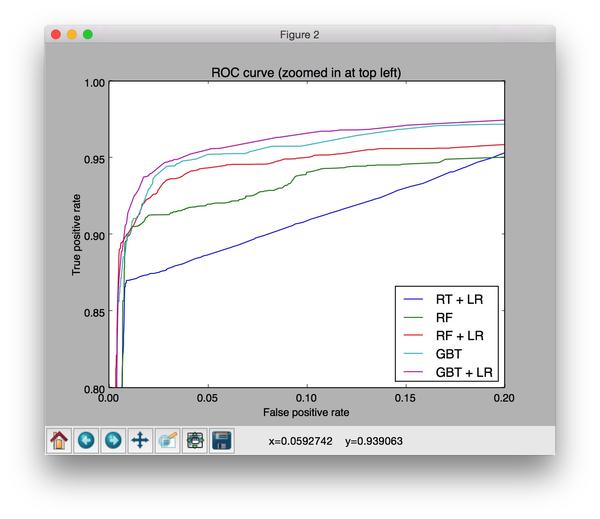

通过GBDT组合的特征作为LR的输入

来源:互联网 发布:和平网络电视频道地址 编辑:程序博客网 时间:2024/04/30 18:03

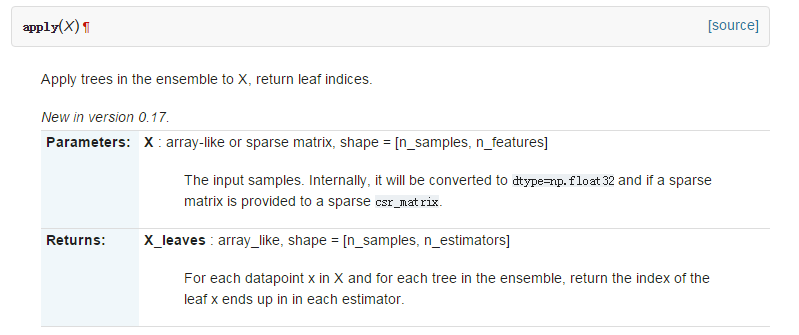

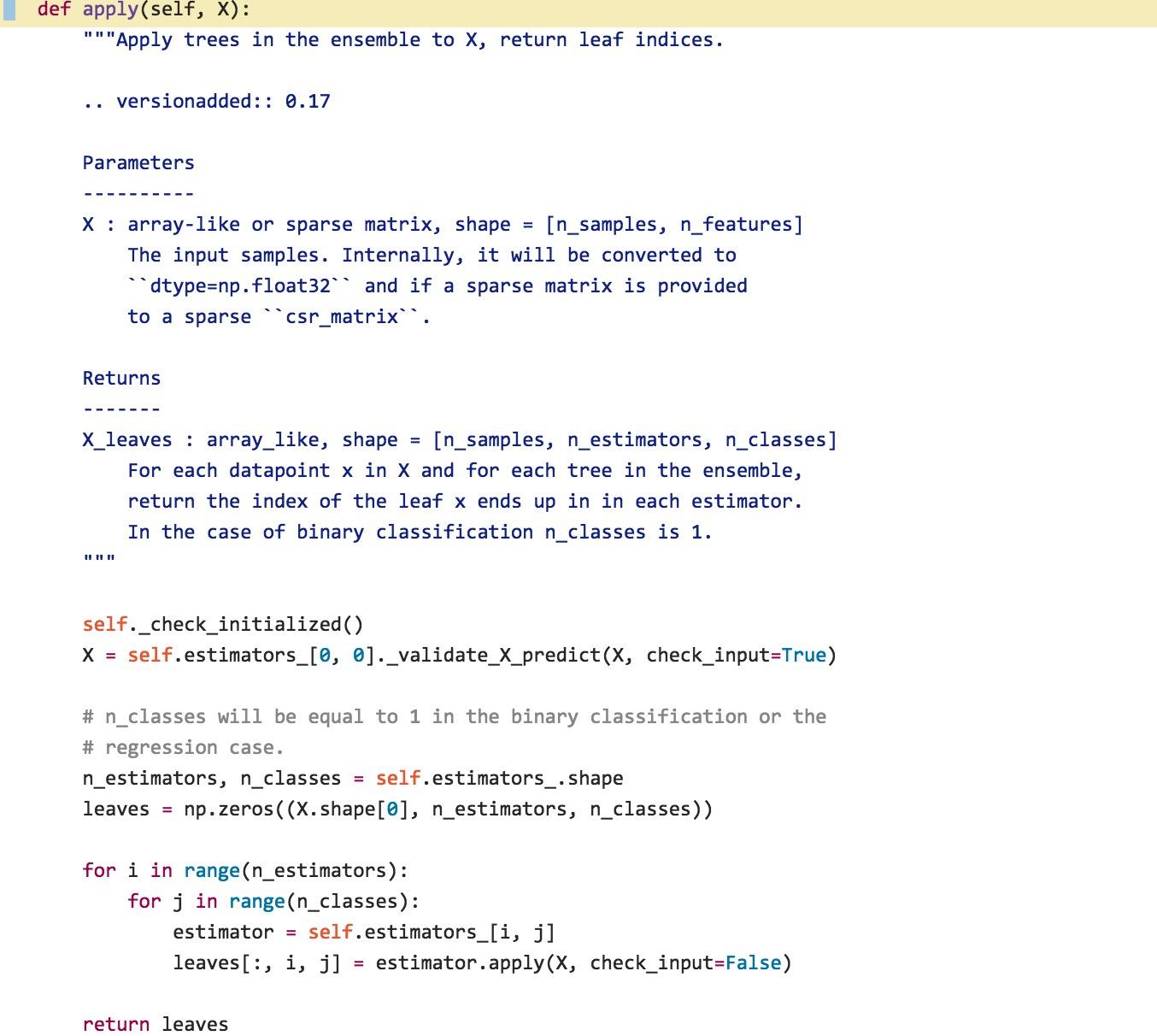

scikit-learn中的apply() 函数有什么作用?

0 0

- 通过GBDT组合的特征作为LR的输入

- GBDT+LR特征融合的例子

- GBDT基本理论及利用GBDT组合特征的具体方法(收集的资料)

- GBDT构建组合特征

- GBDT算法的特征重要度计算

- GBDT+LR

- GBDT+LR

- GBDT参考 (GBDT+LR)

- 特征组合可以提高LR分类效果

- GBDT原理及利用GBDT构造新的特征-Python实现

- GBDT原理及利用GBDT构造新的特征-Python实现

- scikit-learn的GBDT工具进行特征选取。

- 组合索引的特征[摘]

- XGBoost Plotting API以及GBDT组合特征实践

- XGBoost Plotting API以及GBDT组合特征实践

- XGBoost Plotting API以及GBDT组合特征实践

- 逻辑回归LR的特征为什么要先离散化

- 逻辑回归LR的特征为什么要先离散化

- 将博客搬至CSDN

- #OSG+VS#第五周

- SSL 字符串

- LintCode :最大数

- tomcat7 内存配置修改方法

- 通过GBDT组合的特征作为LR的输入

- java基础学习之设计模式 十七

- 两种“两数互换的方式”

- java HotSpot虚拟机垃圾回收优化(一、Introduction)

- @TransactionConfiguration过时与替代写法

- computer-database 项目需求提测

- 使用asm.jar将Android手机屏幕投影到电脑

- 116. Populating Next Right Pointers in Each Node(unsolved)

- 关于typedef的用法小结