张量初步学习

来源:互联网 发布:pyqt5 tabwidget数据 编辑:程序博客网 时间:2024/05/18 13:26

内容来源于:张量百科 张量分解

张量(tensor)理论是数学的一个分支学科,在力学中有重要应用。张量这一术语起源于力学,它最初是用来表示弹性介质中各点应力状态的,后来张量理论发展成为力学和物理学的一个有力的数学工具。张量之所以重要,在于它可以满足一切物理定律必须与坐标系的选择无关的特性。张量概念是矢量概念的推广,矢量是一阶张量。张量是一个可用来表示在一些矢量、标量和其他张量之间的线性关系的多线性函数。

张量(Tensor)是一个定义在的一些向量空间和一些对偶空间的笛卡儿积上的多重线性映射,其坐标是|n|维空间内,有|n|个分量的一种量, 其中每个分量都是坐标的函数, 而在坐标变换时,这些分量也依照某些规则作线性变换。r 称为该张量的秩或阶(与矩阵的秩和阶均无关系)在同构的意义下,第零阶张量 (r = 0) 为标量 (Scalar),第一阶张量 (r = 1) 为向量 (Vector), 第二阶张量 (r = 2) 则成为矩阵 (Matrix)

在数学里,张量是一种几何实体,或者说广义上的“数量”。张量概念包括标量、向量和线性算子。张量可以用坐标系统来表达,记作标量的数组,但它是定义为“不依赖于参照系的选择的”。张量在物理和工程学中很重要。例如在扩散张量成像中,表达器官对于水的在各个方向的微分透性的张量可以用来产生大脑的扫描图。可能最重要的工程上的例子就是应力张量和应变张量了,它们都是二阶张量,对于一般线性材料他们之间的关系由一个四阶弹性张量来决定。虽然张量可以用分量的多维数组来表示,张量理论存在的意义在于进一步说明把一个数量称为张量的涵义,而不仅仅是说它需要一定数量的有指标索引的分量。特别是,在坐标转换时,张量的分量值遵守一定的变换法则。张量的抽象理论是线性代数分支,现在叫做多重线性代数。

张量分解-CP分解 2016.06.19

CP分解(Canonical Polyadic Decomposition)

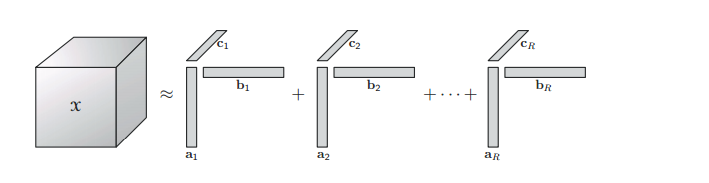

1927年Hitchcock提出了CP 分解。CP 分解将一个

张量的低秩近似

在矩阵中定义最小的秩为1的矩阵和的个数为矩阵的秩,类似于矩阵的定义,

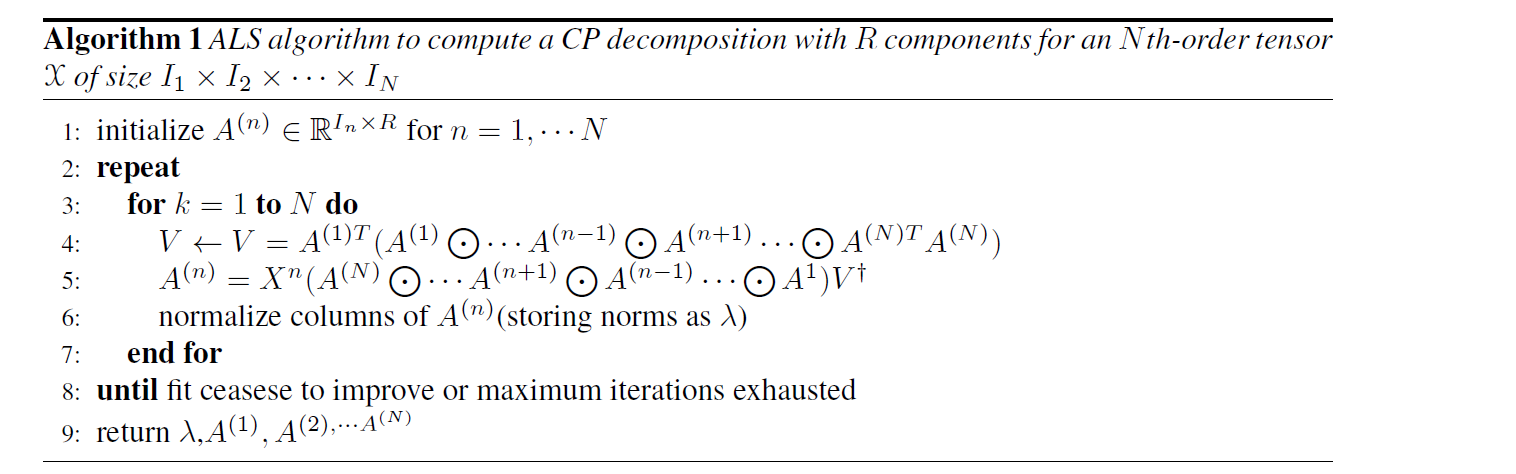

CP的求解

CP分解的求解首先要确定分解的秩1张量的个数,正如前面介绍的由于张量的秩Rank-n 近似无法渐进地得到。通常我们通过迭代的方法对

假设

可加约束

在一些应用中,为了使得CP分解更加的鲁棒和精确,可以在分解出的因子上加上一些先验知识即约束。比如说平滑约束(smooth)、正交约束、非负约束(nonegative) 、稀疏约束(sparsity)等。

CP分解应用

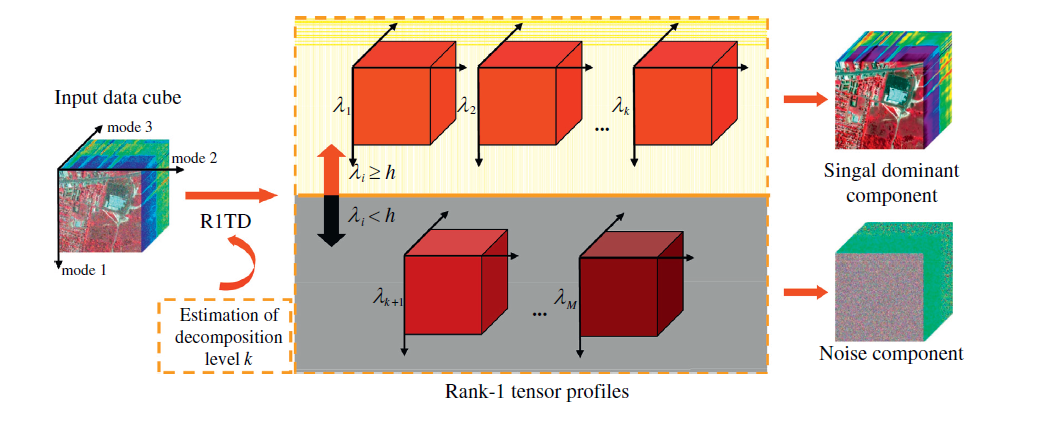

CP分解已经在信号处理,视频处理,语音处理,计算机视觉、机器学习等领域得到了广泛的应用 下面,以去噪为例,对CP分解在高光谱图像处理中的应用进行阐述。

高光谱图像(HSI)是上个世纪80年代以来新兴的一种新型成像技术,它包括了可见光和不可见光范围的几十到几百个连续光谱窄波段构成,形成了一种数据立方体结构的图像。高光谱图像可以看作是一个三阶张量,图像的空间域和光谱域构成了数据的三个维度。采用低秩CP分解对高光谱图像去噪认为低秩的部分是无噪声的部分,剩下的部分认为是噪声数据,它的示意图如下图所示。 从图中可以看到一个高光谱图像数据

从图中可以看到一个高光谱图像数据

- 张量初步学习

- 张量分解论文学习

- 张量

- 张量

- 【DL--03】深度学习基本概念—张量

- pytorch学习笔记(1)--pytorch张量

- AI学习之路(8): 定义张量变量

- AI学习之路(9): 张量的常量1

- AI学习之路(10): 张量的常量2

- AI学习之路(11): 创建随机张量1

- AI学习之路(12): 创建随机张量2

- AI学习之路(13): 创建随机张量3

- AI学习之路(14): 张量的平方计算

- 线性代数学习1 标量、向量、矩阵和张量

- Tensorflow实战学习(四)【张量表示、类型、形状、计算】

- 初步学习

- 初步学习

- Lit-张量

- oracle用户信息

- iOS不使用__block修改Block中的局部变量<指针篇>

- react-native里TextInput遇到的一些问题及解决方案

- JAVA线程池应用的DEMO

- unicode Ascii gbk字符集和utf-8 utf-16编码

- 张量初步学习

- 同一tomcat下实现多应用session共享 单点登录

- Linux C语言编程-Linux网络通信--Linux上使用套接字(socket)来处理信息---编写一个单进程非阻塞多客户的套接字客户端

- Mysql数据库锁-表级锁分析

- NOIP 2006 提高组 复赛 digital 2k 进制数

- numpy的linalg模块

- 【Shell】-- 入门笔记(1) : 变量、字符串、数组、参数及基本运算符

- 继承

- Ubuntu server 安装CUDA 8.0