如何在windows下安装配置pyspark notebook

来源:互联网 发布:java 线程死锁 编辑:程序博客网 时间:2024/05/16 15:25

如何在windows下安装配置pyspark notebook

第一步:安装anaconda

anaconda自带一系列科学计算包

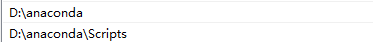

接着配置环境变量:如我安装在D盘下

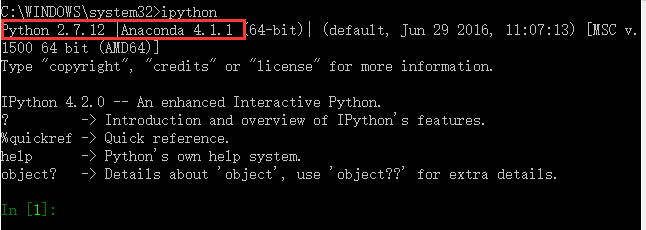

试一下命令行启动,确保ipython从anaconda启动

第二步:安装spark(需要提前安装JDK)

到官网下载spark安装包

http://spark.apache.org/downloads.html

我下的是这个版本:

解压缩之后,不要忘记添加环境变量

SPARK_HOME=E:\spark

path=%SPARK_HOME%\bin

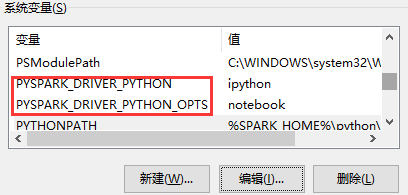

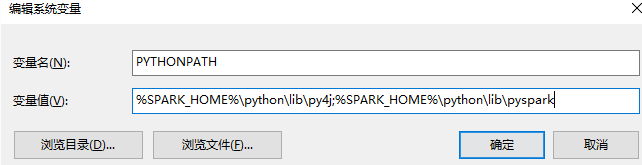

配置如下系统变量

接着需要在命令行键入(spark安装目录下:如D:\spark) > sbt package 进行编译

sbt下载与安装(不知道是否必须要)

下载地址:http://www.scala-sbt.org/0.13/docs/zh-cn/Installing-sbt-on-Windows.html

配置sbt环境变量

这一步很重要 拷贝 E:\spark\python\pyspark 到 D:\anaconda\Lib\site-packages 目录下

第三步:修改spark\conf下的spark-env文件(不知道是否必要)

加入如下三行

export PYSPARK_PYTHON=/D:/anaconda

export PYSPARK_DRIVER_PYTHON=/D:/anaconda

export PYSPARK_SUBMIT_ARGS='--master local[*]'

第四步:启动pyspark

发现已启动成功,一般网页会自动打开http://localhost:8888/tree#

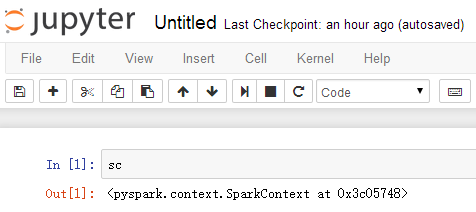

第五步:测试sc

成功!

- 如何在windows下安装配置pyspark notebook

- 在pyspark上配置ipython notebook

- window 下 notebook 中的 pyspark安装

- 在win7下配置pyspark在jupyter notebook中使用的简单方法

- 如何在win 下安装ipython notebook

- 在windows下用pip安装pyspark出错

- [pySpark][笔记]spark tutorial from spark official site在ipython notebook 下学习pySpark

- Windows环境下TensorFlow的安装及如何在Jupyter Notebook中使用TensorFlow

- Windows, Ubuntu 下 Numpy, Scipy, matplotlib, jupyter notebook 安装配置

- windows下安装jupyter notebook

- pySpark 在windows下环境搭建

- 如何在win7 64下安装ipython notebook

- 如何在win7 64下安装ipython notebook

- Windows 下 jupyter notebook自定义配置

- windows下ipython notebook安装常见问题

- windows下安装ipython和jupyter notebook

- 新手如何在Windows xp 下安装并配置Memcached

- 在windows系统下如何安装和配置phpMyAdmin

- SpringBoot项目在IntelliJ IDEA中实现热部署

- SQL Server之存储过程基础知识

- 第十四周

- s3c2440 SDRAM实验

- Echart的angularjs封装

- 如何在windows下安装配置pyspark notebook

- 更改Visual Studio 的主题设置

- 观察者模式【Observer Pattern】

- 水果消除(DPS)

- python 爬虫动态加载网站

- 第2章 在 HTML 中使用 JavaScript <script>元素

- 自定义MVC

- 51单片机之定时器

- json字符串与java对象互转