对不同激活函数在神经网络中的比较分析

来源:互联网 发布:用js写满天闪烁的星星 编辑:程序博客网 时间:2024/05/29 11:42

针对当下几种神经网络中的激活函数进行比较对比。

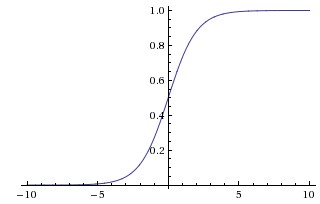

sigmoid激活函数

表达式为

其优点为:

求导方便,

σ′(x)=σ(x)(1−σ(x)) ;结果具有很好的解释性,因为其值域范围只在0到1之间,因此可以解释为概率。

缺点为:

- 太容易饱和了,因为在

σ(x) 接近0或1时,导数几乎为0。因此会导致收敛速度较慢。特别地,当初始化权值过大时,在开始阶段就会饱和,从而无法迭代更新; - 当输入为0时,结果不为0。我们更希望当输入为0时,输出也为0。

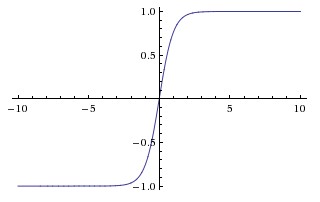

tanh激活函数

表达式为

其优点为:

- 求导也相对容易,

tanh′(x)=1−tanh2(x) ; - 是奇函数,也就是当输入为0时,输出也为0。

缺点为:

- 存在和sigmoid函数同样的饱和问题。

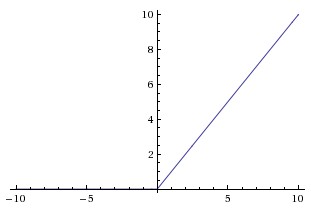

ReLU函数

表达式为

其优点为:

- 函数表达式求导都特别简单,

f′(x)=

阅读全文

0 0

- 对不同激活函数在神经网络中的比较分析

- 神经网络激活函数比较

- 激活函数在神经网络中的功能

- 神经网络中的激活函数

- 神经网络中的激活函数

- 神经网络中的激活函数

- 神经网络中的激活函数

- 神经网络中激活函数比较

- 4用于cifar10的卷积神经网络-4.17cifar10卷积网络在不同激活函数下的性能分析

- 浅析神经网络中的激活函数

- 神经网络中的各种激活函数

- 理解激活函数在神经网络模型构建中的作用

- 神经网络不同激活函数比较--读《Understanding the difficulty of training deep feedforward neural networks》

- 深度学习:神经网络中的激活函数

- CS231n课程笔记5.1:神经网络历史&激活函数比较

- 神经网络激活函数

- 神经网络-激活函数

- 神经网络激活函数链接

- 这也许是最具珍藏价值的Oracle DBA生存宝典!

- Idea Maven项目搭建spring 框架

- 初识monkeyrunner

- Java方法

- 6数据库的连接

- 对不同激活函数在神经网络中的比较分析

- php 冒泡排序&快速排序

- mybatis+ehcache走过的坑

- LaTeX Error: Unknown graphics extension: .eps 处理

- laravel 5.4 composer 安装心的

- nova 热迁移卷 的关键代码 rebase说明

- 03:基因相关性(1.7编程基础之字符串)

- 图解JVM内存结构及内存/栈溢出原因解析

- TurboPixels: Fast Superpixels Using Geometric Flows